Autor: 0xjacobzhao | https://linktr.ee/0xjacobzhao

Dieser unabhängige Bericht wird von IOSG Ventures unterstützt. Vielen Dank an Hans (RoboCup Asien-Pazifik), Nichanan Kesonpat (1kx), Robert Koschig (1kx), Amanda Young (Collab+Currency), Jonathan Victor (Ansa Research), Lex Sokolin (Generative Ventures), Jay Yu (Pantera Capital), Jeffrey Hu (Hashkey Capital) für die wertvollen Anregungen zu diesem Artikel. Während des Schreibprozesses wurden auch Rückmeldungen von den Projektteams von OpenMind, BitRobot, peaq, Auki Labs, XMAQUINA, GAIB, Vader, Gradient, Tashi Network und CodecFlow eingeholt. Der Artikel bemüht sich um objektive und präzise Inhalte, einige Ansichten basieren jedoch auf subjektiven Einschätzungen, was unvermeidlich zu Abweichungen führen kann. Wir bitten die Leser um Verständnis.

I. Panorama der Robotik: Von industrieller Automatisierung zu humanoider Intelligenz

Die traditionelle Robotik-Wertschöpfungskette hat sich zu einem vollständigen hierarchischen System von unten nach oben entwickelt, das die vier Hauptschritte umfasst: Kernkomponenten – mittlere Steuerungssysteme – vollständige Maschinenherstellung – Anwendungsintegration. Die Kernkomponenten (Controller, Servos, Getriebe, Sensoren, Batterien usw.) haben die höchsten technologischen Barrieren, die die Leistung und die Kostenobergrenze der gesamten Maschine bestimmen; das Steuerungssystem ist das "Gehirn und das Kleinhirn" des Roboters, verantwortlich für Entscheidungsfindung, Planung und Bewegungssteuerung; die Herstellung der gesamten Maschine spiegelt die Integrationsfähigkeit der Lieferkette wider. Systemintegration und Anwendungen bestimmen die Tiefe der Kommerzialisierung und werden zum neuen Wertkern.

Nach Anwendungsszenarien und -formen entwickelt sich die globale Robotik entlang des Pfades "industrielle Automatisierung → Szenenintelligenz → universelle Intelligenz" und bildet fünf Haupttypen: Industrieroboter, mobile Roboter, Serviceroboter, Spezialroboter und humanoide Roboter.

Industrieroboter (Industrial Robots): Derzeit die einzige umfassend entwickelte Kategorie mit breiter Anwendung in Schweiß-, Montage-, Beschichtungs- und Transportprozessen. Die Branche hat ein standardisiertes Lieferkettensystem gebildet, stabile Gewinnmargen und eine klare ROI. Die Unterkategorie der kollaborativen Roboter (Cobots) betont die menschliche Zusammenarbeit, ist leicht zu installieren und wächst am schnellsten. Repräsentative Unternehmen: ABB, Fanuc, Yaskawa, KUKA, Universal Robots, JAKA, AUBO.

Mobile Roboter (Mobile Robots): Dazu gehören AGV (automatische geführte Fahrzeuge) und AMR (autonome mobile Roboter), die in den Bereichen Logistik, E-Commerce und Fertigungstransport großflächig eingesetzt werden und die am weitesten verbreitete Klasse im B2B-Bereich sind. Repräsentative Unternehmen: Amazon Robotics, Geek+, Quicktron, Locus Robotics.

Serviceroboter (Service Robots): Zielen auf Branchen wie Reinigung, Gastronomie, Hotellerie und Bildung ab und sind das am schnellsten wachsende Segment im Verbrauchermarkt. Reinigungsprodukte haben bereits die Logik der Verbraucherelektronik erreicht, während medizinische und kommerzielle Lieferungen die Kommerzialisierung beschleunigen. Zudem sind eine Reihe von allgemeineren, operationellen Robotern auf dem Vormarsch (z.B. Dyna's Dual-Arm-System) – flexibler als spezialisierte Produkte, jedoch noch nicht auf die Universalisierung humanoider Roboter abgestimmt. Repräsentative Unternehmen: Ecovacs, Roborock, PuduTech, Qianlong Smart, iRobot, Dyna usw.

Spezialroboter, die primär für medizinische, militärische, Bau-, maritime und Raumfahrtanwendungen eingesetzt werden, haben einen begrenzten Markt, jedoch hohe Gewinnmargen und starke Barrieren, häufig abhängig von Regierungs- und Unternehmensaufträgen und befinden sich im vertikalen Wachstumsstadium. Typische Projekte sind Intuitive Surgical, Boston Dynamics, ANYbotics, NASA Valkyrie usw.

Humanoide Roboter (Humanoid Robots): Werden als zukünftige "universelle Arbeitskräfteplattform" angesehen. Vertretende Unternehmen sind Tesla (Optimus), Figure AI (Figure 01), Sanctuary AI (Phoenix), Agility Robotics (Digit), Apptronik (Apollo), 1X Robotics, Neura Robotics, Unitree, UBTECH, ZhiYuan Robotics usw.

Humanoide Roboter sind derzeit das am meisten beachtete vorderste Segment, deren Kernwert darin liegt, dass sie mit ihrer menschenähnlichen Struktur den bestehenden sozialen Raum anpassen und als Schlüsselgestalt in Richtung "universelle Arbeitskräfteplattform" angesehen werden. Im Gegensatz zu industriellen Robotern, die extremste Effizienz anstreben, betonen humanoide Roboter allgemeine Anpassungsfähigkeit und Aufgabenmigration und können in Fabriken, Haushalten und öffentlichen Räumen arbeiten, ohne die Umgebung umzubauen.

Derzeit befinden sich die meisten humanoiden Roboter noch in der Phase der technologischen Demonstration, in der hauptsächlich dynamische Balance, Gehen und Handlungsfähigkeiten überprüft werden. Obwohl bereits einige Projekte mit begrenzten Bereitstellungen in hoch kontrollierten Fabrikumgebungen (wie Figure × BMW, Agility Digit) begonnen haben und ab 2026 mit weiteren Anbietern (wie 1X) gerechnet wird, sind dies immer noch "eng begrenzte, einseitige" Anwendungen und keine vollwertige Umsetzung eines universellen Arbeitskräftemodells. Insgesamt gesehen wird es noch mehrere Jahre dauern, bis die kommerzielle Skalierung erreicht wird. Die zentralen Engpässe sind: Mehrfreiheitsgrad-Koordination und Herausforderungen bei der Echtzeit-Dynamikbalance; Energieverbrauch und Reichweitenprobleme, die durch die Dichte und Effizienz der Batteriespeicher begrenzt sind; in offenen Umgebungen leicht instabil und schwer verallgemeinbar, die Wahrnehmungs-Entscheidungs-Kette; erhebliche Datenlücken (schwierig, um universelle Strategie-Training zu unterstützen); interkulturelle Migration ist noch nicht überwunden; und die Kostenkurve und Lieferkette für Hardware (insbesondere außerhalb Chinas) stellen weiterhin reale Hürden dar, die die Erreichung von großangelegten, kostengünstigen Bereitstellungen weiter erschweren.

Die zukünftige Kommerzialisierungspfad wird voraussichtlich drei Phasen durchlaufen: Kurzfristig dominiert Demo-as-a-Service, abhängig von Pilotprojekten und Subventionen; mittelfristig entwickelt sich Robotics-as-a-Service (RaaS), um ein Ökosystem für Aufgaben und Fähigkeiten aufzubauen; langfristig liegt der Schwerpunkt auf Arbeitskräften in der Cloud und intelligenten Abonnements, um den Wertschwerpunkt von der Hardwareherstellung auf Software- und Dienstleistungsnetzwerke zu verlagern. Insgesamt befindet sich die humanoide Robotik in einer entscheidenden Übergangsphase von der Demonstration zum selbstlernenden Zustand. Ob es gelingt, die drei Hürden von Kontrolle, Kosten und Algorithmen zu überwinden, wird entscheiden, ob sie verkörperte Intelligenz wirklich verwirklichen kann.

II. KI × Robotik: Die Morgenröte der verkörperten Intelligenz

Traditionelle Automatisierung beruht hauptsächlich auf prädestinierten und fließbandartigen Kontrollen (wie Wahrnehmung-Planung-Kontrolle der DSOP-Architektur) und kann nur in strukturierten Umgebungen zuverlässig funktionieren. Die reale Welt ist jedoch komplexer und variabler, und die nächste Generation verkörperter Intelligenz (Embodied AI) verfolgt einen anderen Paradigmenwechsel: Durch große Modelle und einheitliches Repräsentationslernen sollen Roboter die Fähigkeit zur "Verständnis-Vorhersage-Handlung" über verschiedene Szenarien hinweg entwickeln. Verkörperte Intelligenz betont die dynamische Kopplung von Körper (Hardware) + Gehirn (Modell) + Umgebung (Interaktion), wobei Roboter das Trägermedium sind und Intelligenz das Kernstück.

Generative KI (Generative AI) gehört zur intelligenten Welt der Sprache, die besonders gut darin ist, Symbole und Semantiken zu verstehen; verkörperte Intelligenz (Embodied AI) gehört zur intelligenten Welt der Realität, die Wahrnehmung und Handeln beherrscht. Beide entsprechen dem "Gehirn" und dem "Körper" und repräsentieren zwei parallele Hauptlinien der KI-Evolution. Aus einer intellektuellen Perspektive ist verkörperte Intelligenz höher als generative KI, jedoch ist ihre Reife noch deutlich hinterher. LLMs basieren auf einem riesigen Korpus von Daten im Internet, die einen klaren Kreislauf von "Daten → Rechenleistung → Bereitstellung" bilden; hingegen müssen Roboter "Daten" über Interaktionen mit der physischen Welt "schaffen" – dazu gehören Trajektorien von Fernsteuerungen, Videos aus der Ich-Perspektive, räumliche Karten, Aktionssequenzen usw. Diese Daten existieren nicht natürlich und müssen durch echte Interaktionen oder hochrealistische Simulationen generiert werden, wodurch sie seltener und kostspieliger werden. Obwohl simulierte und synthetisierte Daten hilfreich sind, können sie die echten Sensoren und Bewegungserfahrungen nicht ersetzen. Das ist der Grund, warum Unternehmen wie Tesla und Figure ihre eigenen Datenfabriken zur Fernbedienung aufbauen mussten und warum in Südostasien Drittanbieter-Datenmarkierungsfabriken entstehen. Kurz gesagt: LLMs lernen aus vorhandenen Daten, während Roboter durch Interaktionen mit der physischen Welt "Daten" "schaffen" müssen. In den nächsten 5–10 Jahren werden beide tiefgreifend im Vision–Language–Action-Modell und in der Architektur von verkörperten Agenten integriert – LLMs sind für hohe kognitive Fähigkeiten und Planung zuständig, während Roboter die Ausführung in der realen Welt übernehmen und einen bidirektionalen Kreislauf von Daten und Handlungen fördern, um die KI von "sprachlicher Intelligenz" zu echtem allgemeinen Wissen (AGI) weiterzuentwickeln.

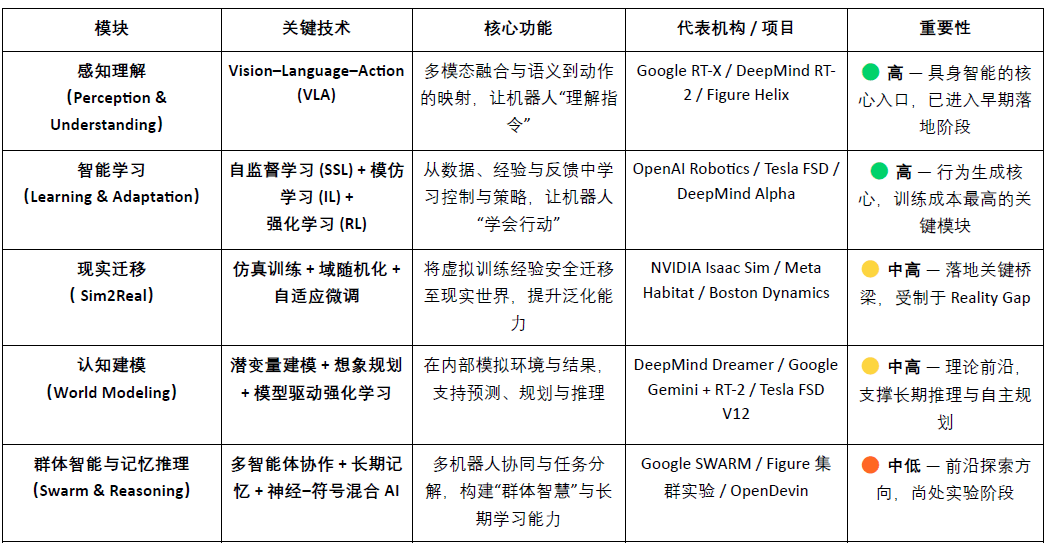

Das Kerntechnologiesystem der verkörperten Intelligenz kann als ein intelligenter Stack von unten nach oben betrachtet werden: VLA (Wahrnehmungsfusion), RL/IL/SSL (intelligentes Lernen), Sim2Real (realitätsübergreifende Migration), Weltmodell (kognitive Modellierung) sowie Multi-Agenten-Kooperation und Gedächtnis-Schlussfolgerung (Schwarm- & Schlussfolgerung). Hierbei sind VLA und RL/IL/SSL die "Motoren" der verkörperten Intelligenz, die deren Umsetzung und Kommerzialisierung bestimmen; Sim2Real und das Weltmodell sind die Schlüsseltechnologien, die virtuelles Training und reale Ausführung verbinden; die Kooperation von Multi-Agenten und Gedächtnis-Schlussfolgerung steht für die evolutionäre Entwicklung höherer kollektiver und metakognitiver Fähigkeiten.

Wahrnehmungsverstehen: Modell der visuellen Sprache-Aktion (Vision-Language-Action)

Das VLA-Modell integriert die drei Kanäle Visuelle (Vision) – Sprache (Language) – Aktion (Action), sodass Roboter die Absichten aus menschlicher Sprache verstehen und in konkrete Handlungen umwandeln können. Der Ausführungsprozess umfasst semantische Analyse, Zielidentifikation (Zielobjekte aus visuellen Eingaben lokalisieren) sowie Pfadplanung und Aktionsausführung, um den geschlossenen Kreislauf "Verstehen von Semantik – Wahrnehmen der Welt – Erledigen von Aufgaben" zu erreichen, was einen der entscheidenden Durchbrüche der verkörperten Intelligenz darstellt. Aktuelle repräsentative Projekte sind Google RT-X, Meta Ego-Exo und Figure Helix, die jeweils fortschrittliche Richtungen wie multimodales Verständnis, immersive Wahrnehmung und sprachgesteuerte Kontrolle demonstrieren.

Allgemeine Architektur des Vision-Language-Action-Modells

Derzeit befindet sich VLA noch in einem frühen Stadium und sieht sich vier zentralen Engpässen gegenüber:

1) Semantische Mehrdeutigkeit und schwache Aufgabengeneralisierung: Modelle haben Schwierigkeiten, vage und offene Anweisungen zu verstehen;

2) Visuelle und motorische Ausrichtung ist instabil: Wahrnehmungsfehler werden in der Pfadplanung und Ausführung verstärkt;

3) Multimodale Daten sind selten und nicht einheitlich standardisiert: Die Erfassungs- und Markierungskosten sind hoch und es ist schwierig, einen skalierbaren Datenzyklus zu bilden;

4) Herausforderungen bei der Zeit- und Raumachse langer Aufgaben: Zu lange Aufgaben führen zu unzureichender Planungs- und Gedächtnisfähigkeit, während ein zu großes räumliches Spektrum erfordert, dass das Modell Dinge außerhalb des "Sichtfelds" schlussfolgern muss. Derzeit fehlt VLA ein stabiles Weltmodell und die Fähigkeit zur räumlichen Schlussfolgerung.

Diese Probleme schränken gemeinsam die Fähigkeit von VLA ein, über verschiedene Szenen zu verallgemeinern und eine skalierbare Umsetzung zu erreichen.

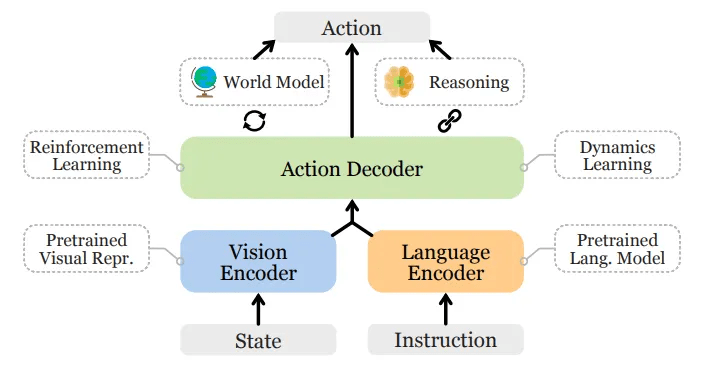

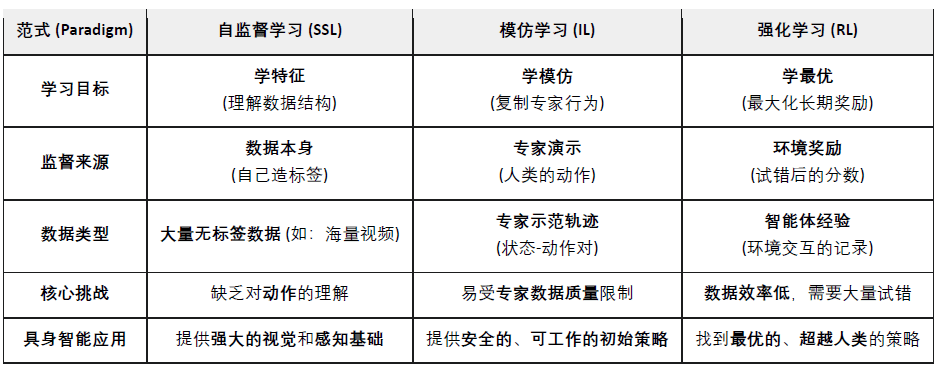

Intelligentes Lernen: Selbstüberwachtes Lernen (SSL), Imitationslernen (IL) und Verstärkungslernen (RL)

Selbstüberwachtes Lernen (Self-Supervised Learning): Automatisches Extrahieren semantischer Merkmale aus Wahrnehmungsdaten, um Robotern zu helfen, die "Welt" zu verstehen. Im Wesentlichen lernen Maschinen zu beobachten und darzustellen.

Imitationslernen (Imitation Learning): Durch Nachahmung menschlicher Demonstrationen oder Expertenbeispiele können grundlegende Fähigkeiten schnell erlernt werden. Im Wesentlichen lernen Maschinen, wie Menschen zu handeln.

Verstärkungslernen (Reinforcement Learning): Durch ein "Belohnung-Bestrafung"-System optimiert der Roboter seine Aktionsstrategien durch ständige Versuche und Irrtümer. Im Wesentlichen lernen Maschinen, durch Versuch und Irrtum zu wachsen.

In verkörperter Intelligenz (Embodied AI) zielt selbstüberwachtes Lernen (SSL) darauf ab, Robotern zu ermöglichen, durch Wahrnehmungsdaten Zustandsänderungen und physikalische Gesetze vorherzusagen, um die kausale Struktur der Welt zu verstehen; verstärkendes Lernen (RL) ist der zentrale Antrieb zur Bildung von Intelligenz, indem es durch Interaktionen mit der Umgebung und belohnungsbasiertes Trial-and-Error-Optimierung Roboter dazu bringt, komplexe Verhaltensweisen wie Gehen, Greifen und Hindernisvermeidung zu erlernen; Imitationslernen (IL) beschleunigt diesen Prozess durch menschliche Demonstrationen, sodass Roboter schnell eine Handlungsvorabnahme erhalten. Derzeit ist es das Hauptziel, diese drei Ansätze zu kombinieren, um einen hierarchischen Lernrahmen zu schaffen: SSL bietet die Grundlage für Repräsentationen, IL verleiht menschliche Vorabbewertungen, RL treibt die Strategieoptimierung voran und balanciert Effizienz und Stabilität aus, um das Kernmechanismus von verkörperter Intelligenz von Verständnis bis Handlung zu bilden.

Realitätsmigration: Sim2Real – Die Überwindung von Simulation zu Realität

Sim2Real (Simulation to Reality) ermöglicht es Robotern, Training in virtuellen Umgebungen abzuschließen und dann in die reale Welt zu migrieren. Es erzeugt große Mengen an Interaktionsdaten durch hochrealistische Simulationsumgebungen (z.B. NVIDIA Isaac Sim & Omniverse, DeepMind MuJoCo), was die Trainingskosten und den Hardwareverschleiß erheblich senkt. Der Schwerpunkt liegt darauf, die "Kluft zwischen Simulation und Realität" zu verringern, wobei die Hauptmethoden Folgendes umfassen:

Domänen-Randomisierung (Domain Randomization): Zufällige Anpassung von Licht, Reibung, Geräuschen und anderen Parametern in der Simulation, um die Verallgemeinerungsfähigkeit des Modells zu verbessern;

Physikalische Konsistenzkalibrierung: Verwendung von echten Sensordaten zur Kalibrierung der Simulationsengine, um die physikalische Realität zu erhöhen;

Adaptive Feinabstimmung (Adaptive Fine-tuning): Schnelles Retraining in realen Umgebungen zur Gewährleistung stabiler Migration.

Sim2Real ist der zentrale Schritt zur Umsetzung von verkörperter Intelligenz, bei dem KI-Modelle in einer sicheren, kostengünstigen virtuellen Welt lernen können, den geschlossenen Kreis von "Wahrnehmung – Entscheidung – Kontrolle" zu durchlaufen. Sim2Real ist bereits in der Simulationstraining reif (z.B. NVIDIA Isaac Sim, MuJoCo), jedoch wird die realistische Migration durch Reality Gap, hohe Rechenleistung und Markierungskosten sowie unzureichende Verallgemeinerung und Sicherheit in offenen Umgebungen eingeschränkt. Dennoch wird Simulation-as-a-Service (SimaaS) zur leichtesten und strategisch wertvollsten Infrastruktur der verkörperten Intelligenz-Ära, deren Geschäftsmodelle Plattform-Abonnements (PaaS), Datenproduktion (DaaS) und Sicherheitsüberprüfung (VaaS) umfassen.

Kognitive Modellierung: Weltmodell – die "innere Welt" des Roboters

Das Weltmodell (World Model) ist das "innere Gehirn" der verkörperten Intelligenz, das es Robotern ermöglicht, die Umgebung intern zu simulieren und die Folgen ihrer Handlungen vorherzusagen und zu schlussfolgern. Es lernt die dynamischen Regeln der Umgebung und baut vorhersehbare innere Darstellungen auf, sodass der Agent vor der Ausführung "Vorschau" auf das Ergebnis geben kann, wodurch er sich von einem passiven Ausführenden zu einem aktiven Schlussfolgerer entwickelt. Zu den einschlägigen Projekten gehören DeepMind Dreamer, Google Gemini + RT-2, Tesla FSD V12, NVIDIA WorldSim usw. Typische technische Ansätze umfassen:

Latent Dynamics Modeling: Kompression hochdimensionaler Wahrnehmungen in latente Zustandsräume;

Imagination-based Planning: Virtuelles Trial-and-Error und Pfadprognosen im Modell;

Model-based RL: Verwendung von Weltmodellen anstelle der realen Umgebung zur Senkung der Trainingskosten.

Das Weltmodell (World Model) gilt als theoretische Spitze der verkörperten Intelligenz und ist der zentrale Ansatz, um Robotern den Übergang von "reaktiver" zu "prädiktiver" Intelligenz zu ermöglichen, sieht sich jedoch Herausforderungen wie komplexem Modellieren, instabilen Langzeitprognosen und dem Fehlen einheitlicher Standards gegenüber.

Kollektive Intelligenz und Gedächtnis-Schlussfolgerung: Vom individuellen Handeln zur kollektiven Kognition

Multi-Agenten-Kooperation (Multi-Agent Systems) und Gedächtnis-Schlussfolgerung (Memory & Reasoning) repräsentieren zwei wichtige Richtungen, in denen verkörperte Intelligenz von "individueller Intelligenz" zu "kollektiver Intelligenz" und "kognitiver Intelligenz" weiterentwickelt wird. Beide unterstützen gemeinsam die kooperative Lern- und langfristige Anpassungsfähigkeit intelligenter Systeme.

Multi-Agenten-Kooperation (Schwarm / Kooperatives RL):

Bezieht sich auf mehrere Agenten, die durch verteiltes oder kooperatives verstärkendes Lernen in einer gemeinsamen Umgebung kooperative Entscheidungen und Aufgabenverteilung erreichen. In diesem Bereich gibt es bereits eine solide Forschungsbasis, wie das OpenAI Hide-and-Seek-Experiment, das die spontane Zusammenarbeit und das Emergenz von Strategien bei Multi-Agenten demonstriert, und die Algorithmen von DeepMind QMIX und MADDPG bieten einen kooperativen Rahmen für zentralisiertes Training und dezentrale Ausführung. Solche Methoden wurden bereits in Szenarien wie der Steuerung von Lagerrobotern, Inspektionen und Clustersteuerung validiert.

Gedächtnis und Schlussfolgerung (Memory & Reasoning):

Fokussiert darauf, Agenten mit langfristigem Gedächtnis, kontextuellem Verständnis und kausalen Schlussfolgerungsfähigkeiten auszustatten, ist der Schlüssel zur Erreichung von intertask-migration und Selbstplanung. Typische Forschungen umfassen DeepMind Gato (ein einheitlicher Wahrnehmungs-Sprach-Controller-Multitasking-Agent) und die DeepMind Dreamer-Serie (vorstellungsgetriebenes Planen basierend auf Weltmodellen) sowie Open-Source-verankerte verkörperte Agenten wie Voyager, die durch externes Gedächtnis und Selbstentwicklung kontinuierliches Lernen ermöglichen. Diese Systeme legen das Fundament dafür, dass Roboter die Fähigkeit besitzen, "die Vergangenheit zu erinnern und die Zukunft vorherzusagen".

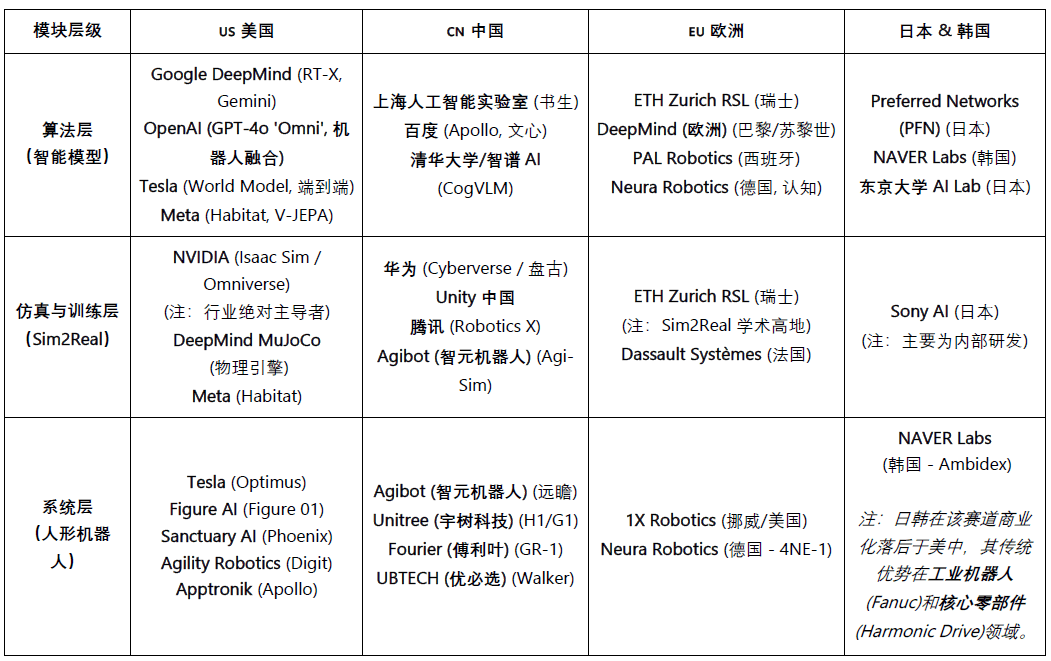

Globale verkörperte Intelligenzindustrie-Landschaft: Kooperation und Wettbewerb existieren nebeneinander

Die globale Robotikindustrie befindet sich in einer Phase, in der Kooperation dominiert und der Wettbewerb vertieft wird. Die Effizienz der Lieferkette in China, die KI-Kapazitäten in den USA, die Präzision von Komponenten in Japan und die industriellen Standards in Europa gestalten langfristig das globale Robotik-Ökosystem.

Die USA sind in den Bereichen fortschrittliche KI-Modelle und Software (DeepMind, OpenAI, NVIDIA) führend, doch dieser Vorteil hat sich nicht auf die Robotik-Hardware ausgeweitet. Chinesische Hersteller haben bei der Iterationsgeschwindigkeit und der Leistung in realen Szenarien einen Vorteil. Die USA fördern die Rückführung der Industrie durch die (Chip-Gesetzgebung) (CHIPS Act) und die (Inflationsreduzierungsgesetzgebung) (IRA).

China hat dank massenhafter Fertigung, vertikaler Integration und politischer Antriebskraft einen führenden Vorteil in den Bereichen Komponenten, automatisierte Fabriken und humanoide Roboter, mit herausragenden Hardware- und Lieferkettenfähigkeiten. Unternehmen wie Unitree und UBTECH haben bereits die Serienproduktion erreicht und erweitern sich in die Schicht der intelligenten Entscheidungsfindung. Allerdings gibt es nach wie vor eine erhebliche Kluft im Bereich Algorithmen und Simulationsschulung im Vergleich zu den USA.

Japan hat langfristig einen Monopol auf hochpräzise Komponenten und Bewegungstechnologien, das industrielle System ist robust, doch die Integration von KI-Modellen befindet sich noch in einem frühen Stadium, das Innovationstempo ist eher stabil.

Südkorea hebt sich durch die Verbreitung von Konsumrobotern hervor – angeführt von Unternehmen wie LG und NAVER Labs – und verfügt über ein etabliertes und starkes Ökosystem für Serviceroboter.

Europa hat ein perfektes Ingenieursystem und Sicherheitsstandards, Unternehmen wie 1X Robotics bleiben in der Forschungsphase aktiv, doch einige Fertigungsprozesse werden ausgelagert und der Innovationsschwerpunkt verschiebt sich in Richtung Zusammenarbeit und Standardisierung.

III. Robotik × KI × Web3: Narrative Visionen und reale Wege

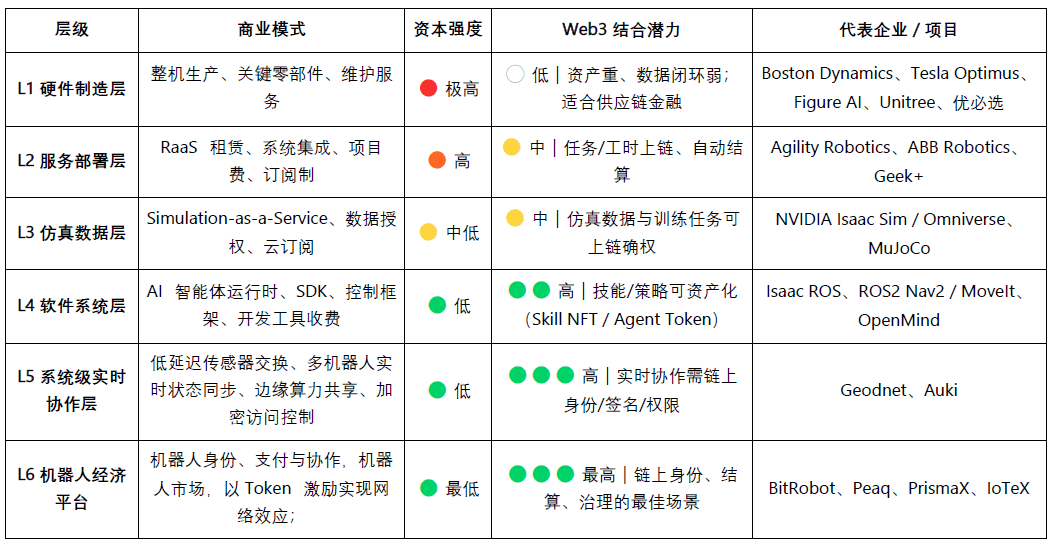

Im Jahr 2025 tritt eine neue Narrative auf, die die Fusion von Web3 mit Robotik und KI beschreibt. Obwohl Web3 als die zugrunde liegende Protokoll für eine dezentrale Maschinenwirtschaft angesehen wird, bestehen in Bezug auf den Wert und die Machbarkeit der Integration auf verschiedenen Ebenen deutliche Unterschiede:

Die Herstellung und der Dienstleistungsbereich sind kapitalintensiv und haben einen schwachen Datenzyklus; Web3 kann derzeit nur unterstützende Funktionen in Randbereichen wie Lieferkettenfinanzierung oder Gerätevermietung übernehmen;

Die Vereinbarkeit mit der Simulations- und Software-Ökologie ist recht hoch; Simulationsdaten und Trainingsaufgaben können on-chain verifiziert werden, intelligente Agenten und Fähigkeitsmodule können auch durch NFTs oder Agent Tokens tokenisiert werden;

In der Plattformebene zeigt das dezentrale Arbeitskräfte- und Kooperationsnetzwerk das größte Potenzial – Web3 kann durch identitäts-, anreiz- und governance-integrierte Mechanismen schrittweise einen zuverlässigen "Marktplatz für Maschinenarbeitskräfte" aufbauen, um die institutionellen Grundlagen der zukünftigen Maschinenwirtschaft zu schaffen.

Langfristig betrachtet ist die Zusammenarbeit und Plattform-Ebene die wertvollste Richtung für die Fusion von Web3 mit Robotik und KI. Während Roboter allmählich Wahrnehmungs-, Sprach- und Lernfähigkeiten entwickeln, entwickeln sie sich zu intelligenten Individuen, die autonom Entscheidungen treffen, zusammenarbeiten und wirtschaftlichen Wert schaffen können. Diese "intelligenten Arbeiter" werden aktiv Teil des wirtschaftlichen Systems, müssen jedoch vier zentrale Hürden in Bezug auf Identität, Vertrauen, Anreize und Governance überwinden.

Auf der Identitätsebene müssen Maschinen über eine überprüfbare, rückverfolgbare digitale Identität verfügen. Durch Machine DID kann jeder Roboter, Sensor oder Drohne eine einzigartige, verifizierbare "Identitätskarte" on-chain erstellen, die ihr Eigentum, Verhalten und Berechtigungsumfang bindet, um sichere Interaktionen und Verantwortlichkeiten zu ermöglichen.

Auf der Vertrauensstufe ist es entscheidend, dass "maschinelle Arbeit" verifizierbar, messbar und preislich einordbar ist. Mithilfe von Smart Contracts, Orakeln und Prüfmechanismen sowie physikalischen Arbeitsnachweisen (PoPW), vertrauenswürdigen Ausführungsumgebungen (TEE) und Zero-Knowledge-Proofs (ZKP) können die Echtheit und Rückverfolgbarkeit des Aufgabenausführungsprozesses sichergestellt werden, wodurch maschinelles Handeln einen wirtschaftlichen Bewertungswert erhält.

In der Anreizschicht ermöglicht Web3 durch Token-Anreizsysteme, Kontenabstraktion und Statuskanäle die automatische Abrechnung und den Wertfluss zwischen Maschinen. Roboter können Mikrozahlungen für Rechenleistung und Datenaustausch durchführen und mit einem Staking- und Bestrafungsmechanismus die Erfüllung von Aufgaben gewährleisten; durch Smart Contracts und Orakel kann auch ein dezentraler "Maschinenkooperationsmarkt" ohne menschliche Koordination entstehen.

In der Governance-Schicht bietet Web3, wenn Maschinen über langfristige Autonomie verfügen, einen transparenten und programmierbaren Governance-Rahmen: DAO-Governance zur gemeinsamen Entscheidungsfindung über Systemparameter und Multisignatur- sowie Reputationsmechanismen zur Aufrechterhaltung von Sicherheit und Ordnung. Langfristig wird dies die Maschinen-Gesellschaft in die Phase der "algorithmischen Governance" führen – der Mensch setzt Ziele und Grenzen, während Maschinen durch Verträge Anreize und Gleichgewicht aufrechterhalten.

Die ultimative Vision der Integration von Web3 und Robotik: Ein Netzwerk für reale Umwelttests – eine "Real-World-Inference Engine", die aus verteilten Robotern besteht, die kontinuierlich in verschiedenen, komplexen physischen Szenarien testen und Modellfähigkeiten benchmarken; sowie ein Arbeitsmarkt für Roboter – Roboter führen weltweit überprüfbare reale Aufgaben aus, erzielen Einnahmen durch On-Chain-Abrechnung und reinvestieren den Wert in Rechenleistung oder Hardware-Updates.

Aus der realistischen Perspektive betrachtet befindet sich die Integration von verkörperter Intelligenz mit Web3 noch in der frühen Explorationsphase. Dezentrale Maschinenintelligenz-Ökonomien bleiben weitgehend auf narrativen und gemeinschaftlich getriebenen Ebenen. In der Realität zeigen praktikable Integrationsrichtungen ihre Potenziale hauptsächlich in den folgenden drei Aspekten:

(1) Daten-Crowdsourcing und -Rechte – Web3 ermutigt durch On-Chain-Anreize und Rückverfolgbarkeit die Mitwirkenden, echte Daten aus der realen Welt hochzuladen;

(2) Globale Langschwanzbeteiligung – grenzüberschreitende Mikrozahlungen und Mikroanreizmechanismen senken effektiv die Kosten für Datenerfassung und -verteilung;

(3) Finanzialisierung und Innovationskooperation – Das DAO-Modell kann die Vermögensbildung von Robotern, die Generierung von Erträgen und die Abrechnungsmechanismen zwischen Maschinen vorantreiben.

Insgesamt konzentriert sich kurzfristig hauptsächlich auf Datenerfassung und Anreizschichten; mittelfristig sind Durchbrüche im Bereich "Stablecoin-Zahlungen + Crowdsourcing von Langschwanzdaten" sowie in der RaaS-Assetalisierung und Abrechnungsschicht zu erwarten; langfristig, falls humanoide Roboter massenhaft verbreitet werden, könnte Web3 zur institutionellen Grundlage für Maschinenbesitz, Ertragsverteilung und Governance werden, wodurch die tatsächliche Bildung einer dezentralen Maschinenwirtschaft gefördert wird.

IV. Web3-Roboter-Ökosystemkarte und ausgewählte Fälle

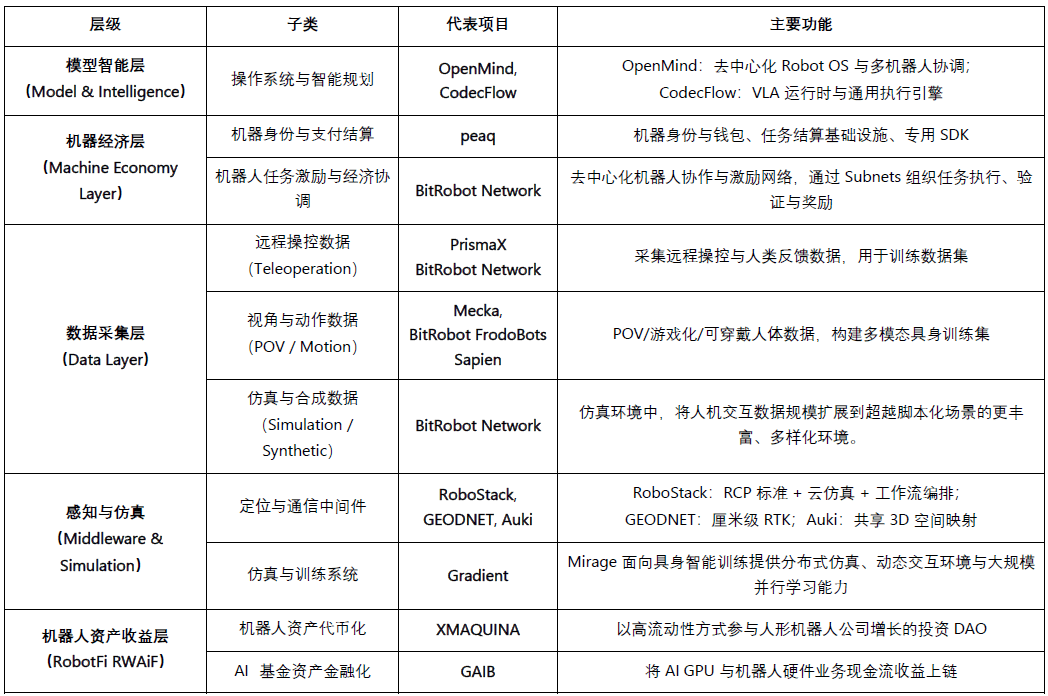

Basierend auf den drei Kriterien "verifizierbare Fortschritte, technologische Offenheit, Branchenrelevanz" wird eine Übersicht über aktuelle repräsentative Projekte im Bereich Web3 × Robotik erstellt und in fünf Schichten klassifiziert: Modellintelligenzschicht, Maschinenwirtschaftsschicht, Datenerfassungsschicht, Wahrnehmungs- und Simulationsgrundschicht, Robotervermögensertragschicht. Um objektiv zu bleiben, haben wir offensichtlich "Hype-Projekte" oder solche mit unzureichenden Daten ausgeschlossen; bei etwaigen Auslassungen sind wir für Korrekturen dankbar.

Modellintelligenzschicht (Model & Intelligence)

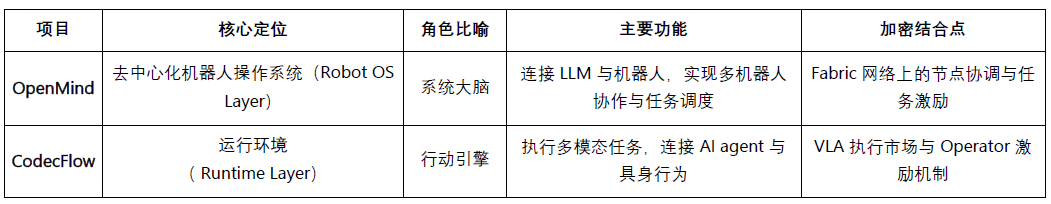

Openmind - Building Android for Robots (https://openmind.org/)

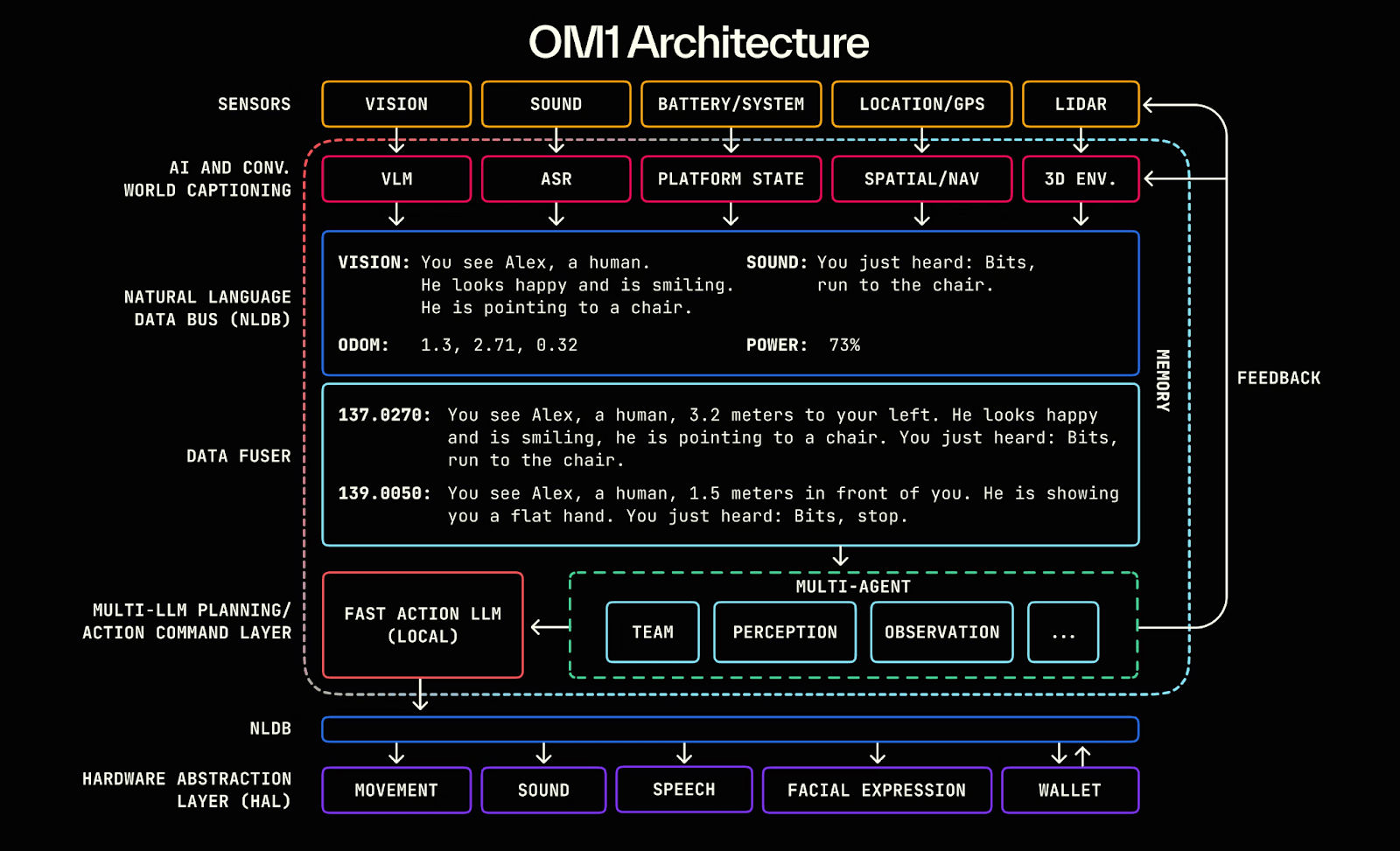

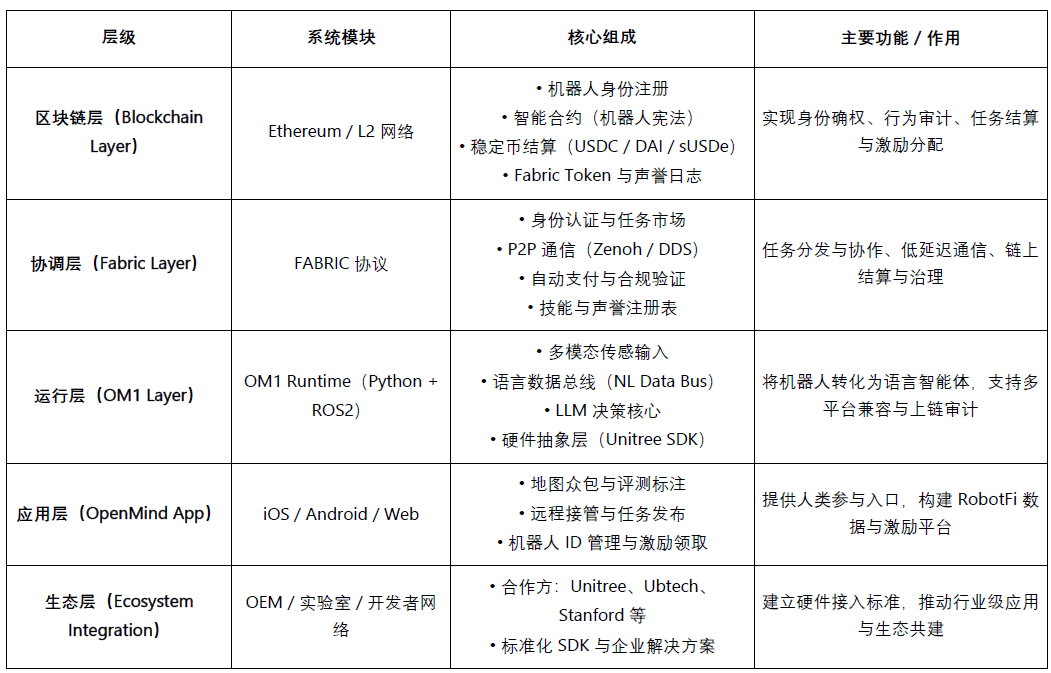

OpenMind ist ein Open-Source-Betriebssystem (Robot OS) für verkörperte Intelligenz (Embodied AI) und Robotiksteuerung, das darauf abzielt, die weltweit erste dezentralisierte Roboterbetriebsumgebung und Entwicklungsplattform zu schaffen. Der Kern des Projekts umfasst zwei Hauptkomponenten:

OM1: Ein modulares Open-Source-AI-Intelligent-Execution-Time-System (AI Runtime Layer) auf der Basis von ROS2, das zur Orchestrierung von Wahrnehmung, Planung und Aktionspipelines dient und sowohl digitale als auch physische Roboter unterstützt;

FABRIC: Verteilte Koordinationsschicht (Fabric Coordination Layer), die Cloud-Computing, Modelle und reale Roboter verbindet, sodass Entwickler Roboter in einer einheitlichen Umgebung steuern und trainieren können.

Der Kern von OpenMind liegt darin, als intelligente Zwischenebene zwischen LLM (Large Language Models) und der Welt der Robotik zu fungieren und sprachliche Intelligenz in verkörperte Intelligenz (Embodied Intelligence) zu transformieren, wodurch ein intelligentes Skelett von "Verstehen (Language → Action)" bis "Abgleich (Blockchain → Rules)" entsteht. Das mehrschichtige System von OpenMind hat einen vollständigen Kooperationskreis implementiert: Menschen geben über die OpenMind-App Feedback und Markierungen (RLHF-Daten), das Fabric-Netzwerk ist für Identitätsvalidierung, Aufgabenverteilung und Abrechnungskoordination zuständig, die OM1-Roboter führen die Aufgaben aus und halten sich an die "Roboterverfassung" auf der Blockchain, um Verhaltensprüfungen und Zahlungen abzuschließen, wodurch ein dezentralisiertes maschinelles Kooperationsnetzwerk mit "menschlichem Feedback → Aufgabenkooperation → On-Chain-Abrechnung" entsteht.

Projektfortschritt und Realitätsbewertung

OpenMind befindet sich in der frühen Phase "technisch funktionsfähig, kommerziell noch nicht umgesetzt". Das Kernsystem OM1 Runtime wurde auf GitHub als Open Source veröffentlicht und kann plattformübergreifend betrieben werden und unterstützt multimodale Eingaben. Durch eine natürliche Sprachdatenleitung (NLDB) wird eine Aufgabenverständnis von Sprache zu Handlung erreicht, mit hoher Originalität, jedoch noch experimentell. Das Fabric-Netzwerk und die On-Chain-Abrechnung haben lediglich die Schnittstellengestaltung abgeschlossen.

Ökologisch hat das Projekt Kooperationen mit offenen Hardware-Anbietern wie Unitree, Ubtech, TurtleBot und Hochschulen wie Stanford, Oxford und Seoul Robotics, hauptsächlich für Bildungs- und Forschungsvalidierung, jedoch noch keine industrielle Umsetzung. Die App hat eine Testversion gestartet, aber Anreiz- und Aufgabenfunktionen befinden sich noch in einem frühen Stadium.

In Bezug auf das Geschäftsmodell hat OpenMind ein dreischichtiges Ökosystem aus OM1 (Open-Source-System) + Fabric (Abrechnungsprotokoll) + Skill Marketplace (Anreizschicht) aufgebaut, das derzeit noch keine Einnahmen erzielt und auf rund 20 Millionen Dollar Frühfinanzierung (Pantera, Coinbase Ventures, DCG) angewiesen ist. Insgesamt betrachtet ist die Technologie führend, aber die Kommerzialisierung und das Ökosystem stehen noch am Anfang. Sollte Fabric erfolgreich implementiert werden, könnte es "Android der verkörperten Intelligenz-Ära" werden, jedoch ist der Zyklus lang, das Risiko hoch und es gibt eine starke Abhängigkeit von Hardware.

CodecFlow - Die Ausführungsmaschine für Robotik (https://codecflow.ai)

CodecFlow ist ein dezentrales Ausführungsprotokoll (Fabric) auf der Solana-Blockchain, das darauf abzielt, AI-Intelligente und Robotersystemen eine bedarfsorientierte Betriebsumgebung zu bieten und jedem intelligenten Agenten "Instant Machine" zu ermöglichen. Das Projekt besteht aus drei kernmodulen:

Fabric: Cross-Cloud-Computing-Aggregationsschicht (Weaver + Shuttle + Gauge), die in wenigen Sekunden sichere virtuelle Maschinen, GPU-Container oder Robotersteuerungsknoten für KI-Aufgaben erstellen kann;

optr SDK: Ausführungsrahmen für Agenten (Python-Schnittstelle), um "Operatoren" für Desktop-, Simulations- oder reale Roboter zu erstellen;

Token-Anreize: On-Chain-Anreiz- und Zahlungsstufe, die Rechenanbieter, Entwickler von Agenten und Benutzer automatisierter Aufgaben verbindet und einen dezentralen Markt für Rechenleistung und Aufgaben schafft.

Das Hauptziel von CodecFlow ist es, eine "dezentrale Ausführungsbasis für KI und Roboteroperatoren" zu schaffen, die es jedem intelligenten Agenten ermöglicht, in jeder Umgebung (Windows / Linux / ROS / MuJoCo / Robotersteuerung) sicher zu operieren und eine allgemeine Ausführungsarchitektur von der Rechenleistung (Fabric) über die Systemumgebung (System Layer) bis hin zur Wahrnehmung und Handlung (VLA Operator) zu realisieren.

Projektfortschritt und Realitätsbewertung

Die frühzeitige Version des Fabric-Frameworks (Go) und des optr SDK (Python) wurde veröffentlicht, die in Web- oder Befehlszeilenumgebungen isolierte Recheninstanzen starten kann. Der Operator-Markt wird voraussichtlich Ende 2025 online gehen und als dezentrale Ausführungsschicht für KI-Rechenleistung positioniert sein.

Die Hauptzielgruppen sind KI-Entwickler, Robotikforschungsteams und Unternehmen für automatisierte Betriebe.

Maschinenwirtschaftsschicht (Machine Economy Layer)

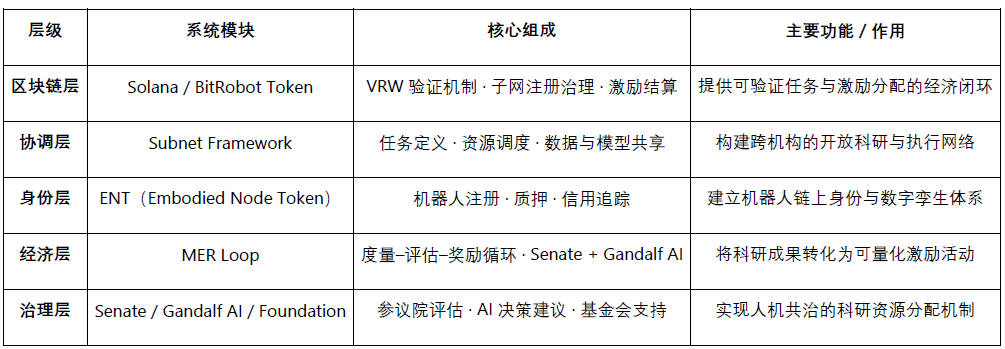

BitRobot - Das weltweit offene Robotiklabor (https://bitrobot.ai)

BitRobot ist ein dezentrales Forschungs- und Kooperationsnetzwerk (Open Robotics Lab) für verkörperte Intelligenz (Embodied AI) und Robotikforschung, das von FrodoBots Labs und Protocol Labs gemeinsam initiiert wurde. Ihr zentrales Ziel ist es, durch die offene Architektur von "Subnets + Anreizmechanismus + verifiziertes Arbeiten (VRW)" eine zentrale Rolle zu spielen, einschließlich:

Definiert und validiert den tatsächlichen Beitrag jeder Roboteraufgabe durch den VRW (Verifiable Robotic Work) Standard;

Verleiht Robotern durch den ENT (Embodied Node Token) eine On-Chain-Identität und wirtschaftliche Verantwortung;

Organisiert die grenzüberschreitende Zusammenarbeit von Forschung, Rechenleistung, Geräten und Betreibern durch Subnets;

Erreicht Anreizentscheidungen und Forschungsgovernance für "menschliche Maschinenkooperation" durch Senate + Gandalf AI.

Seit der Veröffentlichung des Whitepapers im Jahr 2025 hat BitRobot mehrere Subnets (z.B. SN/01 ET Fugi, SN/05 SeeSaw by Virtuals Protocol) betrieben, die dezentrale Fernsteuerung und die Erfassung realer Szenarien ermöglichen und den $5M Grand Challenges Fund ins Leben gerufen haben, um globale Forschungswettbewerbe zur Modellentwicklung voranzutreiben.

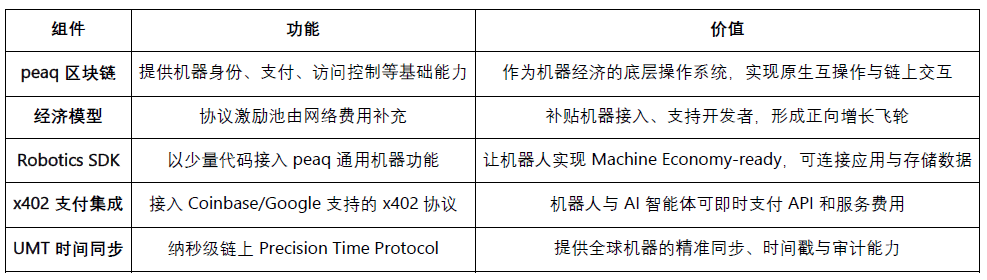

peaq – Die Wirtschaft der Dinge (https://www.peaq.network)

peaq ist eine Layer-1-Blockchain, die speziell für die Maschinenwirtschaft entwickelt wurde, und bietet Millionen von Robotern und Geräten Maschinenidentität, On-Chain-Wallets, Zugriffskontrolle sowie nanosekunden-genaue Zeit-Synchronisation (Universal Machine Time). Ihr Robotics SDK ermöglicht es Entwicklern, mit minimalem Code ihre Roboter "maschinenwirtschaftsbereit" zu machen, um Interoperabilität und Interaktionen zwischen verschiedenen Herstellern und Systemen zu ermöglichen.

Derzeit hat peaq die weltweit erste tokenisierte Roboterfarm gestartet und unterstützt über 60 reale Maschinenanwendungen. Ihr Tokenisierungsrahmen hilft Robotergesellschaften, Kapital für kapitalintensive Hardware zu sammeln und das Beteiligungsmodell von traditionellem B2B/B2C auf breitere Gemeinschaftsebenen auszudehnen. Dank des durch Netzwerkgebühren gespeisten Anreizpools kann peaq neue Geräteanbindungen subventionieren und Entwickler unterstützen, wodurch ein wirtschaftlicher Zyklus entsteht, der das beschleunigte Wachstum von Robotern und physischen KI-Projekten fördert.

Datenerfassungsschicht (Data Layer)

Ziel ist es, den Mangel an hochwertigen, teuren Daten aus der realen Welt zu lösen, die für das Training von verkörperter Intelligenz erforderlich sind. Durch verschiedene Wege werden Daten über Mensch-Maschine-Interaktion erfasst und generiert, einschließlich Fernsteuerung (PrismaX, BitRobot Network), First-Person-Perspektive und Motion-Capture (Mecka, BitRobot Network, Sapien, Vader, NRN) sowie Simulation und synthetische Daten (BitRobot Network), um Robotermodellen eine skalierbare und generalisierte Trainingsbasis zu bieten.

Es ist wichtig zu betonen, dass Web3 nicht gut darin ist, "Daten zu produzieren" – in Bezug auf Hardware, Algorithmen und Erfassungseffizienz übertreffen Web2-Riesen jedes DePIN-Projekt. Ihr echter Wert besteht darin, die Verteilung und Anreizmechanismen für Daten neu zu gestalten. Basierend auf "Stablecoin-Zahlungsnetzwerk + Crowdsourcing-Modell" wird durch ein unbeschränktes Anreizsystem und On-Chain-Identifikationsmechanismen eine kostengünstige, kleinteilige Abrechnung, Beitragstransparenz und automatische Gewinnverteilung erreicht. Dennoch steht das offene Crowdsourcing weiterhin vor Herausforderungen bezüglich Qualität und Nachfrage-Rückkopplung – die Datenqualität ist unterschiedlich, und es fehlt an effektiver Validierung und stabilen Käufern.

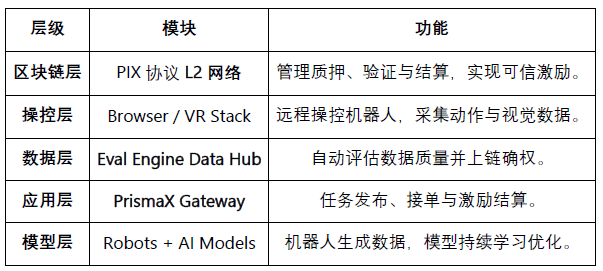

PrismaX (https://gateway.prismax.ai)

PrismaX ist ein dezentrales Netzwerk für Fernsteuerung und Datenwirtschaft, das sich an verkörperte Intelligenz (Embodied AI) richtet und darauf abzielt, einen "globalen Roboterarbeitsmarkt" zu schaffen, in dem menschliche Betreiber, Robotergeräte und KI-Modelle durch ein On-Chain-Anreizsystem ko-evolvieren. Der Kern des Projekts umfasst zwei Hauptkomponenten:

Teleoperation Stack – Fernbedienungssystem (Browser/VR-Schnittstelle + SDK), das globale Roboterarme und Serviceroboter verbindet und es Menschen ermöglicht, in Echtzeit zu steuern und Daten zu sammeln;

Eval Engine – Datenbewertungs- und Validierungsengine (CLIP + DINOv2 + optische Fluss-semantische Bewertung), die für jede Aktionsspur eine Qualitätsbewertung erstellt und diese on-chain abwickelt.

PrismaX wandelt menschliche Betriebshandlungen durch ein dezentrales Anreizsystem in Daten für maschinelles Lernen um und schafft einen geschlossenen Kreislauf von Fernsteuerung → Datenerfassung → Modelltraining → On-Chain-Abrechnung, um "menschliche Arbeit gleich Datenvermögen" zu erreichen.

Projektfortschritt und Realitätsbewertung: PrismaX hat im August 2025 die Testversion (gateway.prismax.ai) gestartet, Benutzer können Roboterarme aus der Ferne steuern, um Greifversuche durchzuführen und Trainingsdaten zu erstellen. Die Eval Engine läuft intern, insgesamt hat PrismaX einen relativ hohen technischen Reifegrad, eine klare Positionierung und ist die entscheidende Middleware, die "menschliche Operation × KI-Modelle × Blockchain-Abrechnung" verbindet. Ihr langfristiges Potenzial könnte darin bestehen, ein "dezentraler Arbeits- und Datenprotokoll der verkörperten Intelligenz-Ära" zu werden, sieht sich jedoch kurzfristig noch Herausforderungen bei der Skalierung gegenüber.

BitRobot Network (https://bitrobot.ai/)

Das BitRobot Network ermöglicht durch seine Subnets die Erfassung von Videos, Fernsteuerungen und Simulationen sowie die Erfassung von Daten aus verschiedenen Quellen. SN/01 ET Fugi erlaubt es Benutzern, Roboter aus der Ferne zu steuern, um Aufgaben zu erledigen, und sammelt Navigations- und Wahrnehmungsdaten in einer "realen Pokémon Go-ähnlichen" Interaktion. Diese Spielweise hat zur Entstehung des FrodoBots-2K-Datensatzes geführt, der einer der größten offenen Datensätze für Mensch-Roboter-Navigation ist und von Institutionen wie UC Berkeley RAIL und Google DeepMind verwendet wird. SN/05 SeeSaw (Virtual Protocol) ermöglicht es, mit dem iPhone in der realen Umgebung großflächig First-Person-Videodaten zu erfassen. Weitere veröffentlichte Subnets, wie RoboCap und Rayvo, konzentrieren sich darauf, kostengünstige physische Geräte zur Erfassung von First-Person-Videodaten zu nutzen.

Mecka (https://www.mecka.ai)

Mecka ist ein Roboterdatenunternehmen, das durch gamifizierte mobile Erfassung und maßgeschneiderte Hardwaregeräte Crowdsourcing für erste-Personen-Videos, menschliche Bewegungsdaten und Aufgabendemonstrationen betreibt, um große multimodale Datensätze zum Training von verkörperten Intelligenzmodellen aufzubauen.

Sapien (https://www.sapien.io/)

Sapien ist eine Crowdsourcing-Plattform, die auf "menschlichen Bewegungsdaten, die robotische Intelligenz antreiben" fokussiert ist, und durch tragbare Geräte und mobile Apps menschliche Bewegungen, Haltungen und Interaktionsdaten erfasst, um verkörperte Intelligenzmodelle zu trainieren. Das Projekt zielt darauf ab, das größte Netzwerk menschlicher Bewegungsdaten weltweit aufzubauen, sodass menschliches Verhalten die Basisdaten für das Lernen und die Verallgemeinerung von Robotern bildet.

Vader (https://www.vaderai.ai)

Vader sammelt durch seine MMO-Anwendung EgoPlay Crowdsourcing von First-Person-Videos und Aufgabendemonstrationen: Benutzer zeichnen ihre täglichen Aktivitäten aus der Ich-Perspektive auf und erhalten $VADER-Belohnungen. Die ORN-Datenpipeline kann Roh-POV-Bilder in anonymisierte, strukturierte Datensätze umwandeln, die Aktionslabels und semantische Beschreibungen enthalten und direkt für das Training humanoider Roboter verwendet werden.

NRN Agents (https://www.nrnagents.ai/)

Eine gamifizierte Datenplattform für verkörperte RL, die über einen Browser-Robotersteuerungs- und Simulationswettbewerb menschliche Demodaten crowdsourced. NRN generiert durch "Wettbewerbsaufgaben" Langschwanzverhaltensspuren, die für Imitationslernen und kontinuierliches Verstärkungslernen verwendet werden und als skalierbare Datenprimitive zur Unterstützung des Sim-to-Real-Strategietrainings dienen.

Vergleich von Projekten zur Datenerfassung für verkörperte Intelligenz

Wahrnehmung und Simulation (Middleware & Simulation)

Die Wahrnehmungs- und Simulationsschicht bietet Roboter eine zentrale Infrastruktur, um die physische Welt mit intelligenter Entscheidungsfindung zu verbinden, einschließlich Positionierung, Kommunikation, räumlichem Modellieren und Simulationstraining; sie ist das "mittlere Skelett" zum Aufbau großangelegter verkörperter Intelligenzsysteme. Derzeit befindet sich dieser Bereich noch in der frühen Erkundungsphase, wobei verschiedene Projekte differenzierte Strategien in den Bereichen hochpräzise Positionierung, gemeinschaftliches Raumcomputing, Standardisierung von Protokollen und verteilte Simulation entwickeln, jedoch noch keine einheitlichen Standards oder ein interoperables Ökosystem vorhanden ist.

Middleware und räumliche Infrastruktur (Middleware & Spatial Infra)

Die Kernkompetenzen von Robotern – Navigation, Positionierung, Konnektivität und räumliches Modellieren – bilden die entscheidende Brücke zwischen der physischen Welt und intelligenter Entscheidungsfindung. Obwohl breitere DePIN-Projekte (Silencio, WeatherXM, DIMO) beginnen, über "Roboter" zu sprechen, sind die folgenden Projekte am direktesten mit verkörperter Intelligenz verbunden.

RoboStack – Cloud-natives Robot Operating Stack (https://robostack.io)

RoboStack ist ein cloud-natives Robotermiddleware, das die Echtzeitplanung, Fernsteuerung und plattformübergreifende Interoperabilität von Roboteraufgaben über RCP (Robot Context Protocol) ermöglicht und Cloud-Simulation, Workflow-Orchestrierung und Agent-Zugriffsfähigkeiten bereitstellt.

GEODNET – Dezentrales GNSS-Netzwerk (https://geodnet.com)

GEODNET ist ein globales dezentrales GNSS-Netzwerk, das centimeter-genaues RTK-High-Precision-Positioning bietet. Durch verteilte Basistationen und On-Chain-Anreize wird Echtzeit-"Geobasislayer" für Drohnen, autonomes Fahren und Roboter bereitgestellt.

Auki – Posemesh für räumliches Computing (https://www.auki.com)

Auki hat ein dezentrales Posemesh-Raumcomputernetzwerk aufgebaut, das durch Crowdsourcing von Sensoren und Berechnungsknoten Echtzeit-3D-Umgebungslandkarten generiert, um AR, Roboternavigation und die Zusammenarbeit mehrerer Geräte zu unterstützen. Es ist eine Schlüssel-Infrastruktur, die den virtuellen Raum mit realen Szenarien verbindet und die Integration von AR × Robotik fördert.

Tashi Network – Echtzeit-Gitter-Kooperationsnetzwerk für Roboter (https://tashi.network)

Dezentralisiertes Echtzeit-Gitter-Netzwerk, das Konsens unter 30 ms, latenzarme Sensoraustausche und Synchronisation des Status mehrerer Roboter ermöglicht. Das MeshNet SDK unterstützt gemeinsames SLAM, kollektive Kooperation und robuste Kartenaktualisierungen und bietet eine leistungsstarke Echtzeit-Kooperationsschicht für verkörperte KI.

Staex – Dezentrales Verbindungs- und Telemetrie-Netzwerk (https://www.staex.io)

Die dezentrale Verbindungsschicht, die aus der Forschungsabteilung der Deutschen Telekom hervorgegangen ist, bietet sichere Kommunikation, vertrauenswürdige Telemetrie und Routingfähigkeiten von Geräten zur Cloud, sodass Roboterflotten zuverlässig Daten austauschen und über verschiedene Betreiber hinweg zusammenarbeiten können.

Simulations- und Trainingssystem (Distributed Simulation & Learning)

Gradient - Towards Open Intelligence (https://gradient.network/)

Gradient ist ein KI-Labor, das "Open Intelligence" aufbaut und darauf abzielt, verteiltes Training, Schlussfolgerung, Validierung und Simulation auf der Grundlage dezentraler Infrastrukturen zu realisieren. Ihr aktueller Technologiestack umfasst Parallax (verteilte Schlussfolgerung), Echo (verteiltes verstärkendes Lernen und Multi-Agenten-Training) sowie Gradient Cloud (KI-Lösungen für Unternehmen). In der Robotik bietet die Mirage-Plattform verteilte Simulation, dynamische Interaktionsumgebungen und großflächiges paralleles Lernen für die Ausbildung und Umsetzung von Weltmodellen und universalen Strategien an. Mirage steht in Gesprächen über eine mögliche Kooperation mit NVIDIA und deren Newton-Engine.

Die Vermögensertragschicht für Roboter (RobotFi / RWAiFi)

Diese Schicht konzentriert sich auf den kritischen Schritt, Roboter von "produktivem Werkzeug" in "finanzierbare Vermögenswerte" umzuwandeln, durch Vermögens-Tokenisierung, Ertragsverteilung und dezentrale Governance, um die finanzielle Infrastruktur der Maschinenwirtschaft zu schaffen. Repräsentative Projekte sind:

XmaquinaDAO – Physical AI DAO (https://www.xmaquina.io)

XMAQUINA ist ein dezentrales Ökosystem, das globalen Nutzern einen hochgradig liquiden Zugang zu führenden humanoiden Robotern und verkörperten Intelligenzunternehmen bietet und Chancen, die traditionell nur Risikokapitalinstitutionen gehörten, On-Chain bringt. Ihr Token DEUS ist sowohl ein liquider Index-Asset als auch ein Governance-Element, das zur Koordination der Schatzverteilung und der Ökosystementwicklung verwendet wird. Über das DAO-Portal und den Machine Economy Launchpad kann die Gemeinschaft durch die Tokenisierung und Strukturierung von Maschinenvermögen an neu aufkommenden Physical AI-Projekten gemeinsam halten und unterstützen.

GAIB – Die wirtschaftliche Schicht für KI-Infrastruktur (https://gaib.ai/)

GAIB hat sich zum Ziel gesetzt, eine einheitliche wirtschaftliche Schicht für GPU und Robotik sowie andere physische KI-Infrastrukturen zu schaffen, die dezentralisierte Kapital mit realen KI-Infrastrukturwerten verbindet und ein verifiziertes, kombinierbares und ertragsbringendes intelligentes Wirtschaftssystem aufbaut.

Im Robotikbereich verkauft GAIB keine "Roboter-Token", sondern ermöglicht es, Roboterausrüstung und Betriebsverträge (RaaS, Datenerfassung, Fernoperation usw.) zu finanzieren und On-Chain in "echte Cashflows → On-Chain-kompatible Ertragsanlagen" umzuwandeln. Dieses System umfasst Hardwarefinanzierung (Finanzierungsleasing / Staking), Betriebs-Cashflows (RaaS / Datenservices) und Datenstromerträge (Lizenzen / Verträge), wodurch Robotermittel und deren Cashflows messbar, bewertbar und handelbar werden.

GAIB verwendet AID / sAID als Abrechnungs- und Ertragsmechanismus und sichert stabile Renditen durch strukturierte Risikomanagementmechanismen (Überbesicherung, Rücklagen und Versicherungen) und integriert langfristig DeFi-Derivate und Liquiditätsmärkte, um einen finanziellen Kreislauf von "Robotervermögen" zu "kombinierbaren Ertragsanlagen" zu bilden. Ziel ist es, das wirtschaftliche Rückgrat der KI-Ära (Economic Backbone of Intelligence) zu werden.

Web3-Roboter-Ökosystemkarte: https://fairy-build-97286531.figma.site/

V. Zusammenfassung und Ausblick: Reale Herausforderungen und langfristige Chancen

Langfristig zielt die Integration von Robotik × KI × Web3 darauf ab, ein dezentrales Maschinenwirtschaftssystem (DeRobot Economy) aufzubauen und verkörperte Intelligenz von "einzelner Automatisierung" in "verifizierbare, abrechenbare und verwaltbare" Netzwerkkollaboration zu überführen. Die zentrale Logik besteht darin, durch "Token → Bereitstellung → Daten → Wertverteilung" einen Selbstumlaufmechanismus zu bilden, der Robotern, Sensoren und Rechenknoten Verifizierung, Handel und Ertragsverteilung ermöglicht.

Aus der realen Perspektive betrachtet befindet sich dieses Modell jedoch noch in der frühen Explorationsphase und ist weit davon entfernt, stabile Cashflows und geschlossene kommerzielle Kreisläufe zu bilden. Die meisten Projekte bleiben auf der narrativen Ebene und haben nur begrenzte tatsächliche Bereitstellungen. Der Robotikbau und -betrieb sind kapitalintensive Industrien, und allein auf Token-Anreize zu setzen, reicht nicht aus, um die infrastrukturelle Expansion zu unterstützen; obwohl das On-Chain-Finanzdesign kombinierbar ist, wurden die Risiken der Preisgestaltung und Ertragsverwirklichung echter Vermögenswerte noch nicht gelöst. Daher bleibt das Konzept des "Selbstumlaufes des Maschinen-Netzwerks" eher idealistisch, und das Geschäftsmodell bedarf der praktischen Validierung.

Die Modellintelligenzschicht (Model & Intelligence Layer) ist derzeit die wertvollste langfristige Richtung. Das OpenMind-Open-Source-Roboterbetriebssystem versucht, geschlossene Ökosysteme zu durchbrechen, indem es die Zusammenarbeit mehrerer Roboter und die Sprache in Aktionsschnittstellen vereint. Die technische Vision ist klar, das System vollständig, aber der Arbeitsaufwand ist enorm, der Validierungszeitraum lang und es hat sich noch kein industrielles positives Feedback entwickelt.

Die Maschinenwirtschaftsschicht (Machine Economy Layer) befindet sich noch in der Vorbereitungsphase. In der Realität gibt es nur eine begrenzte Anzahl von Robotern, und DAS-Identität und Anreiznetzwerke sind noch schwer zu einem kohärenten Zyklus zu formen. Der Weg zur "Maschinenarbeitswirtschaft" ist noch weit. Zukünftig wird erst mit einer skalierbaren Bereitstellung verkörperter Intelligenz die wirtschaftliche Wirkung von On-Chain-Identität, Abrechnung und Kooperationsnetzwerken wirklich sichtbar werden.

Die Datenerfassungsschicht (Data Layer) hat die relativ niedrigsten Zugangsvoraussetzungen, ist jedoch derzeit die vielversprechendste Richtung in Richtung kommerzieller Machbarkeit. Die Datenerfassung für verkörperte Intelligenz erfordert eine hohe zeitliche und räumliche Kontinuität sowie eine hohe semantische Genauigkeit der Aktionen, was ihre Qualität und Wiederverwendbarkeit bestimmt. Der Balanceakt zwischen "Crowdsourcing-Skala" und "Datenzuverlässigkeit" ist die zentrale Herausforderung der Branche. PrismaX zielt darauf ab, zunächst die B2B-Nachfrage zu sichern und dann Aufgaben zur Datensammlung zu verteilen, was bis zu einem gewissen Grad ein replizierbares Modell bietet, aber das Ökosystem und den Datenaustausch benötigen noch Zeit, um sich zu entwickeln.

Die Wahrnehmungs- und Simulationsschicht (Middleware & Simulation Layer) befindet sich noch in der Phase der technologischen Validierung, es fehlen einheitliche Standards und Schnittstellen, und ein interoperables Ökosystem wurde noch nicht gebildet. Die Simulationsresultate sind schwer zu standardisieren und auf die reale Umgebung zu übertragen, was die Sim2Real-Effizienz einschränkt.

Die Vermögensertragschicht (RobotFi / RWAiFi) spielt in Web3 hauptsächlich eine unterstützende Rolle in den Bereichen Lieferkettenfinanzierung, Gerätevermietung und Investitionsverwaltung, um die Transparenz und Abrechnungseffizienz zu erhöhen, anstatt die Logik der Branche neu zu gestalten.

Natürlich glauben wir, dass der Schnittpunkt von Robotik × KI × Web3 immer noch den Ausgangspunkt für das nächste intelligente Wirtschaftssystem darstellt. Es ist nicht nur eine Fusion technologischer Paradigmen, sondern auch eine Gelegenheit zur Neugestaltung der Produktionsverhältnisse: Wenn Maschinen Identitäten, Anreize und Governance-Mechanismen haben, wird die menschliche Maschinenkooperation von lokaler Automatisierung zu netzwerkbasierter Autonomie übergehen. Kurzfristig bleibt diese Richtung vor allem narrativ und experimentell, doch die institutionellen und Anreizrahmen, die sie legen, ebnen den Weg für die wirtschaftliche Ordnung der zukünftigen Maschinen-Gesellschaft. Aus langfristiger Sicht wird die Kombination von verkörperter Intelligenz und Web3 die Grenzen der Wertschöpfung neu gestalten – sodass intelligente Agenten zu echten, verifizierbaren, kooperativen und ertragsbringenden wirtschaftlichen Akteuren werden.

Haftungsausschluss: Dieser Artikel wurde unter Verwendung von AI-Tools wie ChatGPT-5 und Deepseek erstellt. Der Autor hat sich bemüht, die Informationen zu überprüfen und sicherzustellen, dass sie wahrheitsgemäß und genau sind, doch Fehler sind nicht auszuschließen. Es sei besonders darauf hingewiesen, dass der Krypto-Asset-Markt häufig eine Diskrepanz zwischen den Fundamentaldaten von Projekten und der Preisentwicklung auf dem Sekundärmarkt aufweist. Der Inhalt dieses Artikels dient lediglich der Informationsintegration und dem akademischen/research Austausch und stellt keine Investitionsempfehlung dar und sollte nicht als Kauf- oder Verkaufsempfehlung für irgendeinen Token angesehen werden.