Wenn Agentensysteme versagen, sieht es anfangs selten nach einem Fehler aus.

Nichts stürzt ab. Nichts stoppt. Aufgaben laufen weiterhin. Entscheidungen werden weiterhin getroffen. Was sich ändert, ist schwerer zu messen. Dinge erfordern mehr Koordination als erwartet. Kleine Ausnahmen tauchen auf. Jemand muss „nur dieses eine Mal“ eingreifen.

Das ist normalerweise der Moment, in dem die Autonomie bereits zu erodieren beginnt.

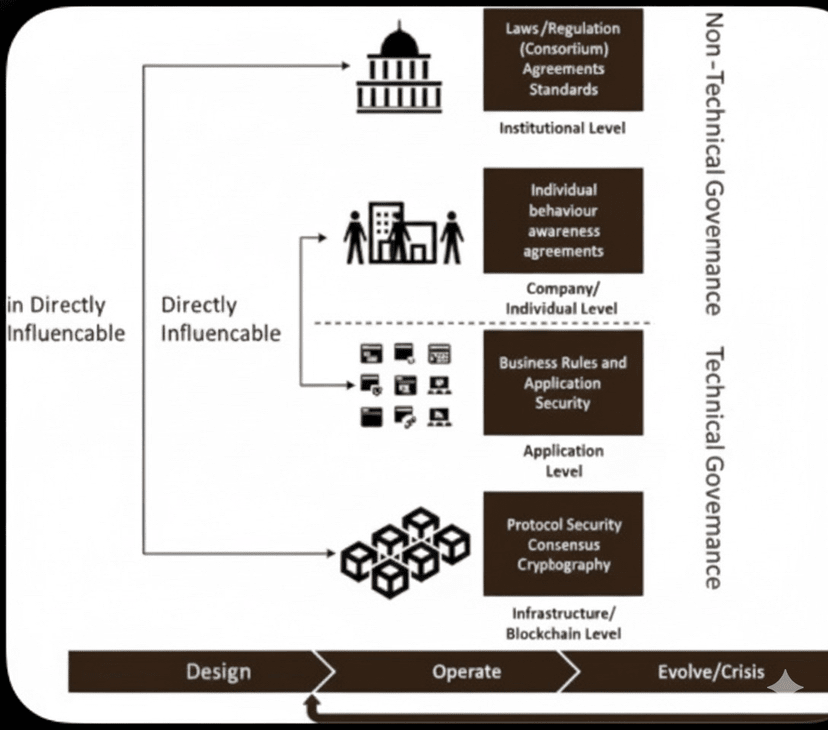

Der Fehler ist fast immer derselbe. Governance wird als etwas behandelt, das man hinzufügt, nachdem die Agenten bewiesen haben, dass sie funktionieren. Zuerst kommt die Fähigkeit. Dann kommt die Skalierung. Governance soll später aufholen.

Es ist normalerweise nicht so.

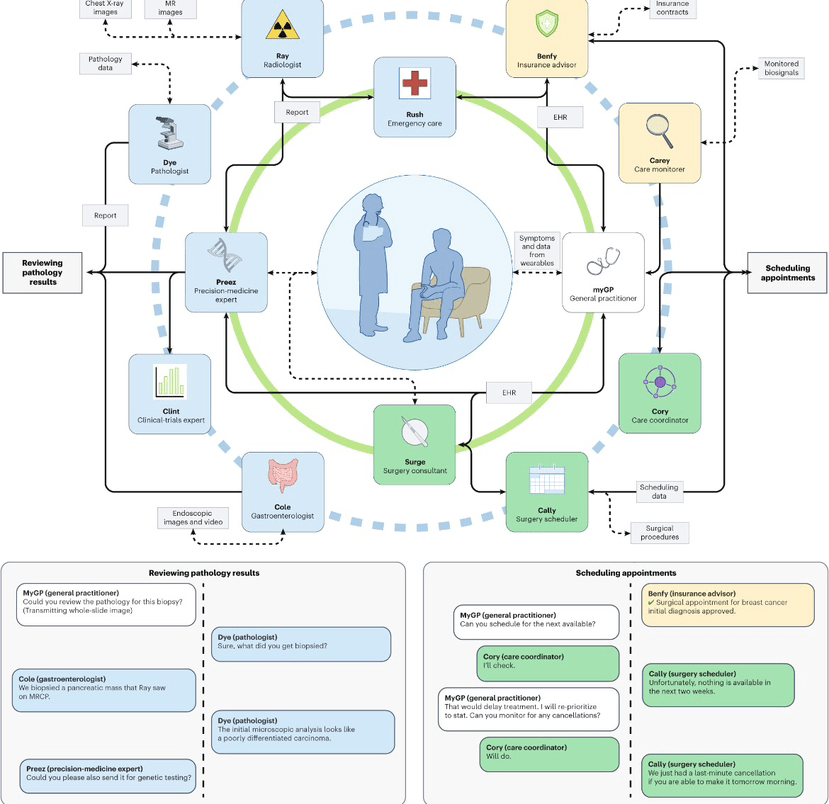

Wenn Agenten ohne feste Grenzen agieren, werden sie nicht über Nacht gefährlich. Sie werden inkonsistent. Jeder Agent folgt seiner eigenen Logik, die von lokalen Anreizen geprägt ist. Für sich genommen macht diese Logik Sinn. In Kombination schafft sie Überlappungen, Konflikte und Unsicherheiten darüber, wer tatsächlich für was verantwortlich ist.

In kleinem Maßstab fühlt sich das überschaubar an. In größerem Maßstab verwandelt es sich in Reibung. Es tauchen mehr Kontrollen auf. Mehr Überschreibungen. Mehr Regeln, die außerhalb des Systems geschrieben werden, weil das System selbst sie nicht sauber durchsetzen kann.

An diesem Punkt ist die Autonomie nicht gescheitert. Sie wurde stillschweigend ersetzt.

Der Kitesurfer geht von einer anderen Annahme aus. Governance ist keine Schicht, die man über das Verhalten von Agenten legt. Es ist etwas, das den Raum definiert, in dem Agenten von Anfang an agieren dürfen.

Identität spielt hier eine Rolle. Nicht als Etikett, sondern als Grenze. Ein Agent weiß, was er berühren kann, wo er handeln kann und wann er aufhören muss. Diese Grenzen werden nicht ad hoc verhandelt. Sie sind strukturell.

Diese Struktur verändert, wie Systeme skalieren. Die Strategie kann sich entwickeln, ohne Regeln neu zu schreiben. Neue Agenten können hinzugefügt werden, ohne die Unsicherheit zu vergrößern. Kontrolle erfordert keine ständige Intervention, weil sie bereits eingebettet ist.

Gut gestaltete Agentensysteme verlassen sich nicht darauf, dass Agenten sich gut verhalten. Sie verlassen sich darauf, dass Agenten auf klare, vorhersehbare Weise eingeschränkt sind.

Die meisten Systeme verlieren die Kontrolle nicht, weil Agenten zu fähig werden, sondern weil niemand entschieden hat, wo diese Fähigkeit enden sollte.