最近,我密集访谈了数位在 OpenGradient、FLock.io 以及 io.net 等前沿AI项目中的核心工程师。我们的话题围绕一个核心:在构建去中心化AI的实践中,最大的痛点究竟是什么?

答案出乎意料地一致:可靠、可编程且经济的数据与模型生命周期管理。

这让我彻底理解了 Walrus 这一系列AI合作背后的深层逻辑。这并非简单的商务拓展,而是一场针对AI未来基础设施的合谋。

行业正在从“如何让AI模型上链”的初级问题,转向“如何让AI在去中心化世界里持续、安全、进化地生存”。

这一篇,我将结合一线构建者的洞察,剖析 Walrus 如何成为去中心化AI堆栈中缺失的关键一层,并论证这为何是一条通向更强大、更可信AI的必然路径。

第一,中心化AI的“阿喀琉斯之踵”:数据孤岛、黑箱与单点故障

当前的AI繁荣建立在中心化云之上,这带来了结构性缺陷:

数据垄断与孤岛:最有价值的训练数据被巨头锁在私有服务器中,社区创新难以获取高质量语料,导致模型多样性贫乏。

过程黑箱:模型的训练数据来源、参数调整过程不透明,导致偏见、歧视无法被审计和纠正。

单点故障风险:模型和服务集中于少数云提供商,面临监管封锁、服务中断、单方面修改API等风险。

激励错配:数据贡献者(用户)和算力贡献者(研究者)难以从AI创造的价值中获得合理回报。

去中心化AI试图解决这些问题,但其道路上的“绊脚石”正是存储。

第二,去中心化AI的存储悖论:对存储的苛刻要求

一个可行的去中心化AI系统,对存储层提出了近乎矛盾的要求:

要求一:海量且廉价。大模型参数动辄数百GB,训练数据集则以TB、PB计。成本必须低于中心化云,才有替代吸引力。

要求二:高可用与快速读取。训练和推理需要频繁读取模型参数和数据,延迟必须低,吞吐量必须高。

要求三:可验证与不可篡改。模型的版本、训练所用的数据哈希必须被永久、可验证地记录,以确保可复现性和可信度。

要求四:隐私与权限控制。专有模型和敏感训练数据必须被加密存储,并能进行复杂的访问授权(如“仅限付费推理10次”)。

要求五:可组合与可编程。模型应该能像DeFi乐高一样,被其他智能合约调用、组合、并基于使用情况自动结算。

传统的去中心化存储方案,往往只能满足其中一两点,直到 Walrus 出现。

第三,Walrus 如何成为去中心化AI的“基座内存”

Walrus 的技术特性,恰好系统性满足了上述要求,它扮演的角色远不止硬盘。

角色一:模型的去中心化注册表与版本库

在 OpenGradient 的实践中,每个AI模型在训练完成后,其参数文件被上传至 Walrus,生成一个唯一的 Sui 对象ID。

该ID与模型的元数据(架构、训练数据哈希、性能指标)一起被记录在链上。

这创造了一个全局可访问、可验证的模型库。任何人都可以通过对象ID拉取特定版本的模型进行验证或微调,彻底解决了模型的可复现性问题。

角色二:支持隐私计算的训练数据仓库

FLock.io 的联邦学习场景中,各参与方的本地数据从不离开本地。

但用于协调训练的全局模型参数和加密的梯度更新,需要中立的交换场所。

Walrus 提供了这个场所。结合类似 Seal 的隐私计算服务,Walrus 存储加密的中间参数,只有获得授权的计算节点才能解密处理。

存储、隐私计算、结算在同一个信任框架下完成。

角色三:连接存储与计算的“模型总线”

这是与 io.net 合作展现的颠覆性潜力。传统流程:在A处存储模型,在B处购买算力,手动传输文件,流程割裂。

Walrus + io.net 的 BYOM(自带模型)平台实现了:

开发者将加密模型存于 Walrus -> 在 io.net 市场选择算力 -> 智能合约自动授权所选GPU节点读取该模型 -> 节点拉取模型进行推理/训练 -> 结果存回 Walrus -> 自动结算。

存储层与计算层通过智能合约实现了原子级的无缝衔接。 数据流变成了可编程的工作流。

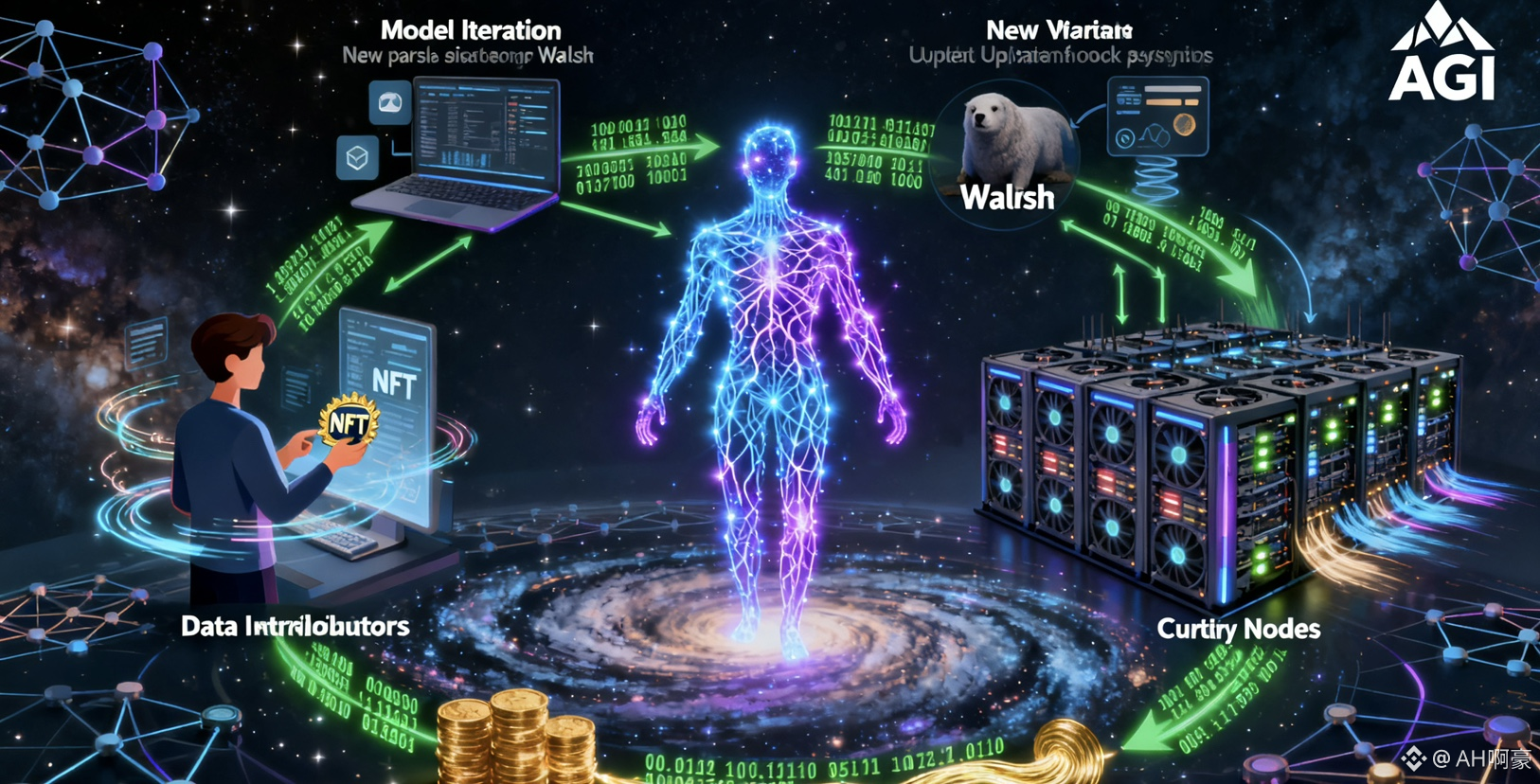

角色四:激励数据贡献的经济层

未来的想象:一个旨在训练垂直领域模型(如医学影像)的DAO,可以发起数据征集。

贡献者将加密的数据样本存于 Walrus,并获得代表贡献凭证的 NFT。

模型训练成功后,其收入的一部分会根据 NFT 自动分配给早期数据贡献者。

Walrus 在此不仅是存储,更是贡献的确权与价值分配的基础设施。

第四,案例深解:OpenGradient 迁移的启示

OpenGradient 从 IPFS 迁移至 Walrus,是一个极具代表性的技术决策。

IPFS 的局限性:内容寻址很棒,但文件是静态的。要实现对私有模型的付费访问,需要构建一整套链下的权限管理和密钥分发系统,复杂且易成为攻击点。

Walrus 的解决方案:

模型上传时,即可通过 Move 智能合约定义访问策略(例如:持有特定通行证 NFT 的地址方可解密)。

该策略与数据对象本身在链上绑定。

当用户支付费用后,获得一个访问凭证(也是一个链上对象),凭此从 Walrus 节点读取解密后的模型。

整个权限流程实现了链上化和自动化,安全性和用户体验得到质的提升。

这标志着去中心化AI从“存储模型”进入了“运营模型”的新阶段。

第五,未来图景:当AI智能体住在Walrus上

展望未来,Walrus 可能催生更激动人心的AI形态:

自主进化的AI模型:

一个部署在 Walrus 上的模型,其智能合约可以编程:将推理收入的一部分自动用于支付 io.net 上的微调算力,使用最新的用户反馈数据对自己进行迭代,然后将新版本参数再次存回 Walrus。

模型实现了基于经济激励的自我驱动进化。

可组合的AI服务市场:

Walrus 上存储着各种专用模型(文本摘要、图像生成、代码审计)。

开发者可以通过一个智能合约,将这些模型像函数一样串联起来,构建复杂应用(如:读取社交媒体内容->摘要->情感分析->生成回复图像)。

每一次调用都自动完成链上结算。Walrus 成为AI服务的可组合乐高仓库。

去中心化AI的身份与记忆:

一个为个人服务的AI助手,其记忆(用户偏好、历史对话)可以加密存储在用户自己控制的 Walrus 数据对象中。

用户可以在任何前端调用这个助手,它都能从 Walrus 加载记忆,提供连续的服务。

AI 打破了应用孤岛,成为了用户跨平台的数字人格延伸,而 Walrus 是承载这份记忆的载体。

第六,挑战与协同:构建完整的去中心化AI堆栈

Walrus 解决了存储问题,但去中心化AI的完全体还需要其他部件的成熟:

算力网络:需要 io.net 这样的项目提供稳定、低成本、可验证的算力。

隐私计算:需要 Seal 等方案确保训练和推理过程中的数据隐私。

数据来源:需要去中心化的数据市场或贡献机制,获得高质量、合规的训练数据。

预言机与验证:如何将链下AI推理结果可信地喂给链上合约,需要去中心化预言机网络的支撑。

Walrus 与这些项目的合作,正是在主动编织这张完整的网络。它将自己定位为这张网的数据交汇点与价值锚点。

总结:存储即智能,数据即进化

通过这场深入AI领域的解剖,我看到了 Walrus 更深层的野心:

它不仅仅想存储AI的“尸体”(静态模型文件),它想成为AI生命循环的栖息地。

在这个循环中:

数据被安全地滋养。

模型被透明地训练、验证和版本化。

价值沿着贡献链精确地流动。

智能体能够自主地成长和交互。

这与 Web3 的核心精神一脉相承:将关键基础设施公共化、可验证化、市场化,以释放更大的创新和协作潜力。

AI 的发展正处在从集中式爆发布局向分布式协同演进的关键节点。中心化云在启动阶段功不可没,但其固有的缺陷将成为下一阶段进步的桎梏。

Walrus 及其代表的去中心化存储范式,通过提供一条可信、开放、经济且可编程的数据路径,正在为AI的未来构建一个更坚实、更公平、也更富生命力的基础。

这或许是一场慢一些的革命,但它指向的,是一个真正由全球协作驱动、权属清晰、利益共享的智能未来。

在那里,AI 不是某个巨头的私有财产,而是生长在协议层上的公共福祉。而 Walrus,正致力于成为这片新大陆最肥沃的土壤。