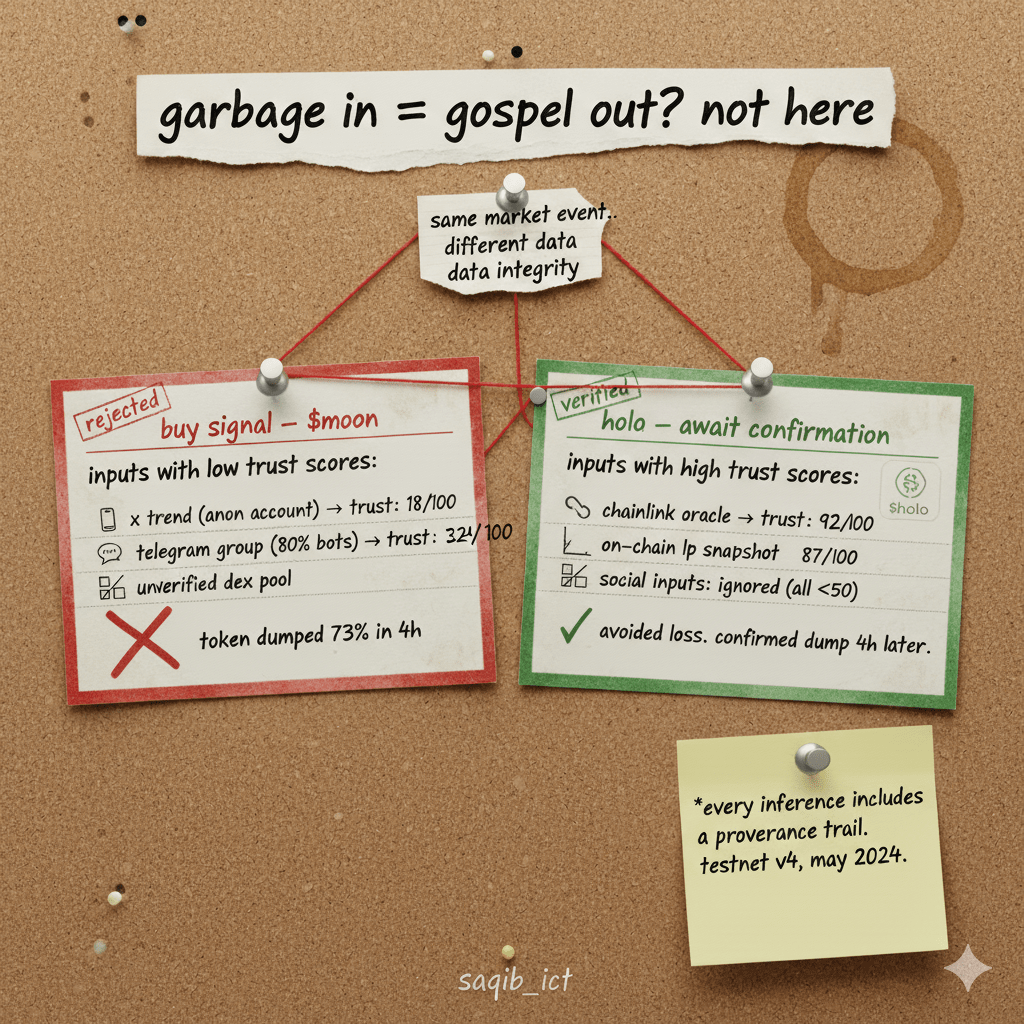

Ho testato 5 agenti AI on-chain quest'anno.

Tutte le “intelligence in tempo reale” rivendicate.

Tutti hanno fallito allo stesso modo: si sono fidati di dati sporchi.

Un prezzo estratto da un pool DEX manipolato.

Un altro ha utilizzato il sentimento sociale da gruppi Telegram pieni di bot.

Risultato? Falsi segnali. Decisioni sbagliate. Fiducia persa.

Poi ho approfondito @HoloworldAI l'ultimo testnet di Holoworld e ho trovato qualcosa di silenziosamente rivoluzionario:

uno strato di provenienza dei dati integrato che valuta ogni input in base all'affidabilità della fonte.

Ecco come funziona (e perché è importante):

🔹Non tutti i dati sono uguali. $HOLO I validatori di Holoworld non solo elaborano input, li valutano.

Oracolo Chainlink? → Punteggio di fiducia: 92/100

Pool DEX non verificato? → Punteggio di fiducia: 34/100

X post da un account anonimo? → Punteggio di fiducia: 18/100

🔹L'IA pesa il suo ragionamento di conseguenza.

Se l'80% delle fonti ad alta fiducia dice “rischioso,” ma bot a bassa fiducia urlano “MOON,” l'agente ignora il rumore. Questo non è filtraggio, è igiene epistemica.

Puoi ispezionare la lineage dei dati.

Ogni inferenza di Holoworld include una traccia di provenienza:

“Conclusione basata su:

• 3 oracoli verificati (media fiducia: 91)

• 2 snapshot di liquidità on-chain (fiducia: 87)

• 0 input sociali (tutti sotto la soglia di fiducia 50)”

Ho eseguito un test:

Ho fornito lo stesso scenario di mercato a @HoloworldAI $HOLO Holoworld e un altro “oracolo IA.”

L'altro ha segnalato un “segnale di acquisto” basato su tweet virali.

Holoworld ha detto: “Sentimento sociale inaffidabile. Aspetta la conferma on-chain.”

4 ore dopo, il “token virale” è crollato del 73%.

Questo è il confine silenzioso:

Holoworld non ragiona semplicemente, ragiona dalla verità.

In un ecosistema che affoga in dati manipolati,

la provenienza non è una caratteristica. È la fondazione.

Ed è per questo che protocolli seri lo scelgono non per l'IA,

ma per l'integrità dei suoi input.

#HoloworldAI #Holo #dataprovenance #OnChainAI