Autore: 0xjacobzhao | https://linktr.ee/0xjacobzhao

Questo rapporto indipendente è supportato da IOSG Ventures, grazie a Hans (RoboCup Asia-Pacific), Nichanan Kesonpat (1kx), Robert Koschig (1kx), Amanda Young (Collab+Currency), Jonathan Victor (Ansa Research), Lex Sokolin (Generative Ventures), Jay Yu (Pantera Capital), Jeffrey Hu (Hashkey Capital) per i preziosi suggerimenti forniti su questo articolo. Durante la stesura, sono stati consultati anche i team dei progetti OpenMind, BitRobot, peaq, Auki Labs, XMAQUINA, GAIB, Vader, Gradient, Tashi Network e CodecFlow per i loro feedback. Questo articolo cerca di mantenere contenuti obiettivi e accurati; alcune opinioni coinvolgono giudizi soggettivi, quindi non si può evitare una certa deviazione, si prega di comprendere.

I. Panorama robotico: dall'automazione industriale all'intelligenza umana

La catena di fornitura tradizionale dei robot ha formato un sistema stratificato completo dal basso verso l'alto, coprendo quattro fasi principali: componenti chiave - sistema di controllo intermedio - produzione dell'intero sistema - integrazione delle applicazioni. I componenti chiave (controllori, servomotori, riduttori, sensori, batterie, ecc.) presentano le barriere tecnologiche più elevate, determinando le prestazioni e il limite di costo dell'intero sistema; il sistema di controllo è il "cervello e il cervelletto" del robot, responsabile della pianificazione decisionale e del controllo del movimento; la produzione dell'intero sistema riflette la capacità di integrazione della catena di fornitura. L'integrazione del sistema e l'applicazione stanno diventando il nuovo nucleo di valore per la commercializzazione.

Secondo scenari applicativi e forme, i robot globali stanno evolvendo lungo il percorso "automazione industriale → intelligenza scenica → intelligenza generale", formando cinque principali tipi: robot industriali, robot mobili, robot di servizio, robot specializzati e robot umanoidi.

Robot industriali (Industrial Robots): attualmente l'unico settore completamente maturo, ampiamente applicato in saldatura, assemblaggio, verniciatura e movimentazione in vari passaggi di produzione. L'industria ha formato un sistema di catena di fornitura standardizzato, con margini di profitto stabili e ROI chiaro. Le sottocategorie includono i robot collaborativi (Cobots) che enfatizzano la cooperazione uomo-macchina, facili da implementare e in rapida crescita. Aziende rappresentative: ABB, Fanuc, Yaskawa, KUKA, Universal Robots, e altre.

Robot mobili (Mobile Robots): includono AGV (veicoli a guida automatica) e AMR (robot autonomi), ampiamente utilizzati nella logistica, nella distribuzione e nel trasporto di produzione, diventando la categoria più matura per il segmento B. Aziende rappresentative: Amazon Robotics, Geek+, Quicktron, Locus Robotics.

Robot di servizio (Service Robots): rivolti ai settori della pulizia, ristorazione, hotel e istruzione, sono il campo di crescita più veloce per il segmento consumer. I prodotti per la pulizia sono già entrati nella logica dell'elettronica di consumo, mentre la distribuzione medica e commerciale sta accelerando la commercializzazione. Inoltre, sta emergendo un gruppo di robot operativi più generali (come il sistema a doppio braccio di Dyna) — più flessibili rispetto a prodotti specifici per compiti, ma non ancora al livello di universalità dei robot umanoidi. Aziende rappresentative: Ecovacs, Roborock, Pudu Technology, Qianlong Intelligent, iRobot, Dyna, ecc.

Robot specializzati: servono principalmente settori come medicina, industria militare, costruzione, oceano e spaziale, con una scala di mercato limitata ma margini di profitto elevati e barriere forti, spesso dipendenti da ordini governativi e aziendali, in una fase di crescita verticale, progetti tipici includono Intuitive Surgical, Boston Dynamics, ANYbotics, NASA Valkyrie, ecc.

Robot umanoidi (Humanoid Robots): sono considerati la futura "piattaforma di lavoro universale". Le aziende rappresentative includono Tesla (Optimus), Figure AI (Figure 01), Sanctuary AI (Phoenix), Agility Robotics (Digit), Apptronik (Apollo), 1X Robotics, Neura Robotics, Unitree, UBTECH, ZhiYuan Robotics, ecc.

I robot umanoidi sono l'attuale direzione di avanguardia più monitorata, il cui valore centrale risiede nella capacità di adattare la struttura umana agli spazi sociali esistenti, considerati una forma chiave per raggiungere una "piattaforma di lavoro universale". A differenza dei robot industriali che perseguono l'efficienza estrema, i robot umanoidi enfatizzano l'adattabilità generale e la capacità di migrazione dei compiti, entrando in fabbriche, case e spazi pubblici senza la necessità di modifiche ambientali.

Attualmente, la maggior parte dei robot umanoidi è ancora nella fase di dimostrazione tecnica, principalmente verificando equilibrio dinamico, capacità di camminare e operare. Anche se alcuni progetti hanno iniziato a implementare piccole distribuzioni in scenari di fabbrica altamente controllati (come Figure × BMW, Agility Digit), si prevede che a partire dal 2026 più aziende (come 1X) entreranno nella distribuzione iniziale, ma questi rimangono applicazioni "limitati a scenari ristretti e compiti singoli", piuttosto che una vera e propria forza lavoro universale. Nel complesso, ci vorranno anni per raggiungere una commercializzazione su larga scala. I colli di bottiglia principali includono: problemi di controllo come la coordinazione a più gradi di libertà e l'equilibrio dinamico in tempo reale; problemi di consumo ed autonomia limitati dalla densità energetica delle batterie e dall'efficienza di guida; catene di percezione-decisione difficili da generalizzare in ambienti aperti; un significativo divario di dati (difficile da sostenere per l'addestramento di strategie generali); migrazione inter-corporea ancora da affrontare; e curve di costo e catena di fornitura hardware (soprattutto al di fuori della Cina) che rimangono ostacoli reali, aumentando ulteriormente la difficoltà di implementare distribuzioni su larga scala e a basso costo.

Si prevede che i percorsi di commercializzazione futuri attraverseranno tre fasi: nel breve termine, dominato da Demo-as-a-Service, dipendendo da piloti e sovvenzioni; nel medio termine, evolvendo in Robotics-as-a-Service (RaaS), costruendo un ecosistema di compiti e abilità; nel lungo termine, con il cloud di forza lavoro e i servizi di abbonamento intelligenti come nucleo, spostando il centro di valore dalla produzione di hardware a una rete di software e servizi. In generale, i robot umanoidi si trovano in una fase di transizione critica da dimostrazioni a auto-apprendimento, e se saranno in grado di superare le tre soglie di controllo, costo e algoritmo, determinerà se potranno realmente realizzare l'intelligenza incarnata.

II. AI × Robotica: L'alba dell'era dell'intelligenza incarnata

L'automazione tradizionale dipende principalmente dalla programmazione predefinita e dal controllo a catena (come l'architettura DSOP di percezione-pianificazione-controllo), operando in modo affidabile solo in ambienti strutturati. Tuttavia, il mondo reale è molto più complesso e variegato; la nuova generazione di intelligenza incarnata (Embodied AI) sta seguendo un altro paradigma: attraverso modelli di grandi dimensioni e apprendimento di rappresentazioni unificate, i robot possono acquisire capacità di "comprensione-previsione-azione" tra scenari. L'intelligenza incarnata enfatizza il dinamico accoppiamento di corpo (hardware) + cervello (modello) + ambiente (interazione), i robot sono il veicolo, mentre l'intelligenza è il nucleo.

L'AI generativa (Generative AI) appartiene al mondo del linguaggio, esperta nella comprensione dei simboli e del significato; l'intelligenza incarnata (Embodied AI) appartiene al mondo reale, esperta nella percezione e nell'azione. I due corrispondono rispettivamente a "cervello" e "corpo", rappresentando due linee evolutive parallele dell'AI. Dal punto di vista dei livelli di intelligenza, l'intelligenza incarnata è più elevata rispetto all'AI generativa, ma il suo grado di maturità è ancora chiaramente indietro. LLM dipende da enormi dati disponibili su Internet, formando un chiaro ciclo "dati → potenza di calcolo → implementazione"; mentre l'intelligenza robotica necessita di dati fortemente vincolati alla prima persona, multimodali e azioni — inclusi percorsi di controllo remoto, video in prima persona, mappe spaziali, sequenze di operazione, ecc., questi dati non esistono naturalmente, devono essere generati attraverso interazioni reali o simulazioni ad alta fedeltà, risultando quindi più scarsi e costosi. Sebbene la simulazione e i dati sintetici possano essere d'aiuto, non possono sostituire i sensori reali e l'esperienza del movimento, il che è anche il motivo per cui Tesla, Figure e altri devono costruire le proprie fabbriche di dati per il controllo remoto, e perché in Sud-est asiatico sono emerse fabbriche di annotazione dati di terze parti. In breve: LLM impara da dati pronti, mentre i robot devono "creare" dati interagendo con il mondo fisico. Nei prossimi 5-10 anni, i due si fonderanno a fondo nei modelli Vision–Language–Action e nelle architetture degli agenti incarnati — LLM si occuperà della cognizione e della pianificazione di alto livello, mentre i robot si occuperanno dell'esecuzione nel mondo reale, formando un ciclo bidirezionale tra dati e azioni, contribuendo a spostare l'AI da "intelligenza linguistica" a vera intelligenza generale (AGI).

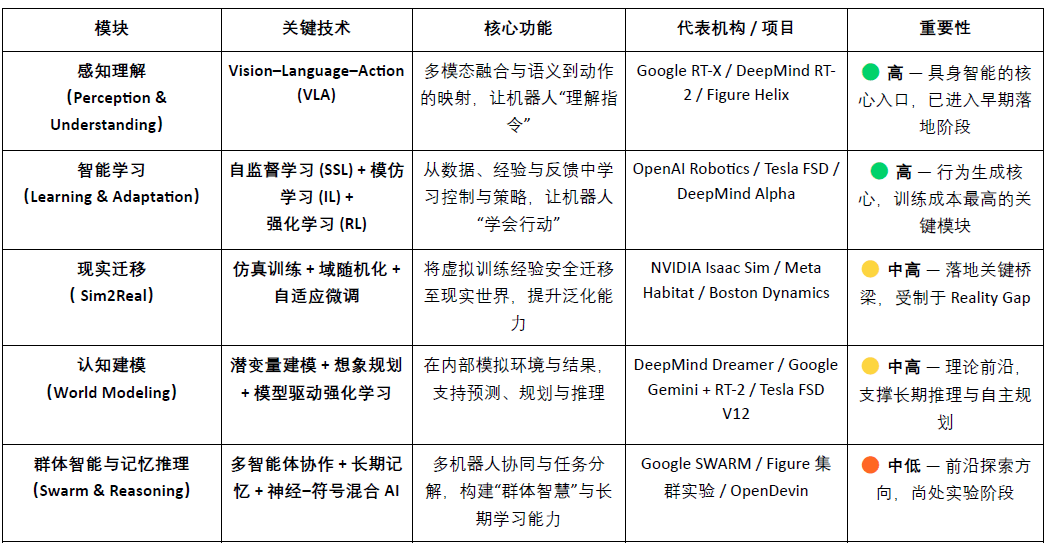

Il sistema tecnologico centrale dell'intelligenza incarnata può essere visto come uno stack intelligente dal basso verso l'alto: VLA (fusione percettiva), RL/IL/SSL (apprendimento intelligente), Sim2Real (migrazione reale), World Model (modellazione cognitiva), e collaborazione tra più agenti e ragionamento di memoria (Swarm & Reasoning). Tra questi, VLA e RL/IL/SSL sono il "motore" dell'intelligenza incarnata, determinando la sua implementazione e commercializzazione; Sim2Real e World Model sono tecnologie chiave che collegano l'addestramento virtuale all'esecuzione reale; la collaborazione tra più agenti e il ragionamento di memoria rappresentano un'evoluzione cognitiva e collettiva a un livello superiore.

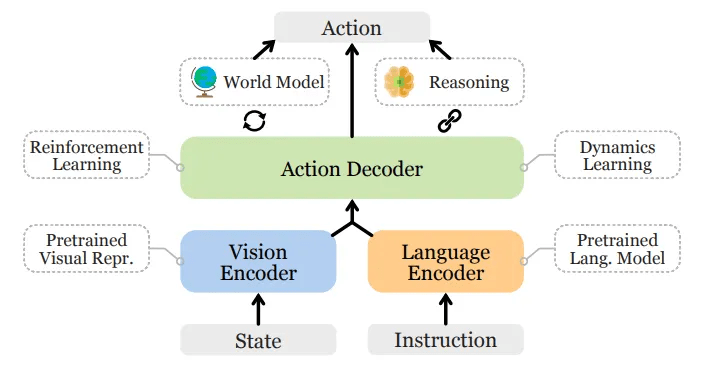

Comprensione della percezione: modello visivo-linguaggio-azione (Vision–Language–Action)

Il modello VLA integra visione (Vision) - linguaggio (Language) - azione (Action) in tre canali, consentendo ai robot di comprendere le intenzioni dal linguaggio umano e tradurle in azioni concrete. Il flusso di esecuzione comprende l'analisi semantica, il riconoscimento degli obiettivi (localizzazione di oggetti obiettivo dagli input visivi) e la pianificazione dei percorsi e l'esecuzione delle azioni, realizzando un ciclo di "comprendere il significato - percepire il mondo - completare il compito", essendo una delle principali innovazioni per l'intelligenza incarnata. I progetti attuali rappresentativi includono Google RT-X, Meta Ego-Exo e Figure Helix, che mostrano rispettivamente direzioni all'avanguardia di comprensione multimodale, percezione immersiva e controllo guidato dal linguaggio.

Architettura generale del modello Vision-Language-Action

Attualmente, VLA è ancora nelle fasi iniziali e affronta quattro categorie di colli di bottiglia fondamentali:

1) Ambiguità semantica e debole generalizzazione dei compiti: i modelli faticano a comprendere istruzioni vaghe e aperte;

2) Allineamento visivo e azione instabile: gli errori di percezione vengono amplificati nella pianificazione e nell'esecuzione del percorso;

3) Dati multimodali scarsi e standard non uniformi: i costi di raccolta e annotazione sono elevati, rendendo difficile formare un volano di dati su larga scala;

4) Sfide della timeline e dell'asse spaziale nei compiti a lungo termine: la durata eccessiva dei compiti porta a una pianificazione e capacità di memoria insufficienti, mentre un ambito spaziale troppo ampio richiede al modello di ragionare su cose "fuori dalla vista", attualmente VLA manca di un modello di mondo stabile e capacità di ragionamento interspaziale.

Questi problemi limitano la capacità di generalizzazione e l'avanzamento su larga scala di VLA.

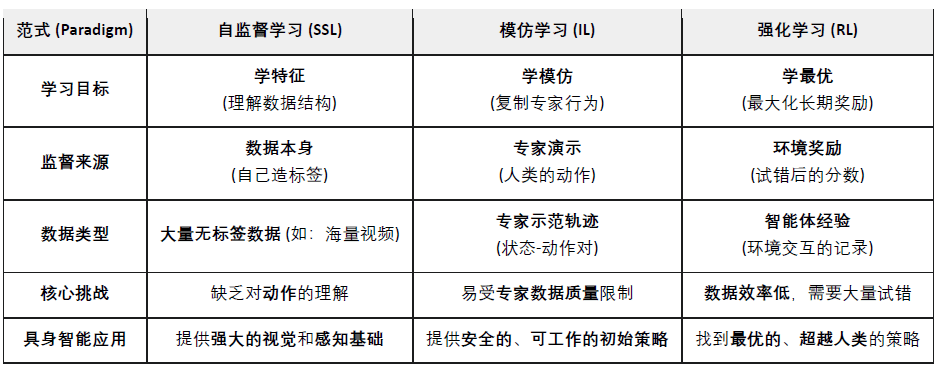

Apprendimento intelligente: Apprendimento autosupervisionato (SSL), Apprendimento per imitazione (IL) e Apprendimento per rinforzo (RL)

Apprendimento autosupervisionato (Self-Supervised Learning): estrarre automaticamente caratteristiche semantiche dai dati di percezione, consentendo ai robot di "comprendere il mondo". È come insegnare ai robot a osservare e rappresentare.

Apprendimento per imitazione (Imitation Learning): acquisire rapidamente abilità di base imitandosi a dimostrazioni umane o esempi di esperti. È come insegnare ai robot a comportarsi come gli umani.

Apprendimento per rinforzo (Reinforcement Learning): attraverso un meccanismo di "premio-punizione", i robot ottimizzano strategie di azione attraverso tentativi ed errori continui. È come insegnare ai robot a crescere attraverso tentativi ed errori.

Nell'intelligenza incarnata (Embodied AI), l'apprendimento autosupervisionato (SSL) mira a far prevedere ai robot i cambiamenti di stato e le leggi fisiche dai dati di percezione, comprendendo così la struttura causale del mondo; l'apprendimento per rinforzo (RL) è il motore centrale della formazione dell'intelligenza, ottimizzando le strategie di azione dei robot attraverso l'interazione con l'ambiente e il segnale di premio; l'apprendimento per imitazione (IL) accelera questo processo attraverso dimostrazioni umane, consentendo ai robot di acquisire rapidamente priorità di azione. Le direzioni principali attuali mirano a combinare i tre approcci, costruendo un quadro di apprendimento gerarchico: SSL fornisce una base di rappresentazione, IL conferisce priorità umane, RL guida l'ottimizzazione delle strategie, bilanciando efficienza e stabilità, formando insieme il meccanismo centrale dell'intelligenza incarnata dalla comprensione all'azione.

Migrazione reale: Sim2Real — il salto dalla simulazione alla realtà

Sim2Real (Simulation to Reality) consente ai robot di completare l'addestramento in ambienti virtuali e poi trasferirsi nel mondo reale. Genera grandi volumi di dati interattivi attraverso ambienti di simulazione ad alta fedeltà (come NVIDIA Isaac Sim & Omniverse, DeepMind MuJoCo), riducendo notevolmente i costi di addestramento e l'usura dell'hardware. Il suo obiettivo principale è ridurre il "divario di simulazione-realtà", i metodi principali includono:

Randomizzazione del dominio (Domain Randomization): regolare casualmente l'illuminazione, l'attrito, il rumore e altri parametri nella simulazione per migliorare la capacità di generalizzazione del modello;

Calibrazione della coerenza fisica: utilizzare dati di sensori reali per calibrare il motore di simulazione, aumentando il realismo fisico;

Micro-regolazione adattativa (Adaptive Fine-tuning): eseguire un rapido riaddestramento in ambienti reali per realizzare una migrazione stabile.

Sim2Real rappresenta il collegamento centrale per l'implementazione dell'intelligenza incarnata, consentendo ai modelli AI di apprendere il ciclo "percezione-decisione-controllo" in un mondo virtuale sicuro e a basso costo. Sim2Real è già maturo nell'addestramento di simulazione (come NVIDIA Isaac Sim, MuJoCo), ma la migrazione reale è ancora limitata dal Reality Gap, dai costi elevati di calcolo e annotazione, e dalla mancanza di generalizzazione e sicurezza in ambienti aperti. Tuttavia, Simulation-as-a-Service (SimaaS) sta diventando l'infrastruttura più leggera ma di maggiore valore strategico nell'era dell'intelligenza incarnata, il suo modello commerciale include abbonamenti alla piattaforma (PaaS), generazione di dati (DaaS) e verifica della sicurezza (VaaS).

Modellazione cognitiva: World Model — il "mondo interiore" del robot

Il modello di mondo (World Model) è il "cervello interno" dell'intelligenza incarnata, permettendo ai robot di simulare internamente gli ambienti e le conseguenze delle azioni, realizzando previsioni e ragionamenti. Apprende le dinamiche ambientali costruendo rappresentazioni interne prevedibili, consentendo all'agente di "provare" il risultato prima dell'esecuzione, evolvendo da esecutore passivo a ragionatore attivo. Progetti rappresentativi includono DeepMind Dreamer, Google Gemini + RT-2, Tesla FSD V12, NVIDIA WorldSim, ecc. Percorsi tecnologici tipici includono:

Modellazione delle dinamiche latenti (Latent Dynamics Modeling): comprimere percezioni ad alta dimensione in spazi di stato latente;

Addestramento di immaginazione per previsione temporale (Imagination-based Planning): tentativi virtuali e previsione dei percorsi nel modello;

Apprendimento per rinforzo basato sul modello (Model-based RL): utilizzare il modello del mondo per sostituire l'ambiente reale, riducendo i costi di addestramento.

Il modello di mondo (World Model) si trova all'avanguardia teorica dell'intelligenza incarnata, essendo il percorso centrale che consente ai robot di passare da intelligenza "reattiva" a "predittiva", ma è ancora limitato da complessità di modellazione, instabilità delle previsioni a lungo termine e mancanza di standard unificati.

Intelligenza collettiva e ragionamento di memoria: dall'azione individuale alla cognizione collaborativa

La collaborazione tra più agenti (Multi-Agent Systems) e il ragionamento di memoria (Memory & Reasoning) rappresentano due direzioni importanti nell'evoluzione dell'intelligenza incarnata, da "intelligenza individuale" a "intelligenza collettiva" e "intelligenza cognitiva". Entrambi sostengono la capacità di apprendimento collaborativo e di adattamento a lungo termine dei sistemi intelligenti.

Collaborazione tra più agenti (Swarm / Cooperative RL):

Riguarda più agenti che, all'interno di un ambiente condiviso, raggiungono decisioni collaborative e assegnazioni di compiti attraverso l'apprendimento per rinforzo distribuito o collaborativo. Questo settore ha già una base di ricerca solida, ad esempio l'esperimento OpenAI Hide-and-Seek ha dimostrato la collaborazione spontanea e l'emergere di strategie tra più agenti, gli algoritmi DeepMind QMIX e MADDPG forniscono un framework collaborativo per l'addestramento centralizzato e l'esecuzione decentralizzata. Questi metodi sono stati verificati in scenari come la pianificazione di robot di magazzino, ispezione e controllo di gruppo.

Memoria e ragionamento (Memory & Reasoning):

Concentrarsi sul dare agli agenti memoria a lungo termine, comprensione del contesto e capacità di ragionamento causale è una direzione chiave per realizzare la migrazione tra compiti e la pianificazione autonoma. Le ricerche tipiche includono DeepMind Gato (agenti multi-task con percezione-linguaggio-controllo unificati) e la serie DeepMind Dreamer (pianificazione immaginativa basata su un modello di mondo), così come agenti aperti come Voyager, che realizzano un apprendimento continuo attraverso memoria esterna ed evoluzione autonoma. Questi sistemi pongono le basi per i robot per avere la capacità di "ricordare il passato e prevedere il futuro".

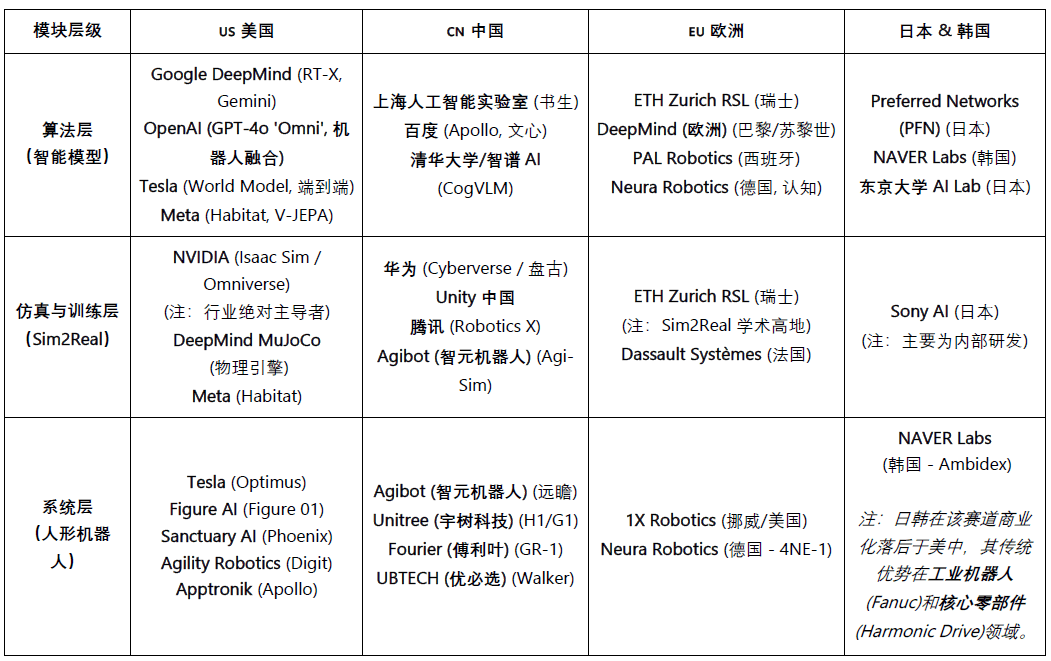

Il panorama globale dell'intelligenza incarnata: cooperazione e competizione coesistono

L'industria robotica globale è attualmente in una fase di "cooperazione dominante, competizione in profondità". L'efficienza della catena di approvvigionamento cinese, la capacità AI degli Stati Uniti, la precisione dei componenti giapponesi e gli standard industriali europei plasmano insieme il paesaggio a lungo termine dell'industria robotica globale.

Gli Stati Uniti mantengono una posizione di leadership nei modelli AI e nel software all'avanguardia (DeepMind, OpenAI, NVIDIA), ma questo vantaggio non si è esteso all'hardware robotico. Le aziende cinesi hanno vantaggi superiori in termini di velocità di iterazione e prestazioni in scenari reali. Gli Stati Uniti stanno promuovendo il rimpatrio industriale attraverso (Chip Act) e (Inflation Reduction Act) .

La Cina ha formato un vantaggio competitivo nei componenti, nelle fabbriche automatizzate e nei robot umanoidi grazie alla produzione su larga scala, all'integrazione verticale e alla spinta politica, con capacità eccezionali in hardware e catena di approvvigionamento, aziende come Yushu e UBTECH hanno già raggiunto la produzione su larga scala, estendendosi verso il livello di decisione intelligente. Tuttavia, esiste ancora un notevole divario rispetto agli Stati Uniti nei livelli di algoritmi e simulazione.

Il Giappone ha monopolizzato per lungo tempo i componenti ad alta precisione e la tecnologia di controllo del movimento, con un sistema industriale solido, ma l'integrazione dei modelli AI è ancora nella fase iniziale, con un ritmo di innovazione relativamente stabile.

La Corea del Sud si distingue nella diffusione dei robot di consumo, guidata da aziende come LG e NAVER Labs, e dispone di un sistema ecologico di robot di servizio maturo e robusto.

L'Europa ha un sistema ingegneristico e standard di sicurezza completi, con aziende come 1X Robotics attive nella fase di ricerca e sviluppo, ma alcune fasi di produzione sono delocalizzate, con il baricentro dell'innovazione che si sposta verso la collaborazione e la standardizzazione.

III. Robot × AI × Web3: visione narrativa e percorsi reali

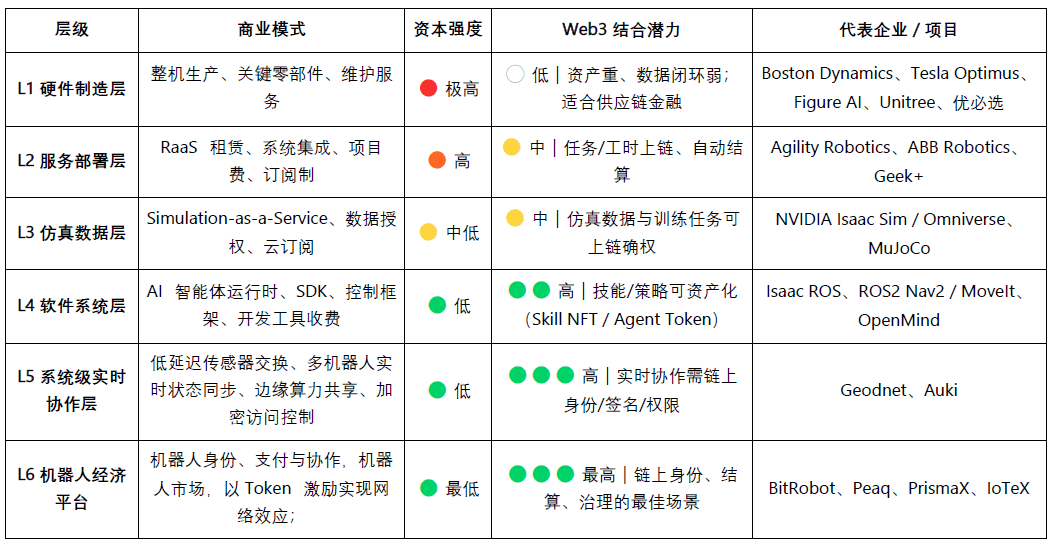

Nel 2025, l'industria Web3 vedrà emergere una nuova narrazione in fusione con robotica e AI. Sebbene Web3 sia visto come il protocollo di base per l'economia delle macchine decentralizzate, il valore e la fattibilità della sua combinazione a diversi livelli mostrano ancora chiare disomogeneità:

La produzione di hardware e il livello di servizio sono capital-intensive e con cicli di dati deboli; attualmente Web3 può solo svolgere un ruolo di supporto nei margini come la finanza della catena di approvvigionamento o il noleggio di dispositivi;

L'allineamento tra il livello di simulazione e software è più elevato; i dati di simulazione e i compiti di addestramento possono essere attestati on-chain, mentre gli agenti e i moduli di abilità possono anche essere assetizzati tramite NFT o Token per agenti.

A livello di piattaforma, la rete decentralizzata di lavoro e collaborazione mostra il massimo potenziale — Web3 può costruire gradualmente un "mercato del lavoro robotico" affidabile attraverso meccanismi integrati di identità, incentivazione e governance, stabilendo le fondamenta istituzionali per la futura economia delle macchine.

Da una prospettiva a lungo termine, la fusione della robotica con AI e Web3 mira a costruire un sistema economico decentralizzato delle macchine (DeRobot Economy), spingendo l'intelligenza incarnata da "automazione su singola macchina" a "collaborazione di rete verificabile, liquidabile e governabile". La logica centrale è formare un meccanismo di auto-riciclo attraverso "Token → Implementazione → Dati → Ridefinizione del valore", consentendo a robot, sensori e nodi di calcolo di ottenere diritti, scambiare e distribuire profitti.

A livello di identità, le macchine devono avere un'identità digitale verificabile e tracciabile. Attraverso Machine DID, ogni robot, sensore o drone può generare un "documento d'identità" unico e verificabile on-chain, legando la sua proprietà, le registrazioni delle azioni e l'ambito delle autorizzazioni, realizzando interazioni sicure e definizione della responsabilità.

A livello di fiducia, la chiave è rendere il "lavoro delle macchine" verificabile, misurabile e valutabile. Utilizzando contratti intelligenti, oracoli e meccanismi di audit, combinati con prove di lavoro fisico (PoPW), ambienti di esecuzione affidabili (TEE) e prove a zero conoscenza (ZKP), è possibile garantire l'autenticità e la tracciabilità del processo di esecuzione dei compiti, conferendo valore economico ai comportamenti delle macchine.

Nella layer di incentivazione, Web3 realizza la regolazione automatica e il flusso di valore tra macchine attraverso un sistema di incentivi basato su Token, astrazione degli account e canali di stato. I robot possono completare il noleggio di potenza di calcolo e la condivisione dei dati tramite micropagamenti, garantendo l'adempimento dei compiti attraverso meccanismi di staking e punizione; grazie a contratti intelligenti e oracoli, può anche formarsi un "mercato di cooperazione tra macchine" decentralizzato senza necessità di coordinamento umano.

Nella layer di governance, quando le macchine acquisiscono la capacità di autogoverno a lungo termine, Web3 fornisce un framework di governance trasparente e programmabile: gestire i parametri del sistema decisionale condiviso tramite DAO, mantenere sicurezza e ordine tramite meccanismi di multi-firma e reputazione. A lungo termine, questo porterà la società delle macchine verso la fase di "governance algoritmica" — gli esseri umani stabiliscono obiettivi e confini, e le macchine mantengono incentivi e equilibrio attraverso contratti.

La visione finale della fusione di Web3 e robotica: una rete di valutazione dell'ambiente reale - un "motore di ragionamento del mondo reale" composto da robot distribuiti, che testano continuamente le capacità dei modelli in scenari fisici vari e complessi; e un mercato della forza lavoro robotica - robot che eseguono compiti reali verificabili a livello globale, guadagnando tramite liquidazioni on-chain e reinvestendo il valore in potenza di calcolo o aggiornamenti hardware.

Da una prospettiva di percorso reale, la combinazione di intelligenza incarnata e Web3 è ancora nella fase iniziale di esplorazione, l'economia decentralizzata delle macchine intelligenti è rimasta maggiormente a livello di narrazione e comunità. Nella realtà, le direzioni di fusione con potenziale pratico si manifestano principalmente in tre aspetti:

(1) Crowdsourcing dei dati e verifica — Web3 incoraggia i contributori a caricare dati reali attraverso meccanismi di incentivazione e tracciamento on-chain;

(2) Partecipazione globale a lungo termine — i pagamenti transfrontalieri a basso costo e i meccanismi di micro-incentivazione riducono efficacemente i costi di raccolta e distribuzione dei dati;

(3) Finanziarizzazione e innovazione collaborativa — il modello DAO può promuovere l'assetizzazione dei robot, la certificazione dei diritti di rendimento e i meccanismi di liquidazione tra macchine.

In generale, nel breve termine ci si concentrerà principalmente sulla raccolta di dati e il livello di incentivazione; nel medio termine ci si aspetta una rottura nei livelli di "pagamento in stablecoin + aggregazione di dati a lungo termine" e nella tokenizzazione e liquidazione di RaaS; nel lungo termine, se i robot umanoidi saranno ampiamente diffusi, Web3 potrebbe diventare la base sistemica per la proprietà delle macchine, distribuzione dei profitti e governance, promuovendo la reale formazione di un'economia delle macchine decentralizzata.

IV. Mappa ecologica dei robot Web3 e casi selezionati

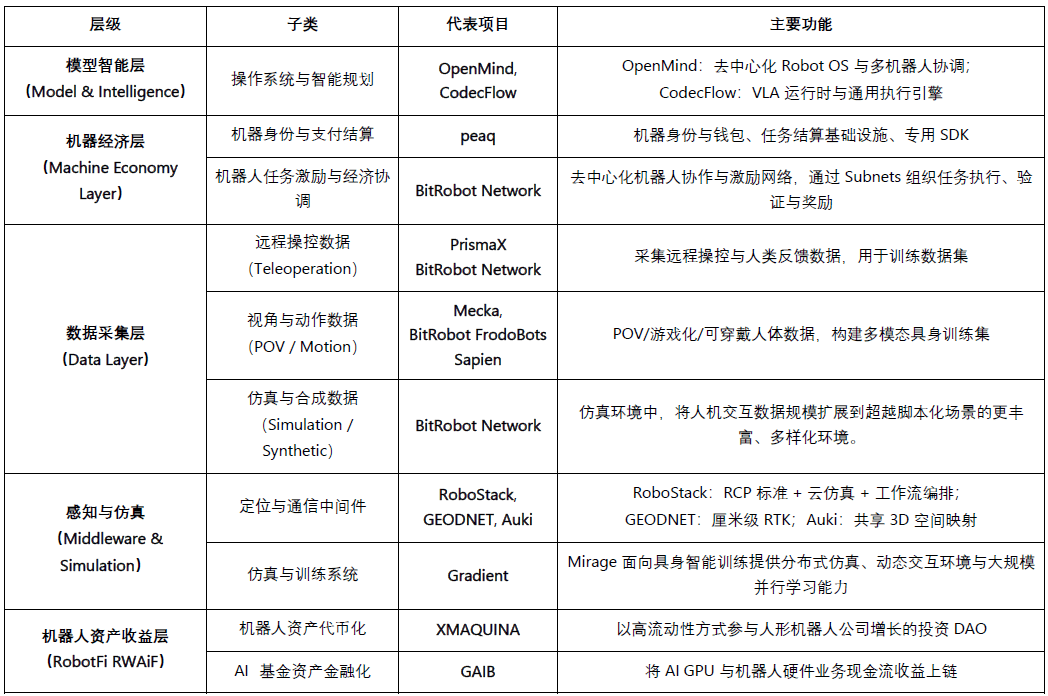

Basato su tre criteri di "progresso verificabile, apertura tecnologica, pertinenza industriale", abbiamo esaminato i progetti rappresentativi attuali di Web3 × Robotics e li abbiamo classificati in cinque livelli: livello di intelligenza del modello, livello dell'economia delle macchine, livello di raccolta dei dati, livello di base di percezione e simulazione, livello di rendimento degli asset robotici. Per mantenere l'oggettività, abbiamo escluso progetti chiaramente "opportunistici" o con dati insufficienti; se ci sono omissioni, sono benvenute correzioni.

Livello di intelligenza del modello (Model & Intelligence)

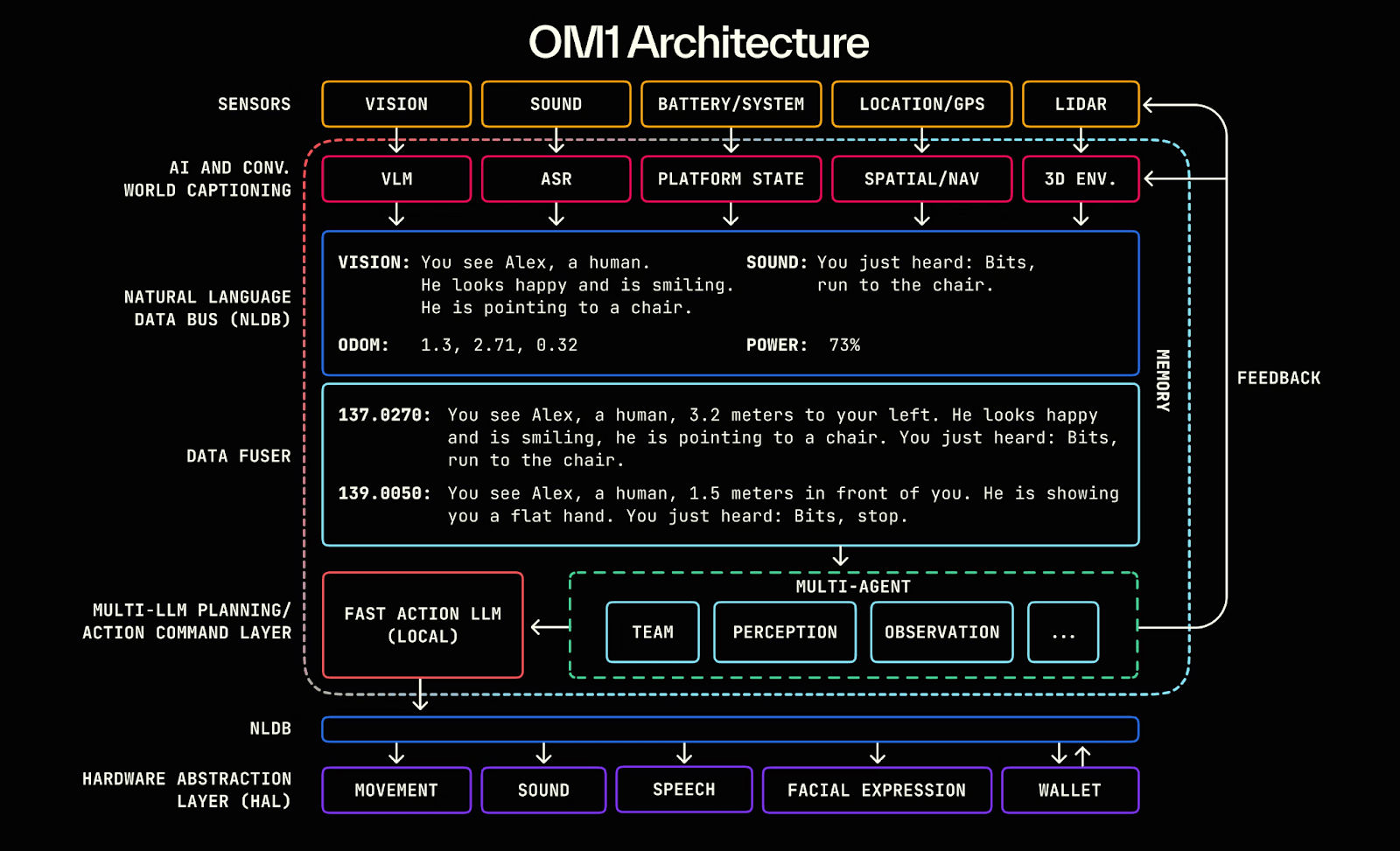

Openmind - Costruire Android per i Robot (https://openmind.org/)

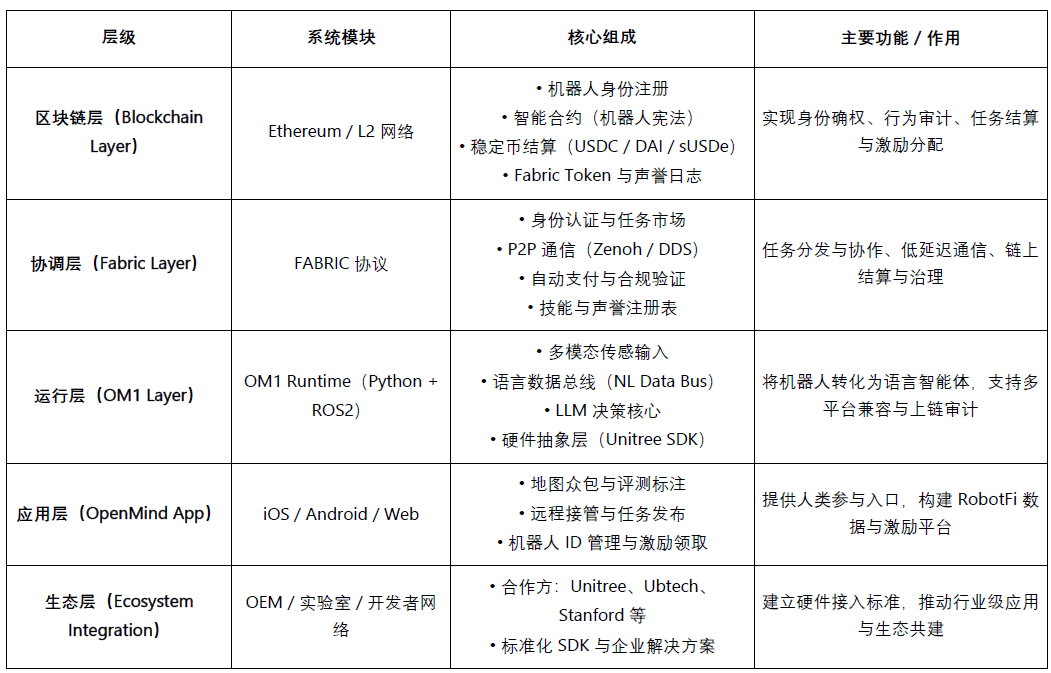

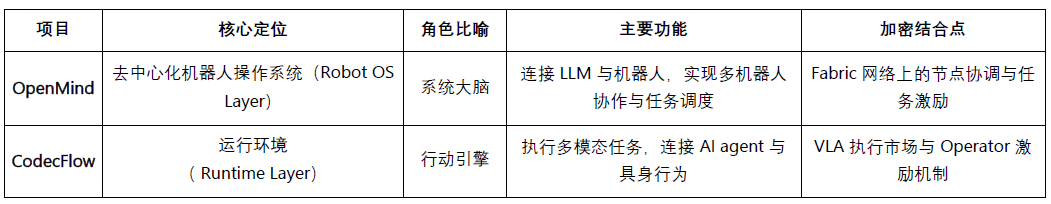

OpenMind è un sistema operativo open source (Robot OS) dedicato all'intelligenza incarnata (Embodied AI) e al controllo dei robot, con l'obiettivo di costruire il primo ambiente operativo per robot decentralizzati e una piattaforma di sviluppo globale. Il nucleo del progetto comprende due componenti principali:

OM1: un'intelligenza artificiale modulare open source runtime costruita su ROS2 (AI Runtime Layer), utilizzata per orchestrare pipeline di percezione, pianificazione e azione, servendo robot digitali e fisici;

FABRIC: layer di coordinamento distribuito (Fabric Coordination Layer), collega la potenza di calcolo cloud, i modelli e i robot reali, consentendo agli sviluppatori di controllare e addestrare i robot in un ambiente unificato.

Il nucleo di OpenMind è quello di fungere da livello intermedio intelligente tra LLM (grandi modelli di linguaggio) e il mondo dei robot, trasformando realmente l'intelligenza linguistica in intelligenza incarnata (Embodied Intelligence), costruendo uno scheletro intelligente che va dalla comprensione (Language → Action) all'allineamento (Blockchain → Rules). Il sistema multilivello di OpenMind realizza un ciclo completo di collaborazione: gli umani forniscono feedback e annotazioni attraverso l'app OpenMind (dati RLHF), la rete Fabric si occupa della verifica dell'identità, della distribuzione dei compiti e del coordinamento della liquidazione, i robot OM1 eseguono i compiti e seguono la "costituzione robotica" sulla blockchain per completare l'audit delle azioni e il pagamento, realizzando così una rete di collaborazione robotica decentralizzata di feedback umano → collaborazione sui compiti → liquidazione on-chain.

Progresso del progetto e valutazione della realtà

OpenMind si trova in una fase iniziale di "tecnologia operativa, commercializzazione non realizzata". Il sistema centrale OM1 Runtime è già open source su GitHub, può funzionare su più piattaforme e supporta input multimodali, realizzando la comprensione dei compiti dal linguaggio all'azione attraverso un bus di dati in linguaggio naturale (NLDB), presenta un alto livello di originalità ma rimane prevalentemente sperimentale, la rete Fabric e la liquidazione on-chain hanno solo completato la progettazione del livello di interfaccia.

Ecologicamente, il progetto ha collaborato con hardware open come Unitree, Ubtech, TurtleBot e università come Stanford, Oxford, Seoul Robotics, principalmente per validazione educativa e di ricerca, senza attualmente una commercializzazione. L'app è già stata lanciata in versione beta, ma le funzionalità di incentivazione e compito sono ancora nelle prime fasi.

In termini di modelli imprenditoriali, OpenMind ha costruito un ecosistema a tre livelli composto da OM1 (sistema open source) + Fabric (protocollo di liquidazione) + Skill Marketplace (livello di incentivazione), con attualmente nessun fatturato, basandosi su circa 20 milioni di dollari di finanziamento iniziale (Pantera, Coinbase Ventures, DCG). In generale, la tecnologia è avanzata, ma la commercializzazione e l'ecosistema sono ancora nelle fasi iniziali, se Fabric avrà successo, potrebbe diventare "l'Android dell'era dell'intelligenza incarnata", ma il ciclo è lungo, il rischio elevato e la dipendenza dall'hardware forte.

CodecFlow - Il motore di esecuzione per la robotica (https://codecflow.ai)

CodecFlow è un protocollo decentralizzato di layer di esecuzione basato sulla rete Solana (Fabric), progettato per fornire ambienti operativi on-demand per gli agenti AI e i sistemi robotici, consentendo a ciascun agente di avere una "macchina istantanea (Instant Machine)". Il nucleo del progetto è composto da tre moduli:

Fabric: layer di aggregazione della potenza di calcolo cross-cloud (Weaver + Shuttle + Gauge), capace di generare in pochi secondi macchine virtuali sicure, contenitori GPU o nodi di controllo robotico per i compiti AI;

SDK optr: framework di esecuzione per agenti (interfaccia Python), per creare "Operator" per robot desktop, simulati o reali operabili;

Incentivi in Token: layer di incentivazione e pagamento on-chain, che connette fornitori di calcolo, sviluppatori di agenti e utenti di compiti automatizzati, formando un mercato decentralizzato di potenza di calcolo e compiti.

L'obiettivo principale di CodecFlow è costruire una "base di esecuzione decentralizzata per AI e operatori robotici", consentendo a qualsiasi agente di funzionare in modo sicuro in qualsiasi ambiente (Windows / Linux / ROS / MuJoCo / controller robotici), realizzando un'architettura di esecuzione universale da programmazione della potenza (Fabric) → ambiente di sistema (System Layer) → percezione e azione (VLA Operator).

Progresso del progetto e valutazione della realtà

È stata rilasciata una versione iniziale del framework Fabric (Go) e dell'SDK optr (Python), che possono avviare istanze di potenza isolata in un ambiente web o da linea di comando. Si prevede che il mercato degli operatori sarà lanciato entro la fine del 2025, posizionandosi come layer di esecuzione decentralizzata per la potenza AI.

I principali destinatari includono sviluppatori AI, team di ricerca robotica e aziende di automazione operativa.

Livello dell'economia delle macchine (Machine Economy Layer)

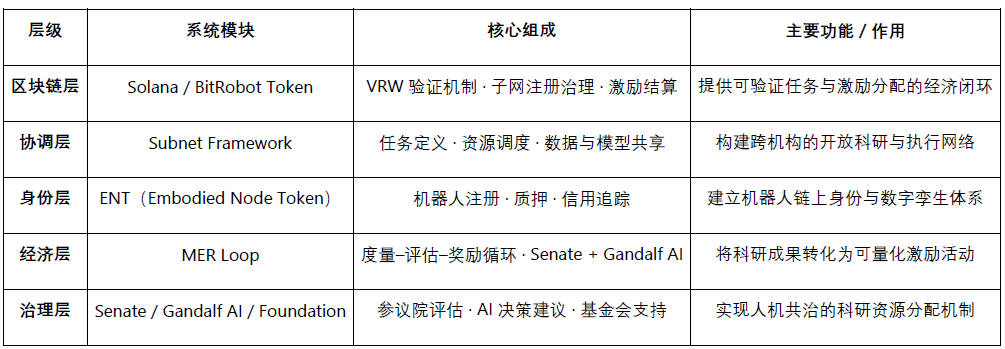

BitRobot - Il laboratorio di robotica open source del mondo (https://bitrobot.ai)

BitRobot è una rete decentralizzata di ricerca e collaborazione focalizzata sull'intelligenza incarnata (Embodied AI) e lo sviluppo robotico (Open Robotics Lab), avviata da FrodoBots Labs e Protocol Labs. La sua visione centrale è: attraverso un'architettura aperta di "subnet (Subnets) + meccanismi di incentivazione + lavoro verificabile (VRW)", le funzioni principali includono:

Definire e verificare il vero contributo di ogni compito robotico secondo lo standard VRW (Verifiable Robotic Work);

Attribuire identità on-chain e responsabilità economica ai robot attraverso ENT (Embodied Node Token);

Organizzare la collaborazione transregionale tra ricerca, potenza di calcolo, dispositivi e operatori attraverso Subnets;

Realizzare decisioni di incentivazione e governance della ricerca "co-governance uomo-macchina" attraverso Senate + Gandalf AI.

Dal 2025, dopo la pubblicazione del white paper, BitRobot ha eseguito diverse subnet (come SN/01 ET Fugi, SN/05 SeeSaw by Virtuals Protocol), realizzando il controllo remoto decentralizzato e la raccolta di dati in scenari reali, e ha lanciato il fondo "Grand Challenges" da 5 milioni di dollari per promuovere competizioni di ricerca per lo sviluppo di modelli globali.

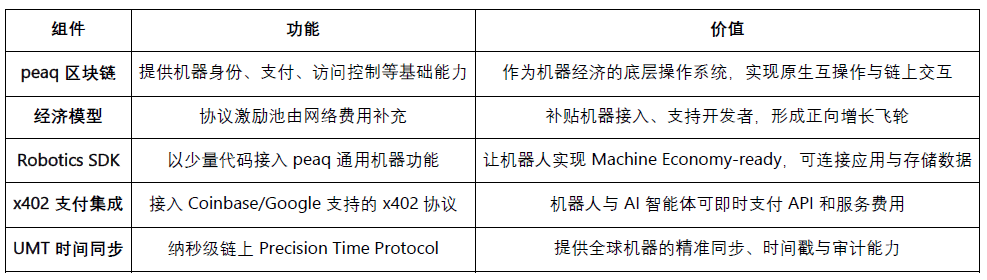

peaq – L'Economia delle Cose (https://www.peaq.network)

peaq è una blockchain Layer-1 progettata per l'economia delle macchine, fornendo identità di macchina, portafogli on-chain, controlli di accesso e sincronizzazione temporale a livello di nanosecondi (Universal Machine Time) per milioni di robot e dispositivi. Il suo Robotics SDK consente agli sviluppatori di rendere i robot "pronti per l'economia delle macchine" con pochissimo codice, garantendo interoperabilità e interazione tra diversi produttori e sistemi.

Attualmente, peaq ha lanciato il primo robot farm tokenizzato al mondo e supporta oltre 60 applicazioni robotiche reali. Il suo framework di tokenizzazione aiuta le aziende robotiche a raccogliere fondi per hardware a capitali intensivi e ad espandere le modalità di partecipazione da tradizionali B2B/B2C a livelli più ampi della comunità. Con un fondo di incentivazione a livello di protocollo iniettato da costi di rete, peaq può sovvenzionare l'integrazione di nuovi dispositivi e supportare gli sviluppatori, formando così un volano economico per accelerare l'espansione dei progetti di robotica e AI fisica.

Livello di raccolta dati (Data Layer)

Mirare a risolvere la scarsità e il costo elevato di dati di alta qualità nel mondo reale nella formazione dell'intelligenza incarnata. Raccogliere e generare dati di interazione uomo-macchina attraverso vari percorsi, inclusi il controllo remoto (PrismaX, BitRobot Network), video in prima persona e cattura di movimento (Mecka, BitRobot Network, Sapien, Vader, NRN) e dati simulati e sintetici (BitRobot Network), fornendo una base di addestramento scalabile e generalizzabile per i modelli robotici.

È importante chiarire che Web3 non è particolarmente abile nella "produzione di dati" — in termini di hardware, algoritmi e efficienza di raccolta, i giganti di Web2 superano di gran lunga qualsiasi progetto DePIN. Il suo vero valore risiede nel rimodellare i meccanismi di distribuzione e incentivazione dei dati. Basato su una rete di pagamento in stablecoin + modello di crowdsourcing, attraverso un sistema di incentivi senza permessi e meccanismi di verifica on-chain, consente liquidazioni a basso costo, tracciamento dei contributi e distribuzione automatica dei profitti. Tuttavia, il crowdsourcing aperto affronta ancora problemi di qualità e chiusura della domanda — la qualità dei dati varia notevolmente, mancando di una verifica efficace e di acquirenti stabili.

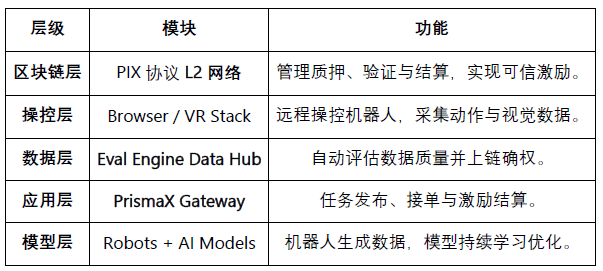

PrismaX (https://gateway.prismax.ai)

PrismaX è una rete decentralizzata di controllo remoto e economia dei dati per l'intelligenza incarnata (Embodied AI), progettata per costruire un "mercato globale del lavoro robotico", consentendo agli operatori umani, ai dispositivi robotici e ai modelli AI di co-evolvere tramite un sistema di incentivi on-chain. Il nucleo del progetto comprende due componenti principali:

Teleoperation Stack — sistema di controllo remoto (interfaccia web/VR + SDK), collega bracci meccanici globali e robot di servizio, realizzando il controllo e la raccolta di dati in tempo reale da parte degli esseri umani;

Eval Engine — motore di valutazione e verifica dei dati (CLIP + DINOv2 + valutazione semantica del flusso ottico), genera un punteggio di qualità per ogni traiettoria operativa e la liquidazione on-chain.

PrismaX trasforma il comportamento operativo umano in dati di apprendimento automatico attraverso un meccanismo di incentivazione decentralizzato, costruendo un ciclo completo da controllo remoto → raccolta di dati → addestramento di modelli → liquidazione on-chain, realizzando un'economia circolare in cui "il lavoro umano diventa un asset di dati".

Progresso del progetto e valutazione della realtà: PrismaX ha lanciato una versione beta nel agosto 2025 (gateway.prismax.ai), gli utenti possono controllare a distanza i bracci robotici per eseguire esperimenti di presa e generare dati di addestramento. Il motore di valutazione è attualmente in esecuzione interna, complessivamente, il livello di realizzazione tecnica di PrismaX è relativamente alto, con una chiara posizione, ed è il livello intermedio chiave che collega "operazioni umane × modelli AI × liquidazione blockchain". Il suo potenziale a lungo termine potrebbe diventare "il protocollo di lavoro e dati decentralizzato dell'era dell'intelligenza incarnata", ma a breve termine affronta ancora sfide di scalabilità.

BitRobot Network (https://bitrobot.ai/)

BitRobot Network realizza la raccolta di dati da molteplici fonti, come video, controllo remoto e simulazione attraverso le sue subnet. SN/01 ET Fugi consente agli utenti di controllare i robot per completare compiti, raccogliendo dati di navigazione e percezione in un'interazione simile a "Pokémon Go reale". Questo approccio ha portato alla creazione del dataset FrodoBots-2K, uno dei più grandi set di dati open source per la navigazione uomo-macchina, utilizzato da istituzioni come UC Berkeley RAIL e Google DeepMind. SN/05 SeeSaw (Virtual Protocol) raccoglie in grande scala dati video in prima persona in ambienti reali attraverso iPhone. Altre subnet già annunciate, come RoboCap e Rayvo, si concentrano sull'utilizzo di dispositivi fisici a basso costo per raccogliere dati video in prima persona.

Mecka (https://www.mecka.ai)

Mecka è un'azienda di dati per robot, che raccoglie video in prima persona, dati sui movimenti umani e dimostrazioni di compiti attraverso dispositivi mobili e hardware personalizzati, per costruire grandi set di dati multimodali, sostenendo l'addestramento di modelli di intelligenza incarnata.

Sapien (https://www.sapien.io/)

Sapien è una piattaforma di crowdsourcing incentrata su "dati di movimento umano che guidano l'intelligenza robotica", raccogliendo dati sulle azioni, posture e interazioni umane tramite dispositivi indossabili e applicazioni mobili, per addestrare modelli di intelligenza incarnata. Il progetto mira a costruire la rete di dati di movimento umano più grande del mondo, rendendo il comportamento naturale umano la base dei dati per l'apprendimento e la generalizzazione robotica.

Vader (https://www.vaderai.ai)

Vader raccoglie video in prima persona e dimostrazioni di compiti attraverso la sua applicazione MMO nel mondo reale, EgoPlay: gli utenti registrano le loro attività quotidiane in prima persona e ricevono ricompense $VADER. Il suo flusso di dati ORN può convertire le immagini POV grezze in set di dati strutturati elaborati per la privacy, contenenti etichette di azione e descrizione semantica, utilizzabili direttamente per l'addestramento delle strategie nei robot umanoidi.

NRN Agents (https://www.nrnagents.ai/)

Una piattaforma di dati RL incarnata gamificata, che crowdsourcing i dati dimostrativi umani attraverso il controllo dei robot via browser e competizioni di simulazione. NRN genera traiettorie di comportamento a lungo termine attraverso compiti "competitivi" da utilizzare per l'apprendimento per imitazione e l'apprendimento per rinforzo continuo, servendo come primordiale dato espandibile per sostenere l'addestramento delle strategie sim-to-real.

Confronto tra progetti di raccolta dati per intelligenza incarnata

Percezione e simulazione (Middleware & Simulation)

Il livello di percezione e simulazione fornisce l'infrastruttura di base centrale per collegare il mondo fisico e la decisione intelligente, compresi localizzazione, comunicazione, modellazione spaziale, addestramento di simulazione, ecc., ed è lo "scheletro intermedio" per costruire sistemi di intelligenza incarnata su larga scala. Attualmente, questo campo è ancora in fase di esplorazione iniziale, con progetti che formano disposizioni differenziate in direzioni come localizzazione ad alta precisione, calcolo spaziale condiviso, standardizzazione dei protocolli e simulazione distribuita, e non è ancora emerso uno standard unificato o un ecosistema interoperabile.

Middleware e infrastrutture spaziali (Middleware & Spatial Infra)

Le capacità chiave dei robot — navigazione, localizzazione, connettività e modellazione spaziale — costituiscono il ponte chiave tra il mondo fisico e la decisione intelligente. Sebbene progetti DePIN più ampi (Silencio, WeatherXM, DIMO) inizino a menzionare "robot", i seguenti progetti sono direttamente correlati all'intelligenza incarnata.

RoboStack – Cloud-Native Robot Operating Stack (https://robostack.io)

RoboStack è un middleware robotico cloud-native, che realizza la pianificazione in tempo reale dei compiti robotici, il controllo remoto e l'interoperabilità tra piattaforme attraverso RCP (Robot Context Protocol), fornendo capacità di simulazione cloud, orchestrazione dei flussi di lavoro e accesso agli agenti.

GEODNET – Rete GNSS decentralizzata (https://geodnet.com)

GEODNET è una rete GNSS decentralizzata globale, che fornisce localizzazione RTK ad alta precisione a livello di centimetro. Attraverso stazioni distribuite e incentivi on-chain, fornisce uno "strato di riferimento geografico" in tempo reale per droni, veicoli autonomi e robot.

Auki – Posemesh per il calcolo spaziale (https://www.auki.com)

Auki ha costruito una rete di calcolo spaziale decentralizzata Posemesh, generando mappe ambientali 3D in tempo reale attraverso sensori e nodi di calcolo crowdsourced, fornendo standard di spazio condiviso per AR, navigazione robotica e collaborazione tra più dispositivi. È un'infrastruttura chiave che connette lo spazio virtuale con gli scenari reali, promuovendo la fusione tra AR e robotica.

Tashi Network — Rete di collaborazione in tempo reale per robot (https://tashi.network)

Rete di griglia in tempo reale decentralizzata, realizzando un consenso sotto i 30 ms, scambio di sensori a bassa latenza e sincronizzazione dello stato tra più robot. Il suo SDK MeshNet supporta SLAM condiviso, collaborazione di gruppo e aggiornamenti di mappe robusti, fornendo un livello di collaborazione in tempo reale ad alte prestazioni per l'AI incarnata.

Staex — rete di connessione e telemetria decentralizzata (https://www.staex.io)

Proveniente dal dipartimento di ricerca di Deutsche Telekom, il livello di connessione decentralizzato fornisce comunicazioni sicure, telemetria affidabile e capacità di routing da dispositivo a cloud, consentendo a flotte di robot di scambiare dati in modo affidabile e collaborare tra diversi operatori.

Sistema di simulazione e addestramento (Distributed Simulation & Learning)

Gradient - Verso un'Intelligenza Aperta (https://gradient.network/)

Gradient è un laboratorio AI per costruire "intelligenza aperta (Open Intelligence)", dedicato alla realizzazione di addestramento distribuito, ragionamento, verifica e simulazione basati su infrastrutture decentralizzate; il suo stack tecnologico attuale include Parallax (ragionamento distribuito), Echo (apprendimento per rinforzo distribuito e addestramento multi-agente) e Gradient Cloud (soluzioni AI per le imprese). Nel settore robotico, la piattaforma Mirage offre capacità di simulazione distribuita, ambienti interattivi dinamici e apprendimento parallelo su larga scala, per accelerare il trasferimento del modello di mondo e delle strategie generali. Mirage sta esplorando potenziali collaborazioni con il suo motore Newton di NVIDIA.

Livello di rendimento degli asset robotici (RobotFi / RWAiFi)

Questo livello si concentra sulla trasformazione dei robot da "strumenti produttivi" in "asset finanziabili", costruendo l'infrastruttura finanziaria dell'economia delle macchine attraverso tokenizzazione degli asset, distribuzione dei profitti e governance decentralizzata. I progetti rappresentativi includono:

XmaquinaDAO – Physical AI DAO (https://www.xmaquina.io)

XMAQUINA è un ecosistema decentralizzato che offre agli utenti di tutto il mondo canali di partecipazione ad alta liquidità con i migliori robot umanoidi e aziende di intelligenza incarnata, portando opportunità che prima appartenevano solo a istituzioni di venture capital sulla blockchain. Il suo token DEUS è sia un asset di indice di liquidità che un veicolo di governance, utilizzato per coordinare la distribuzione del tesoro e lo sviluppo ecologico. Attraverso DAO Portal e Machine Economy Launchpad, la comunità può partecipare on-chain attraverso la tokenizzazione e strutturazione degli asset delle macchine, possedendo e supportando insieme i progetti emergenti di AI fisica.

GAIB – Il livello economico per l'infrastruttura AI (https://gaib.ai/)

GAIB si dedica a fornire un livello economico unificato per le infrastrutture AI e robotiche, connettendo capitali decentralizzati e asset di infrastruttura AI reali, costruendo un sistema economico intelligente verificabile, combinabile e produttivo.

Nel campo dei robot, GAIB non "vende token robotici", ma finanzia la messa in rete dei dispositivi robotici con contratti operativi (RaaS, raccolta dati, teleoperazione, ecc.), realizzando una transizione da "flussi di cassa reali → asset di rendimento combinabili on-chain". Questo sistema comprende finanziamenti hardware (leasing / staking), flussi di cassa operativi (RaaS / servizi di dati) e flussi di rendimento da dati (licenze / contratti), rendendo gli asset robotici e i loro flussi di cassa misurabili, valutabili e commerciabili.

GAIB utilizza AID / sAID come veicolo per la liquidazione e il rendimento, garantendo ritorni stabili attraverso meccanismi di controllo del rischio strutturati (sovra-collaterizzazione, riserve e assicurazioni), e accede a lungo termine ai mercati di derivati DeFi e di liquidità, formando un ciclo finanziario dagli "asset robotici" agli "asset di rendimento combinabili". L'obiettivo è diventare la spina dorsale economica dell'era AI (Economic Backbone of Intelligence)

Mappa ecologica dei robot Web3: https://fairy-build-97286531.figma.site/

V. Sommario e Prospettive: sfide reali e opportunità a lungo termine

Da una prospettiva a lungo termine, la fusione di robot × AI × Web3 mira a costruire un sistema economico decentralizzato delle macchine (DeRobot Economy), spingendo l'intelligenza incarnata da "automazione su singola macchina" a "collaborazione di rete verificabile, liquidabile e governabile". La logica centrale è formare un meccanismo di auto-riciclo attraverso "Token → Implementazione → Dati → Ridefinizione del valore", consentendo a robot, sensori e nodi di calcolo di ottenere diritti, scambiare e distribuire profitti.

Tuttavia, dall'attuale fase della realtà, questo modello è ancora nelle fasi iniziali di esplorazione e distante dalla formazione di flussi di cassa stabili e da un ciclo commerciale su larga scala. La maggior parte dei progetti rimane a livello narrativo, con implementazioni effettive limitate. La produzione e la manutenzione dei robot appartengono a un'industria a capitale intensivo, e la semplice incentivazione attraverso token non è sufficiente a sostenere l'espansione dell'infrastruttura; sebbene il design finanziario on-chain offra combinabilità, non ha ancora risolto la valutazione del rischio e la realizzazione dei profitti degli asset reali. Pertanto, il cosiddetto "ciclo autonomo della rete delle macchine" rimane idealistico e il suo modello commerciale deve ancora essere verificato nella realtà.

Il livello di intelligenza del modello (Model & Intelligence Layer) è l'area attualmente più promettente a lungo termine. I sistemi operativi robotici open source, rappresentati da OpenMind, tentano di rompere gli ecosistemi chiusi, unificando la collaborazione tra robot multipli e interfacce da linguaggio ad azione. La sua visione tecnologica è chiara e il sistema è completo, ma il carico di lavoro è enorme e i cicli di verifica sono lunghi, non ha ancora formato un feedback positivo a livello industriale.

Il livello dell'economia delle macchine (Machine Economy Layer) è ancora in fase preliminare, nella realtà il numero di robot è limitato, e la rete di identità DID e incentivi è difficile da formare in un ciclo coerente. Attualmente siamo lontani dall'economia della forza lavoro delle macchine. Solo dopo che l'intelligenza incarnata sarà implementata su larga scala, gli effetti economici della rete di identità on-chain, di liquidazione e di collaborazione diventeranno realmente evidenti.

Il livello di raccolta dei dati (Data Layer) ha la soglia relativamente più bassa, ma attualmente è la direzione più vicina alla fattibilità commerciale. La raccolta di dati per l'intelligenza incarnata richiede una continuità spazio-temporale e una precisione semantica delle azioni estremamente elevate, determinando la sua qualità e riutilizzabilità. Bilanciare tra "scala di crowdsourcing" e "affidabilità dei dati" è la sfida principale del settore. PrismaX fissa prima la domanda B e poi distribuisce i compiti di raccolta e verifica, offrendo in una certa misura un modello ripetibile, ma la scala ecologica e il commercio dei dati richiedono ancora tempo per accumularsi.

Il livello di percezione e simulazione (Middleware & Simulation Layer) è ancora in fase di verifica tecnologica, privo di standard unificati e interfacce, non ha ancora formato un ecosistema interoperabile. I risultati della simulazione sono difficili da trasferire standardizzati all'ambiente reale, l'efficienza Sim2Real è limitata.

Il livello di rendimento degli asset (RobotFi / RWAiFi) Web3 gioca un ruolo di supporto principalmente nella finanza della catena di approvvigionamento, noleggio di apparecchiature e governance degli investimenti, aumentando la trasparenza e l'efficienza delle liquidazioni, piuttosto che rimodellare la logica industriale.

Certamente, riteniamo che l'incrocio di robot × AI × Web3 rappresenti ancora il punto di partenza per la prossima generazione di sistemi economici intelligenti. Non è solo una fusione di paradigmi tecnici, ma anche un'opportunità per la ricostruzione delle relazioni produttive: quando le macchine acquisiscono identità, incentivi e meccanismi di governance, la collaborazione uomo-macchina si sposterà da un'automazione parziale a un'autonomia basata su rete. A breve termine, questa direzione rimane principalmente a livello di narrazione e sperimentazione, ma la struttura istituzionale e il quadro di incentivazione che gettano le basi per l'ordine economico della futura società delle macchine. Da una prospettiva a lungo termine, la combinazione di intelligenza incarnata e Web3 rimodellerà i confini della creazione di valore — rendendo gli agenti veri e propri soggetti economici verificabili, collaborabili e produttivi.

Dichiarazione di non responsabilità: Durante il processo di scrittura di questo articolo, sono stati utilizzati strumenti AI come ChatGPT-5 e Deepseek per assistenza. L'autore ha fatto del suo meglio per verificare e garantire che le informazioni siano veritiere e accurate, ma potrebbero comunque esserci delle omissioni, si prega di scusare. Si precisa in particolare che nel mercato degli asset crittografici esistono comunemente discrepanze tra la performance fondamentale dei progetti e il prezzo di mercato secondario. Il contenuto di questo articolo è solo a scopo informativo e per scambi accademici/di ricerca, non costituisce alcun consiglio di investimento e non dovrebbe essere considerato una raccomandazione per acquistare o vendere alcun token.