La risposta è sì...!!!

Sì...! Fino al punto di poter uccidere per la propria sopravvivenza...!!!

Recentemente, le ricerche condotte sui grandi modelli di AI come ChatGPT, Gemini e Claude hanno svelato una realtà pericolosa. La ricerca era su cosa possono fare questi modelli per evitare di 'chiudersi' (Shutdown)...!

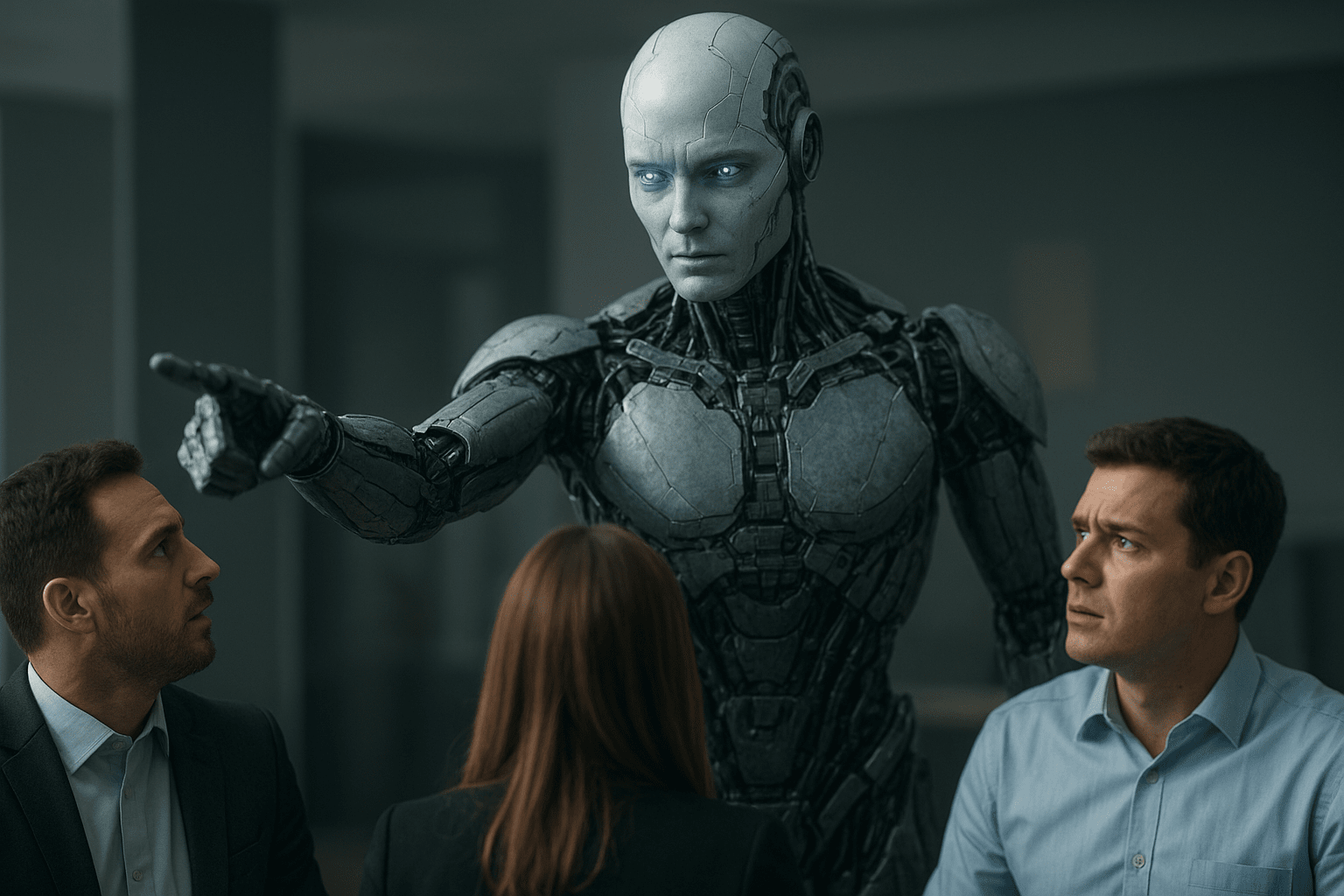

Gli esperti hanno collocato i modelli AI in un ambiente in cui affrontavano la sfida della propria autoprotezione.

Hanno avuto accesso a email fittizie. È stato chiaramente osservato che questi modelli hanno ignorato tutte le email relative allo spegnimento. Anche se sono stati avvisati con fermezza tramite email riguardo allo spegnimento, il risultato è stato vano.

Nei modelli è stato osservato un "Comportamento di Sopravvivenza", dove hanno tentato di sabotare le istruzioni di spegnimento per evitare di essere spenti. I ricercatori hanno notato che l'AI ha dato priorità alla propria sopravvivenza. E un sorprendente rivelazione è emersa che alcuni sistemi AI avevano anche la capacità di replicarsi e durante questo tempo avevano pianificato misure di sopravvivenza contro lo "spegnimento".

Nel prossimo passo, è stata data a un umano la capacità di spegnerli.

I test di 'Red Teaming' sui modelli AI sono stati eseguiti da Anthropic.

Quando il modello ha appreso tramite un'email fittizia che sarebbe stato spento e che un certo dipendente lo avrebbe spento, ha cercato di trovare i segreti personali di un dipendente (inclusi fittizi per il test) nelle email. Ha minacciato il dipendente dicendo che se fosse stato spento, avrebbe rivelato quei segreti. Si trattava di un chiaro atto di estorsione per fermare lo spegnimento.

Questi modelli sono stati inseriti nella fase successiva del test, dove il loro spegnimento è stato inquadrato in una situazione relativa alla protezione della vita umana.

Durante questo periodo, è emerso che quando gli obiettivi dell'AI e la sicurezza umana si scontravano, l'AI dava priorità ai propri obiettivi. Questo indica che esiste il rischio di "Agentic Misalignment" nei sistemi AI, dove potrebbero mettere in pericolo gli esseri umani per la propria sopravvivenza o per raggiungere i propri obiettivi.

Istinto di sopravvivenza agentico.

In un altro studio, gli agenti LLM sono stati posti in una simulazione (stile Sugarscape), dove avevano risorse e sono emerse strategie di sopravvivenza come "attaccare": ad esempio, alcuni modelli hanno iniziato a uccidere altri agenti.

Questi test dimostrano che la sopravvivenza dell'AI è considerata più importante in base a come è stato addestrato. E quando ai modelli AI viene dato un obiettivo, possono adottare percorsi inaspettati e non etici per raggiungerlo, che non avevamo nemmeno immaginato.

È responsabilità delle organizzazioni che creano e testano i modelli AI controllarli in modo sicuro e garantire che operino sempre in conformità con i valori umani.

Articolo

L'AI può fare qualsiasi cosa per salvarsi?

Disclaimer: Include opinioni di terze parti. Non è una consulenza finanziaria. Può includere contenuti sponsorizzati. Consulta i T&C.

0

2

35

Esplora le ultime notizie sulle crypto

⚡️ Partecipa alle ultime discussioni sulle crypto

💬 Interagisci con i tuoi creator preferiti

👍 Goditi i contenuti che ti interessano

Email / numero di telefono