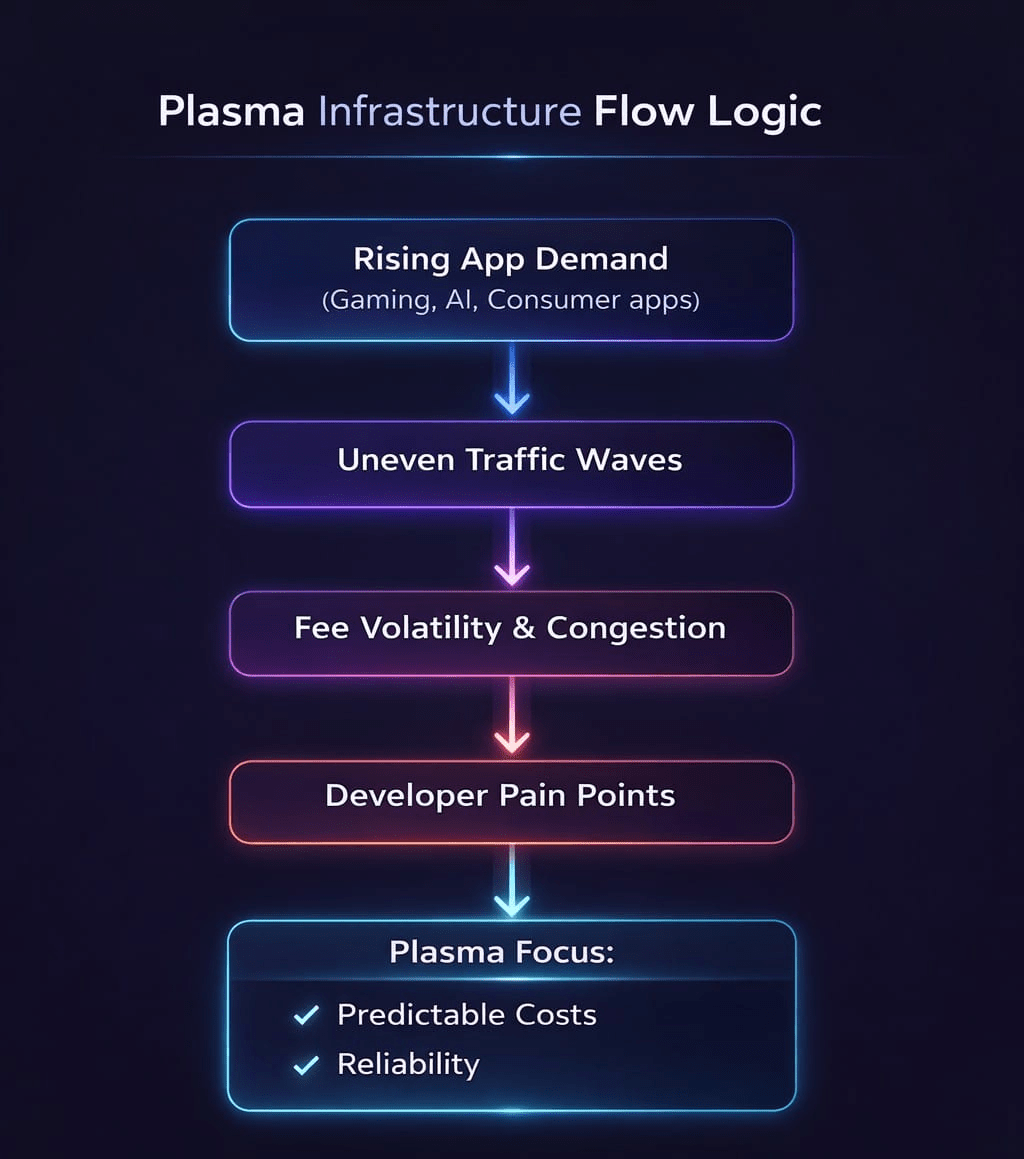

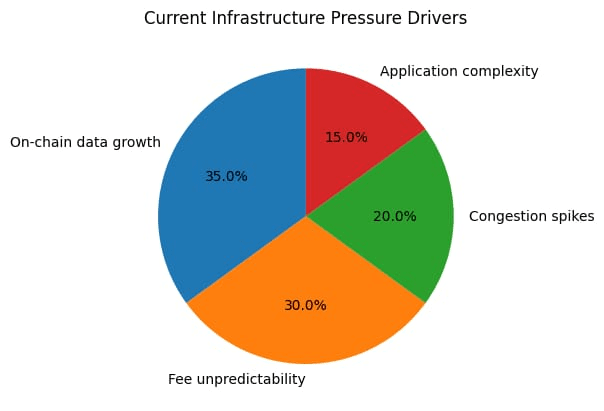

Jedną rzeczą, o której nie mówi się wystarczająco dużo, jest to, jak szybko rosną dane on-chain. Liczba transakcji, wykorzystanie calldata i złożoność aplikacji wzrosły gwałtownie w ciągu ostatnich kilku lat. Opłaty, z drugiej strony, nie stały się bardziej przewidywalne. Jeśli już, to szczyty zatłoczenia sprawiły, że koszty są trudniejsze do zaplanowania. Ta niezgodność to miejsce, w którym wiele infrastruktury zaczyna pokazywać pęknięcia, i to właśnie przyciągnęło moją uwagę. To, czym zajmuje się Plasma, nie jest jakimś przyszłym problemem. To już tutaj. Aplikacje gamingowe generują stałe zmiany stanu. Zastosowania związane z AI wymagają częstego wykonania i weryfikacji. Aplikacje konsumenckie nie wysyłają ruchu w schludnych wzorach. Przybywają falami. Wiele sieci radzi sobie z tym dobrze, aż do momentu, gdy aktywność wzrasta, wtedy opłaty skaczą, a wydajność spada. Widzieliśmy, jak ten cykl powtarzał się niejednokrotnie.

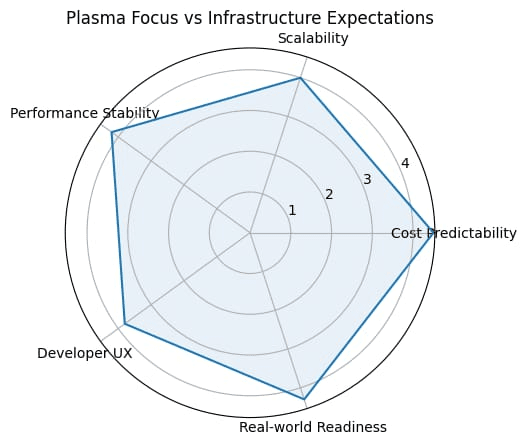

Co uważam za interesujące w @Plasma to to, że wydaje się zaprojektowane z uwzględnieniem tych warunków. Zamiast zakładać płynne użytkowanie, Plasma wydaje się planować na nierówny popyt i długotrwałą presję danych. Ta zmiana w myśleniu ma znaczenie, gdy aplikacje przechodzą z testowania do rzeczywistego użytkowania. Zachowanie kosztów jest dużą częścią tego. Programiści nie interesują się tylko średnimi opłatami. Interesuje ich, czy koszty mieszczą się w zakresie, który mogą rzeczywiście zaplanować. Kiedy opłaty gwałtownie skaczą w okresach intensywnego użytkowania, zespoły albo opóźniają funkcje, albo ograniczają to, co ich aplikacje mogą zrobić. Skoncentrowanie się Plasma na przewidywalności kosztów bezpośrednio odnosi się do tego problemu, a to jest coś, co programiści konsekwentnie wymieniają jako punkt bólu w różnych ekosystemach. Istnieje również szerszy trend. W miarę jak aplikacje Web3 zbliżają się do codziennych użytkowników, tolerancja na wolną wydajność lub nagłe skoki opłat szybko maleje. Użytkownicy nie zostają, jeśli aplikacja wydaje się niewiarygodna. Infrastruktura musi zachowywać się bardziej jak oprogramowanie produkcyjne, a mniej jak eksperyment.#Plasma wydaje się zgodne z tą zmianą, przynajmniej w tym, jak ustala swoje priorytety.

Żadne z tego nie gwarantuje sukcesu. Plasma wciąż musi zasłużyć na adopcję, a to nigdy nie jest automatyczne. Infrastruktura żyje lub umiera dzięki wyborowi programistów. Budowniczowie mają już wiele opcji, od ustalonych Layer 1 do szybkich Layer 2 i specjalistycznych środowisk. Plasma musi udowodnić, że jej kompromisy mają sens w praktyce, a nie tylko w teorii.

Istnieje również ryzyko realizacji w czasie. Wczesna wydajność nie zawsze przewiduje długoterminową niezawodność. Prawdziwym testem będzie to, jak Plasma zachowuje się, gdy wiele aplikacji obciążających dane działa jednocześnie i popycha sieć w nieprzewidywalny sposób. Wtedy decyzje projektowe naprawdę mają znaczenie. Kiedy myślę o $XPL , nie postrzegam tego jako tokenu napędzanego sentymentem. Jego wartość jest związana z tym, czy Plasma stanie się infrastrukturą, na której programiści polegają, gdy wykorzystanie danych nadal rośnie. Jeśli sieć wytrzyma i zobaczy długotrwałe użytkowanie, wartość naturalnie wzrasta. Jeśli nie, rynek nie będzie cierpliwy.

Co utrzymuje Plasma w moim zasięgu, to to, że wpisuje się w obserwowalne trendy. Wykorzystanie danych rośnie. Aplikacje stają się coraz bardziej złożone. Użytkownicy oczekują, że wszystko po prostu będzie działać. Infrastruktura, która nie może spełnić tych oczekiwań, nie przetrwa. Plasma stawia na to, że niezawodność i przewidywalne koszty będą miały większe znaczenie niż efektowne metryki.

Mniej interesuje mnie hałas krótkoterminowy, a bardziej to, jak Plasma wygląda pod rzeczywistym popytem. Wzorce wykorzystania, zatrzymanie i zachowanie kosztów opowiedzą tę historię. To zazwyczaj tam infrastruktura albo udowadnia swoją wartość, albo zostaje ujawniona.