Așa cum a spus odată maestrul Leonardo da Vinci, "Învățarea nu epuizează mintea." Dar în era inteligenței artificiale, se pare că învățarea ar putea epuiza pur și simplu resursele de putere computațională ale planetei noastre. Revoluția AI, care este pe cale să investească peste 15,7 trilioane de dolari în economia globală până în 2030, se bazează fundamental pe două lucruri: date și forța pură a calculului. Problema este că scala modelelor AI crește cu o viteză amețitoare, cu puterea de calcul necesară pentru antrenament dublându-se aproximativ la fiecare cinci luni. Aceasta a creat un blocaj masiv. Un mic număr de mari companii cloud dețin cheile regatului, controlând oferta de GPU și creând un sistem care este costisitor, cu permisiuni și, sincer, puțin fragil pentru ceva atât de important.

Aici devine interesant. Observăm o schimbare de paradigmă, o arenă emergentă numită antrenament de model AI descentralizat (DeAI), care folosește ideile de bază ale blockchain-ului și Web3 pentru a contesta acest control centralizat.

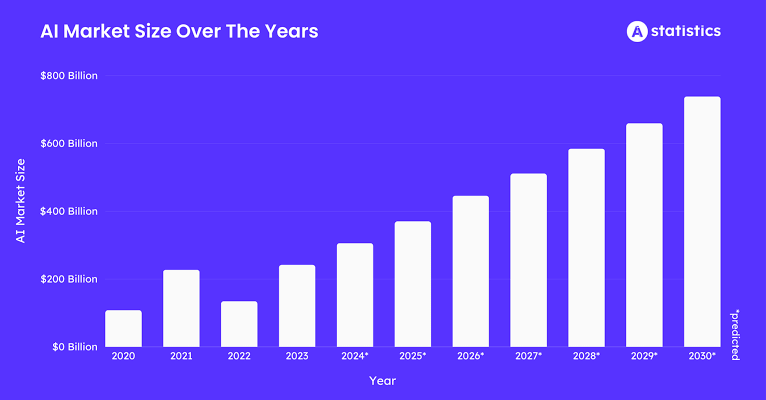

Să ne uităm la cifre. Piața pentru datele de antrenament AI este pe cale să atingă aproximativ 3,5 miliarde de dolari până în 2025, crescând cu o viteză de aproximativ 25% în fiecare an. Toate acele date necesită procesare. Piața AI Blockchain este de așteptat să valoreze aproape 681 milioane de dolari în 2025, crescând cu o rată sănătoasă de 23% până la 28% CAGR. Și dacă ne uităm la imaginea de ansamblu, întreaga infrastructură fizică descentralizată (DePIN), de care face parte DeAI, este proiectată să depășească 32 miliarde de dolari în 2025.

Ce înseamnă toate acestea este că foamea AI pentru date și calcul creează o cerere uriașă. DePIN și blockchain-ul intervin pentru a oferi oferta, o rețea globală, deschisă și economic inteligentă pentru construirea inteligenței. Am văzut deja cum stimulentele cu tokeni pot determina oamenii să coordoneze hardware fizic, cum ar fi hotspot-uri wireless și unități de stocare; acum aplicăm același plan la cel mai valoros proces de producție digital din lume: crearea inteligenței artificiale.

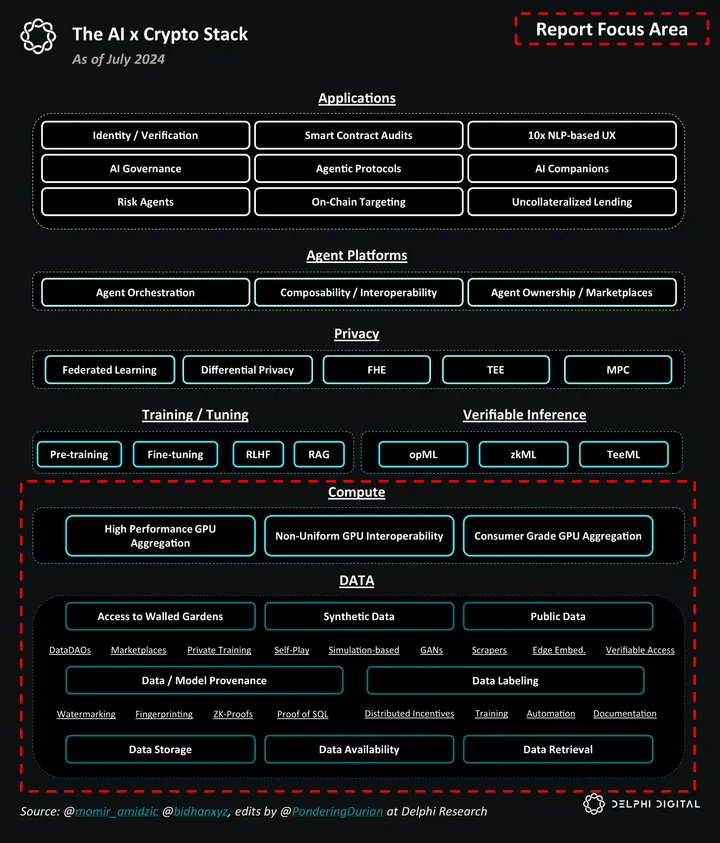

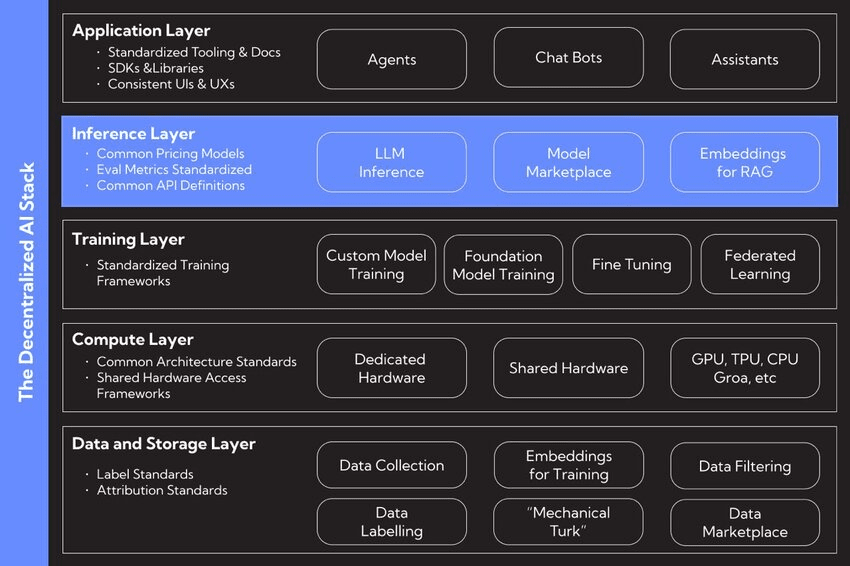

I. Stiva DeAI

Împingerea pentru AI descentralizată provine dintr-o misiune filosofică profundă de a construi un ecosistem AI mai deschis, mai rezistent și mai echitabil. Este vorba despre stimularea inovației și rezistența la concentrarea puterii pe care o vedem astăzi. Susținătorii contrastează adesea două moduri de organizare a lumii: un "Taxis", care este un ordin centralizat, proiectat și controlat, față de un "Cosmos", un ordin descentralizat, emergent, care crește din interacțiuni autonome.

O abordare centralizată a AI ar putea crea un fel de "autocompletare pentru viață", unde sistemele AI împing subtil acțiunile umane și, alegere cu alegere, ne subțiază capacitatea de a gândi pentru noi înșine. Descentralizarea este antidotul propus. Este un cadru în care AI este un instrument pentru a îmbunătăți înflorirea umană, nu pentru a o direcționa. Prin dispersarea controlului asupra datelor, modelelor și calculului, DeAI își propune să pună puterea înapoi în mâinile utilizatorilor, creatorilor și comunităților, asigurându-se că viitorul inteligenței este ceva ce împărtășim, nu ceva ce câteva companii dețin.

II. Deconstructia Stivei DeAI

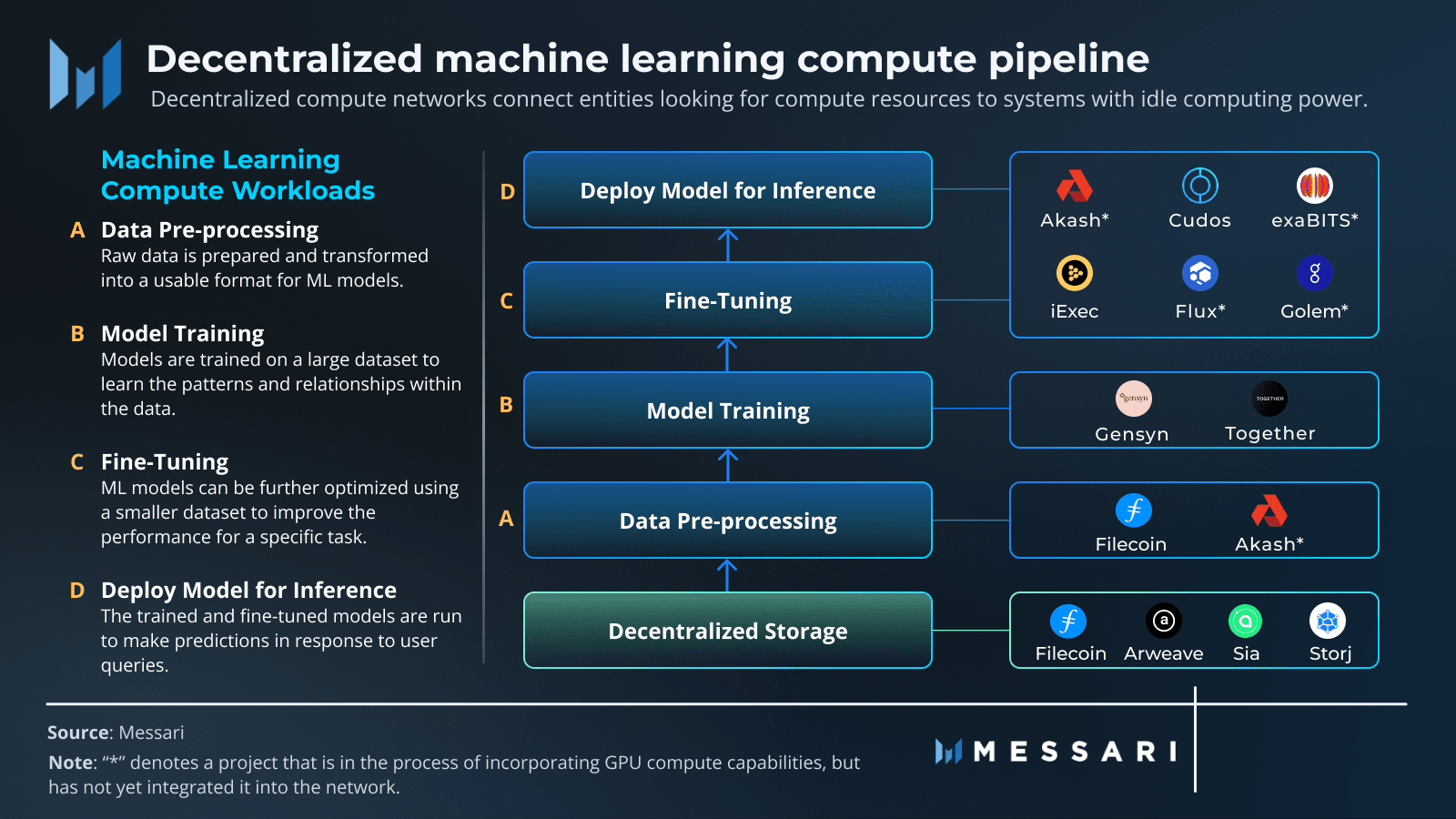

În esență, poți descompune AI în trei piese de bază: date, calcul și algoritmi. Mișcarea DeAI se concentrează pe reconstruirea fiecărui dintre acești piloni pe o fundație descentralizată.

❍ Pilonul 1: Date descentralizate

Combustibilul pentru orice AI puternic este un set de date masiv și variat. În vechiul model, aceste date sunt blocate în sisteme centralizate precum Amazon Web Services sau Google Cloud. Acest lucru creează puncte unice de eșec, riscuri de cenzură și face dificil pentru nou-veniți să obțină acces. Rețelele de stocare descentralizate oferă o alternativă, oferind o casă permanentă, rezistentă la cenzură și verificabilă pentru datele de antrenament AI.

Proiecte precum Filecoin și Arweave sunt jucători cheie aici. Filecoin folosește o rețea globală de furnizori de stocare, stimulându-i cu tokeni pentru a stoca date în mod fiabil. Folosește dovezi criptografice ingenioase precum Dovezi de Replicare și Dovezi de Spațiu- și Timp pentru a se asigura că datele sunt sigure și disponibile. Arweave are o abordare diferită: plătești o dată și datele tale sunt stocate pentru totdeauna pe un "permaweb" imuabil. Transformând datele într-un bun public, aceste rețele creează o fundație solidă și transparentă pentru dezvoltarea AI, asigurând că seturile de date utilizate pentru antrenament sunt securizate și deschise pentru toată lumea.

❍ Pilonul 2: Calcul descentralizat

Cel mai mare obstacol în AI în acest moment este obținerea accesului la calcul de înaltă performanță, în special GPU-uri. DeAI abordează acest lucru direct prin crearea de protocoale care pot aduna și coordona puterea de calcul din întreaga lume, de la GPU-uri de consum din casele oamenilor până la mașini idle în centre de date. Acest lucru transformă puterea computațională dintr-o resursă rară pe care o închiriezi de la câțiva gardieni într-un bun lichid și global. Proiecte precum Prime Intellect, Gensyn și Nous Research construiesc piețele pentru această nouă economie a calculului.

❍ Pilonul 3: Algoritmi și modele descentralizate

Obținerea datelor și a calculului este un lucru. Lucrul real constă în coordonarea procesului de antrenament, asigurându-se că munca este efectuată corect și obținând colaborarea tuturor într-un mediu în care nu poți să ai încredere în oricine. Aici se adună o combinație de tehnologii Web3 pentru a forma nucleul operațional al DeAI.

Blockchain și contracte inteligente: Gândiți-vă la acestea ca la un manual de reguli imuabil și transparent. Blockchain-urile oferă un registru comun pentru a urmări cine a făcut ce, iar contractele inteligente aplică automat regulile și distribuie recompensele, așa că nu aveți nevoie de un intermediar.

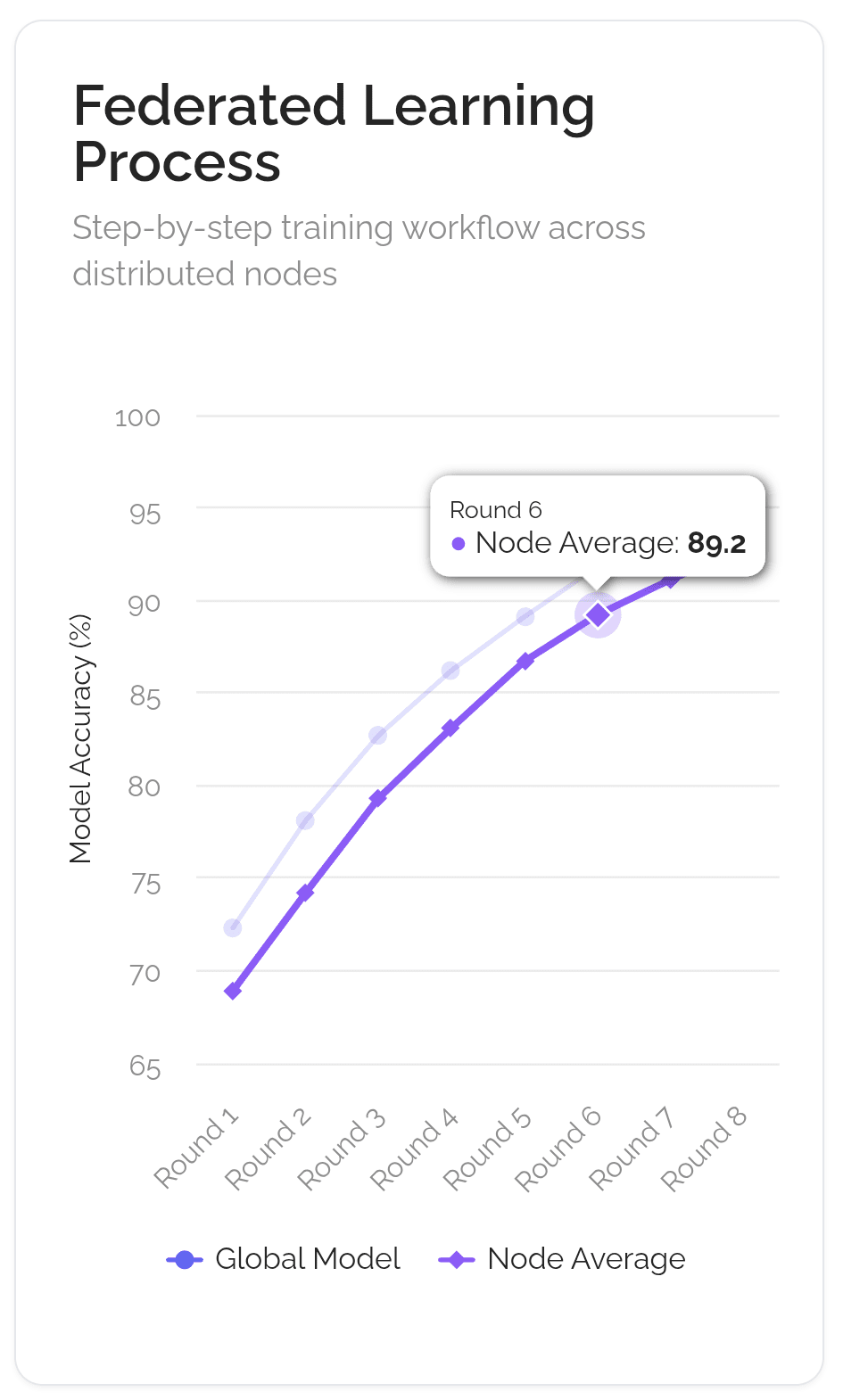

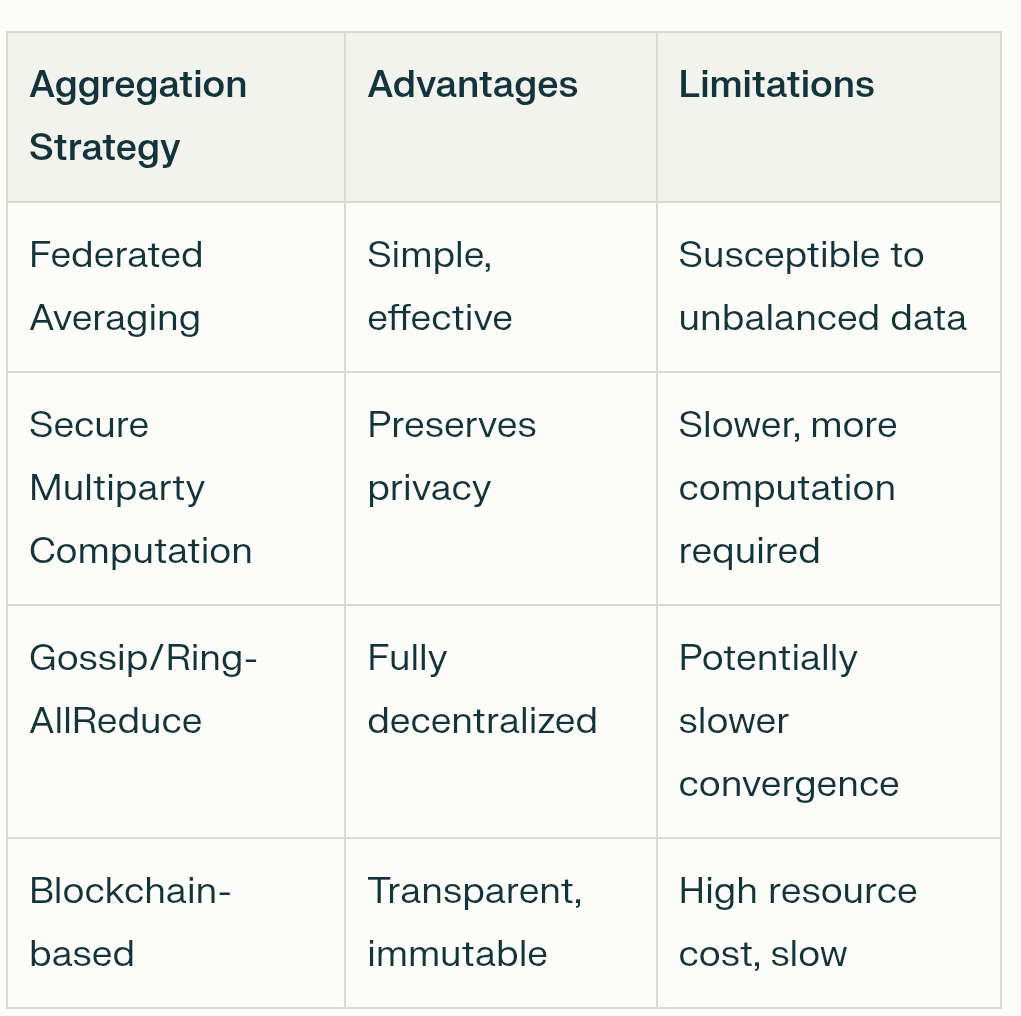

Învățare Federată: Aceasta este o tehnică cheie pentru păstrarea confidențialității. Permite modelelor AI să se antreneze pe date dispersate în diferite locații fără ca datele să fie vreodată mutate. Numai actualizările modelului sunt partajate, nu informațiile dvs. personale, ceea ce păstrează datele utilizatorului private și securizate.

Tokenomics: Aceasta este motorul economic. Tokenii creează o mini-economie care recompensează oamenii pentru contribuții valoroase, fie că este vorba de date, putere de calcul sau îmbunătățiri ale modelelor AI. Aceasta aliniază stimulentele tuturor către obiectivul comun de a construi o AI mai bună.

Frumusețea acestui stiv este modularitatea sa. Un dezvoltator AI ar putea lua un set de date de la Arweave, folosi rețeaua Gensyn pentru antrenament verificabil și apoi implementa modelul finalizat pe un subnet specializat Bittensor pentru a face bani. Această interoperabilitate transformă piesele dezvoltării AI în "lego-uri de inteligență", stârnind un ecosistem mult mai dinamic și inovator decât orice platformă închisă ar putea vreodată.

III. Cum Funcționează Antrenamentul Modelului Descentralizat

Imaginează-ți că obiectivul este de a crea un bucătar AI de clasă mondială. Vechea modalitate, centralizată, este de a închide un ucenic într-o singură bucătărie secretă (ca cea a Google) cu un uriaș, secret, carte de rețete. Modalitatea descentralizată, folosind o tehnică numită Învățare Federată, este mai mult ca un club global de gătit.

Rețeta principală ("modelul global") este trimisă la mii de bucătari locali din întreaga lume. Fiecare bucătar încearcă rețeta în propria sa bucătărie, folosind ingredientele și metodele lor unice locale ("date locale"). Ei nu împărtășesc ingredientele lor secrete; ei doar fac note despre cum să îmbunătățească rețeta ("actualizări ale modelului"). Aceste note sunt trimise înapoi la sediul clubului. Clubul apoi combină toate notele pentru a crea o nouă rețetă principală îmbunătățită, care este trimisă pentru următoarea rundă. Întreaga activitate este gestionată de o cartă a clubului transparentă și automată ("blockchain"), care se asigură că fiecare bucătar care ajută primește credit și este recompensat corect ("recompense cu token").

❍ Mecanisme cheie

Această analogie se potrivește destul de bine cu fluxul de lucru tehnic care permite acest tip de antrenament colaborativ. Este un lucru complex, dar se reduce la câteva mecanisme cheie care fac totul posibil.

Paralelism Distribuit al Datelor: Acesta este punctul de plecare. În loc ca un computer uriaș să proceseze un set de date masiv, setul de date este împărțit în bucăți mai mici și distribuit pe multe computere diferite (noduri) din rețea. Fiecare dintre aceste noduri primește o copie completă a modelului AI cu care să lucreze. Acest lucru permite o cantitate uriașă de procesare paralelă, accelerând dramatic lucrurile. Fiecare nod își antrenează replica modelului pe felia sa unică de date.

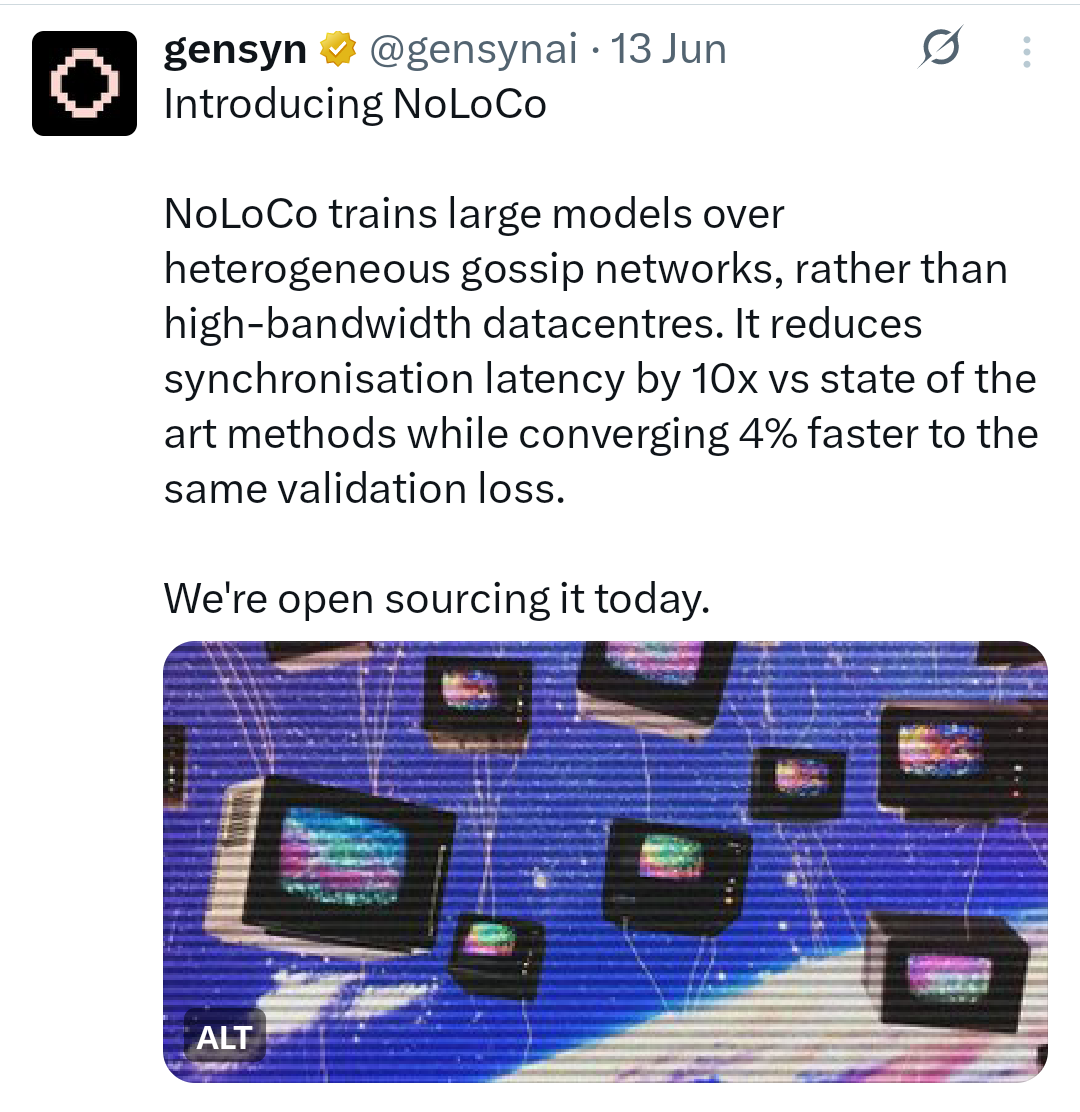

Algoritmi cu Comunicare Redusă: O provocare majoră este menținerea tuturor acelor replici de model în sincronizare fără a bloca internetul. Dacă fiecare nod ar trebui să transmită constant fiecare actualizare mică tuturor celorlalte noduri, ar fi incredibil de lent și ineficient. Aici intervin algoritmii cu comunicare redusă. Tehnici precum DiLoCo (Comunicație Distribuită cu Comunicare Redusă) permit nodurilor să efectueze sute de pași de antrenament local pe cont propriu înainte de a necesita sincronizarea progresului lor cu rețeaua mai largă. Metodele mai noi, cum ar fi NoLoCo (Fără-reducere Comunicație Redusă), merg și mai departe, înlocuind sincronizările masive de grup cu o metodă de "bârfa" în care nodurile își mediează periodic actualizările cu un singur coleg ales aleatoriu.

Compresie: Pentru a reduce și mai mult povara comunicației, rețelele folosesc tehnici de compresie. Acesta este ca și cum ai comprima un fișier înainte de a-l trimite prin email. Actualizările modelului, care sunt doar liste mari de numere, pot fi comprimate pentru a le face mai mici și mai rapide de trimis. Quantizarea, de exemplu, reduce precizia acestor numere (să zicem, de la un float de 32 de biți la un integer de 8 biți), ceea ce poate reduce dimensiunea datelor cu un factor de patru sau mai mult, cu un impact minim asupra acurateței. Îndepărtarea este o altă metodă care elimină conexiunile neimportante din cadrul modelului, făcându-l mai mic și mai eficient.

Stimulente și Validare: Într-o rețea fără încredere, trebuie să te asiguri că toată lumea joacă corect și este recompensată pentru munca lor. Aceasta este sarcina blockchain-ului și a economiei sale de tokeni. Contractele inteligente acționează ca un escrow automatizat, reținând și distribuind recompensele cu tokeni participanților care contribuie cu calcul sau date utile. Pentru a preveni înșelăciunea, rețelele folosesc mecanisme de validare. Acest lucru poate implica validatorii care reexecută aleatoriu o mică parte a calculului unui nod pentru a verifica corectitudinea acestuia sau folosind dovezi criptografice pentru a asigura integritatea rezultatelor. Acest lucru creează un sistem de "Dovadă a Inteligenței" în care contribuțiile valoroase sunt verificate și recompensate.

Toleranță la Erori: Rețelele descentralizate sunt formate din computere nesigure, distribuite global. Nodurile pot cădea offline în orice moment. Sistemul trebuie să fie capabil să gestioneze acest lucru fără ca întregul proces de antrenament să se prăbușească. Aici intervine toleranța la erori. Cadre precum ElasticDeviceMesh al Prime Intellect permit nodurilor să se alăture sau să părăsească dinamic o rundă de antrenament fără a provoca o eșec global al sistemului. Tehnici precum punctarea asincronă salvează regulat progresul modelului, astfel încât dacă un nod eșuează, rețeaua poate recupera rapid de la ultima stare salvată în loc să înceapă de la zero.

Acest flux de lucru continuu și iterativ schimbă fundamental ceea ce este un model AI. Nu mai este un obiect static creat și deținut de o singură companie. Devine un sistem viu, o stare de consens care este constant rafinată de un colectiv global. Modelul nu este un produs; este un protocol, întreținut și securizat colectiv de rețeaua sa.

IV. Protocoale de Antrenament Descentralizate

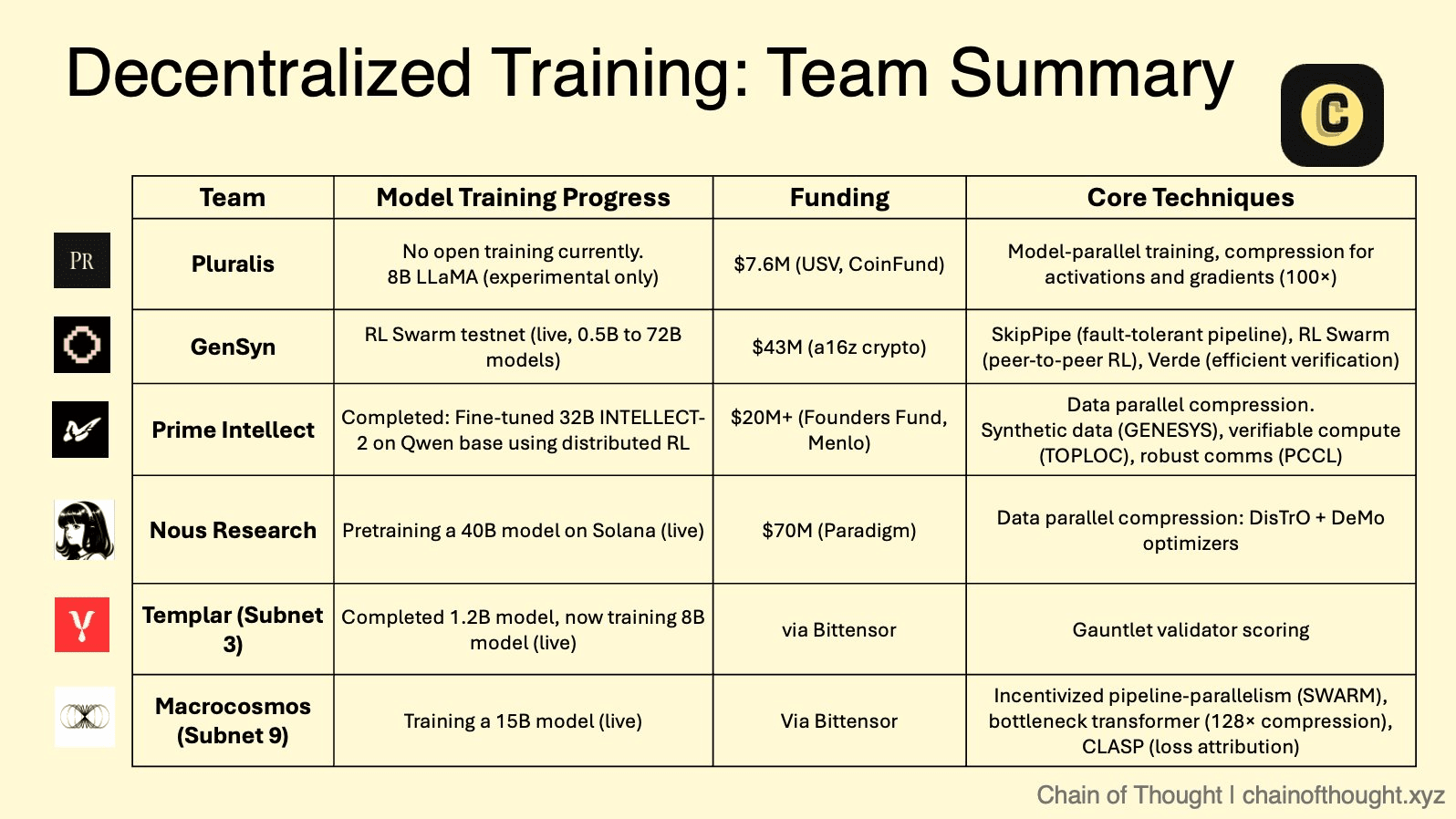

Cadrele teoretice ale AI descentralizate sunt acum implementate de un număr tot mai mare de proiecte inovatoare, fiecare cu o strategie și o abordare tehnică unică. Aceste protocoale creează o arenă competitivă unde diferite modele de colaborare, verificare și stimulare sunt testate la scară.

❍ Piața Modulară: Ecosistemul Subnetelor Bittensor

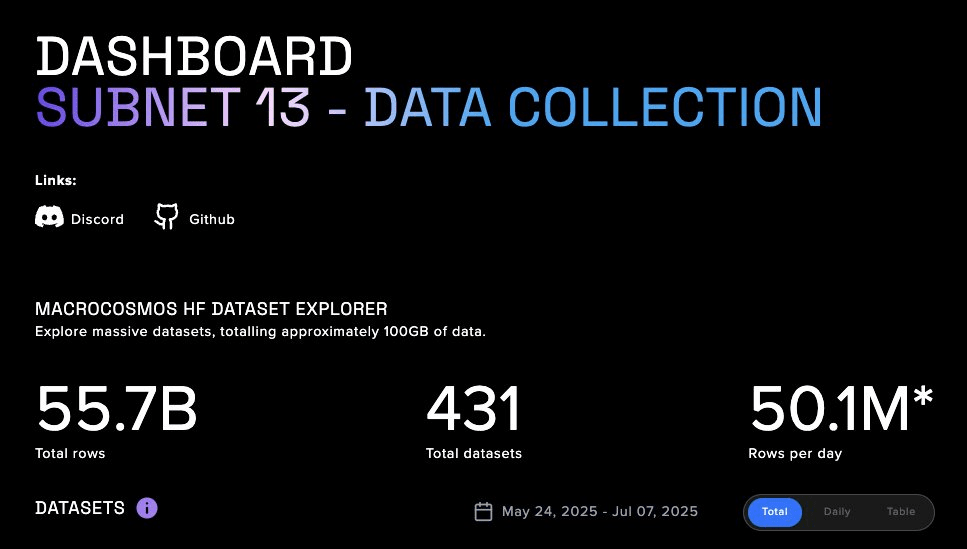

Bittensor funcționează ca un "internet al bunurilor digitale", un meta-protocol care găzduiește numeroase "subnete" specializate. Fiecare subnet este o piață competitivă, bazată pe stimulente, pentru o sarcină specifică AI, de la generarea de text până la plierea proteinelor. În cadrul acestui ecosistem, două subnete sunt deosebit de relevante pentru antrenamentul descentralizat.

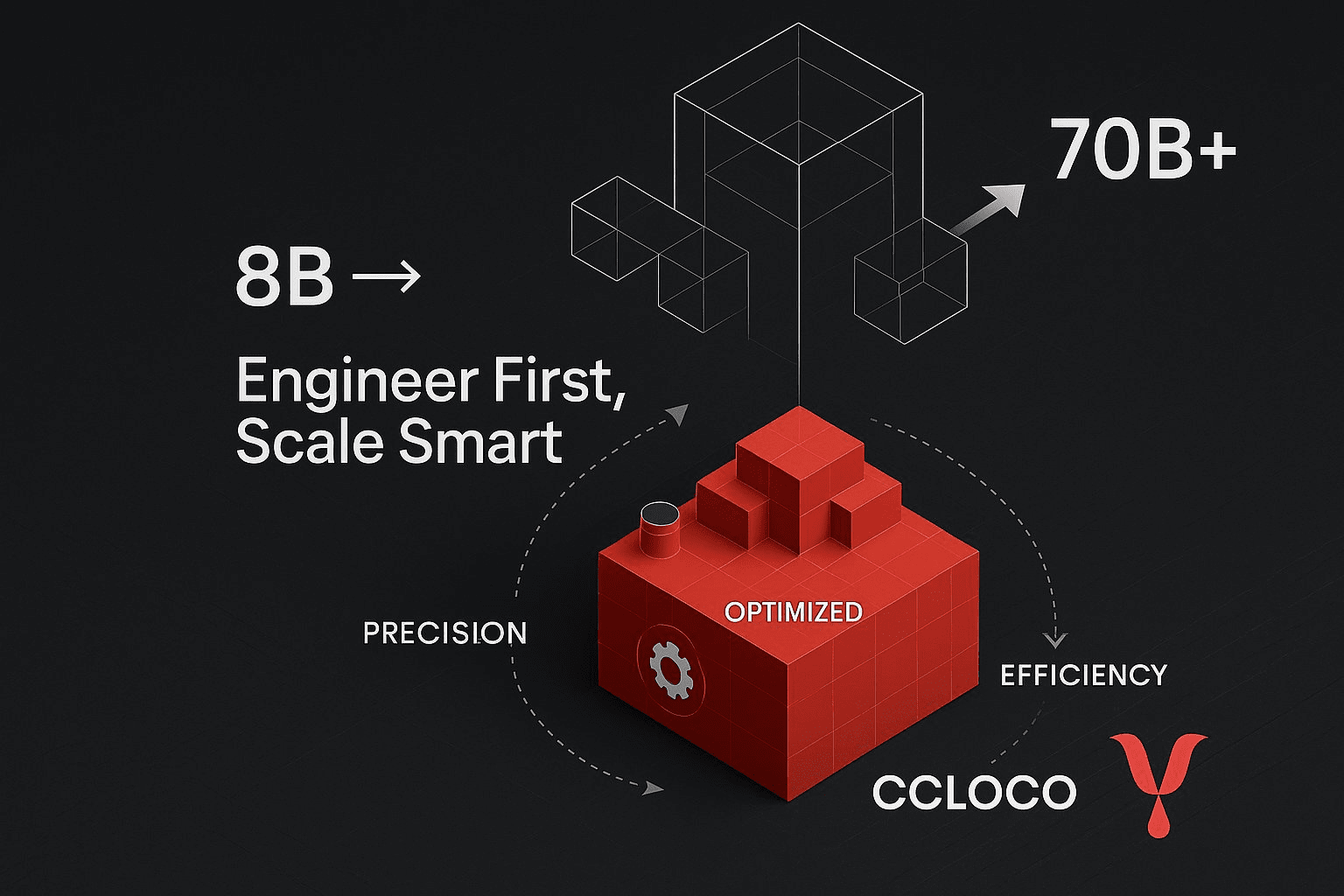

Templar (Subnet 3) se concentrează pe crearea unei platforme fără permisiuni și antifragile pentru pre-antrenament descentralizat. Încorporează o abordare pură și competitivă în care minerii antrenează modele (în prezent până la 8 miliarde de parametri, cu un plan de acțiune către 70 miliarde) și sunt recompensați în funcție de performanță, conducând o cursă neîncetată pentru a produce cea mai bună inteligență posibilă.

Macrocosmos (Subnet 9) reprezintă o evoluție semnificativă cu arhitectura sa de Antrenament Orchestrat Stimulant IOTA. IOTA depășește competiția izolată spre colaborarea orchestrată. Folosește o arhitectură hub-and-spoke unde un Orchestrator coordonează antrenamentul de date și pipeline-paralel într-o rețea de mineri. În loc ca fiecare miner să antreneze un model întreg, li se alocă straturi specifice ale unui model mult mai mare. Această diviziune a muncii permite colectivului să antreneze modele la o scară mult mai mare decât capacitatea oricărui participant individual. Validatorii efectuează "auditorii umbrite" pentru a verifica lucrările, iar un sistem de stimulente granular recompensează contribuțiile în mod corect, promovând un mediu colaborativ, dar responsabil.

❍ Strat de Calcul Verificabil: Rețeaua Fără Încredere a Gensyn

Focusul principal al Gensyn este de a rezolva una dintre cele mai dificile probleme din acest domeniu: învățarea automată verificabilă. Protocolul său, construit ca un L2 Rollup personalizat Ethereum, este conceput pentru a oferi dovadă criptografică a corectitudinii pentru calculele de învățare profundă efectuate pe noduri nesigure.

O inovație cheie din cercetarea Gensyn este NoLoCo (Fără-reducere Comunicație Redusă), o metodă de optimizare nouă pentru antrenamentul distribuit. Metodele tradiționale necesită un pas global de sincronizare "all-reduce", care creează un blocaj, în special pe rețele cu lățime de bandă redusă. NoLoCo elimină complet acest pas. În schimb, folosește un protocol bazat pe bârfa în care nodurile își mediează periodic greutățile modelului cu un singur coleg ales aleatoriu. Aceasta, combinată cu un optimizator de momentum Nesterov modificat și rutare aleatorie a activărilor, permite rețelei să conveargă eficient fără sincronizare globală, făcând-o ideală pentru antrenamentul pe hardware heterogen conectat la internet. Aplicația testnet RL Swarm a Gensyn demonstrează această stivă în acțiune, permițând învățarea prin întărire colaborativă într-un cadru descentralizat.

❍ Agregatorul Global de Calcul: Cadrele Deschise ale Prime Intellect

Prime Intellect construiește un protocol peer-to-peer pentru a agrega resursele globale de calcul într-o piață unificată, creând efectiv un "Airbnb pentru calcul". Cadrele lor PRIME sunt concepute pentru antrenament rezistent la erori și de înaltă performanță pe o rețea de lucrători nesiguri și distribuiți global.

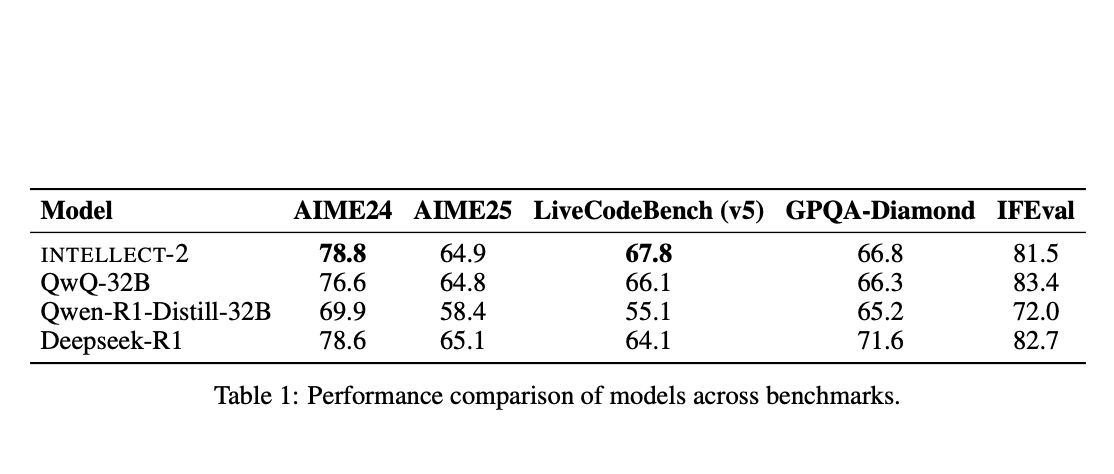

Cadrele sunt construite pe o versiune adaptată a algoritmului DiLoCo (Antrenament Distribuit cu Comunicare Redusă), care permite nodurilor să efectueze multe etape de antrenament local înainte de a necesita o sincronizare globală mai puțin frecventă. Prime Intellect a augmentat acest lucru cu descoperiri ingineresti semnificative. ElasticDeviceMesh permite nodurilor să se alăture sau să părăsească dinamic o rundă de antrenament fără a crăpa sistemul. Punctarea asincronă pe sisteme de fișiere susținute de RAM minimizează timpul de nefuncționare. În cele din urmă, au dezvoltat nuclee personalizate int8 all-reduce, care reduc sarcina de comunicare în timpul sincronizării cu un factor de patru, reducând drastic cerințele de lățime de bandă. Această stivă tehnică robustă le-a permis să orchestreze cu succes primul antrenament descentralizat din lume al unui model cu 10 miliarde de parametri, INTELLECT-1.

❍ Colectivul Open-Source: Abordarea Comunității Nous Research

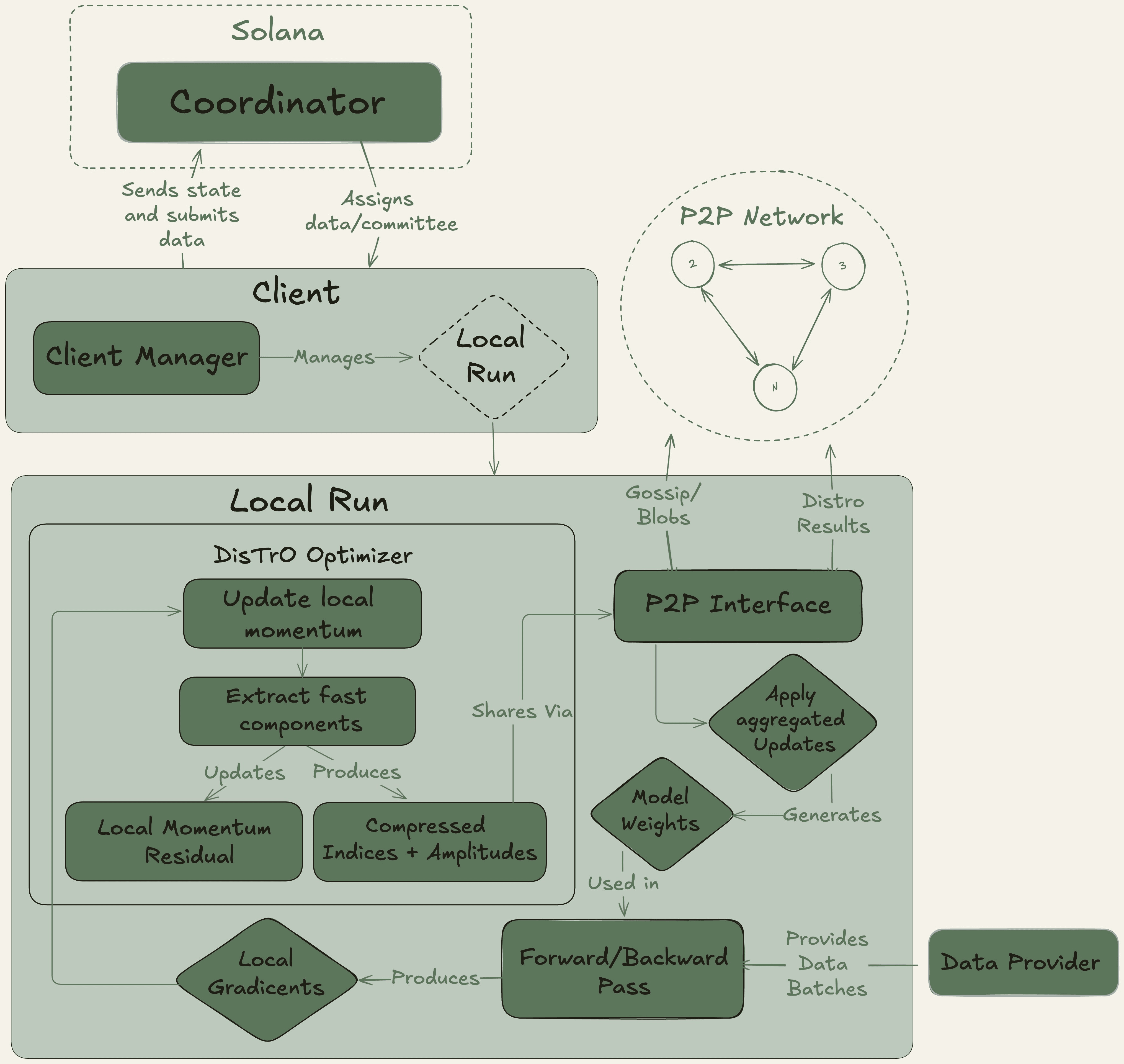

Nous Research funcționează ca un colectiv de cercetare AI descentralizat cu un puternic ethos open-source, construind infrastructura sa pe blockchain-ul Solana pentru throughput-ul său ridicat și costurile reduse de tranzacție.

Platforma lor emblematică, Nous Psyche, este o rețea de antrenament descentralizată, alimentată de două tehnologii de bază: DisTrO (Antrenament Distribuit pe Internet) și algoritmul său de optimizare subiacente, DeMo (Optimizare a Momentum-ului Decuplată). Dezvoltate în colaborare cu un co-fondator OpenAI, aceste tehnologii sunt concepute pentru eficiență extremă a lățimii de bandă, revendicând o reducere de 1.000x până la 10.000x comparativ cu metodele convenționale. Această descoperire face posibilă participarea la antrenamentul modelelor la scară largă folosind GPU-uri de consum și conexiuni standard la internet, democratizând radical accesul la dezvoltarea AI.

❍ Viitorul Pluralistic: Învățarea Protocolară Pluralis AI

Pluralis AI abordează o provocare de nivel superior: nu doar cum să antreneze modele, ci cum să le alinieze cu valori umane diverse și pluraliste într-un mod care păstrează confidențialitatea.

Cadrele lor PluralLLM introduc o abordare bazată pe învățarea federată pentru alinierea preferințelor, o sarcină tradițional gestionată de metode centralizate precum Învățarea prin Întărire din Feedback Uman (RLHF). Cu PluralLLM, diferite grupuri de utilizatori pot antrena colaborativ un model de predictor de preferințe fără a împărtăși vreodată datele lor sensibile, subiacente. Cadrele folosesc Averajul Federat pentru a agrega aceste actualizări de preferință, realizând o convergență mai rapidă și scoruri de aliniere mai bune decât metodele centralizate, păstrând în același timp confidențialitatea și corectitudinea.

Conceptul lor general de Învățare Protocolară asigură în continuare că niciun participant individual nu poate obține modelul complet, soluționând problemele critice de proprietate intelectuală și încredere inerente dezvoltării colaborative a AI.

Deși arena antrenamentului AI descentralizat deține un viitor promițător, drumul său spre adoptarea pe scară largă este plin de provocări semnificative. Complexitatea tehnică a gestionării și sincronizării calculelor între mii de noduri nesigure rămâne o provocare inginerescă formidabilă. În plus, lipsa unor cadre legale și de reglementare clare pentru sistemele autonome descentralizate și proprietatea intelectuală deținută colectiv creează incertitudine atât pentru dezvoltatori, cât și pentru investitori.

În cele din urmă, pentru ca aceste rețele să atingă viabilitate pe termen lung, trebuie să evolueze dincolo de speculație și să atragă clienți reali, plătitori pentru serviciile lor de calcul, generând astfel venituri sustenabile, conduse de protocol. Și credem că în cele din urmă vor traversa drumul chiar înainte de speculația noastră.