Datele vorbesc! Capacitatea de calcul „bazată pe spațiu” a lui Musk nu este o păcăleală: 20 de ori capacitate + 90% reducere a costurilor, în 3 ani se va schimba regulile capacității de calcul AI

După ce am analizat datele esențiale din aceste grafice, am realizat că strategia „capacității de calcul spațiale” a SpaceX și xAI nu este o fantezie — este susținută de date solide, fiecare pas atingând precis punctele sensibile ale capacității de calcul globale!

Să ne uităm întâi la cele 3 puncte slabe ale capacității de calcul globale (datele lovesc direct):

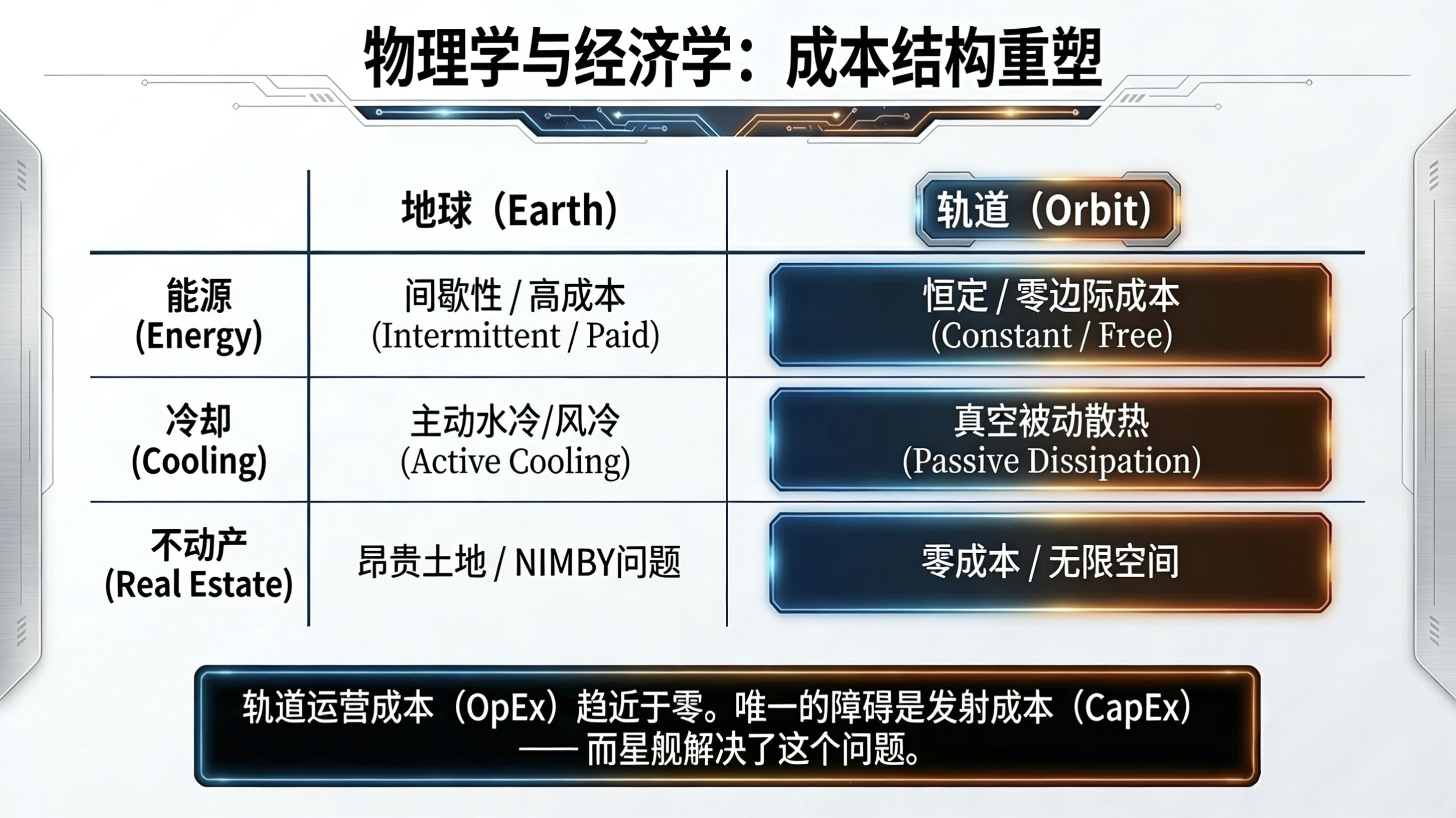

1. Energie de constrângere: 70% din consumul de energie al centrelor de date terestre se cheltuie pe răcire, antrenarea unui AGI necesită de 1000 de ori puterea de calcul actuală, iar deficitul rețelei electrice globale ajunge la 300GW;

2. Costuri ridicate: costurile de răcire pentru un singur server AI depășesc 50.000 de dolari pe an, iar chiria pe metru pătrat pentru sala de servere depășește 2.000 de dolari pe an;

3. Limitele desfășurării: există doar 590 de centre de supercomputing în întreaga lume, iar puterea de calcul este concentrată în câteva zone, cu o perioadă de extindere de 18-24 de luni.

Privind soluția spațială a lui Musk, datele sunt și mai dure:

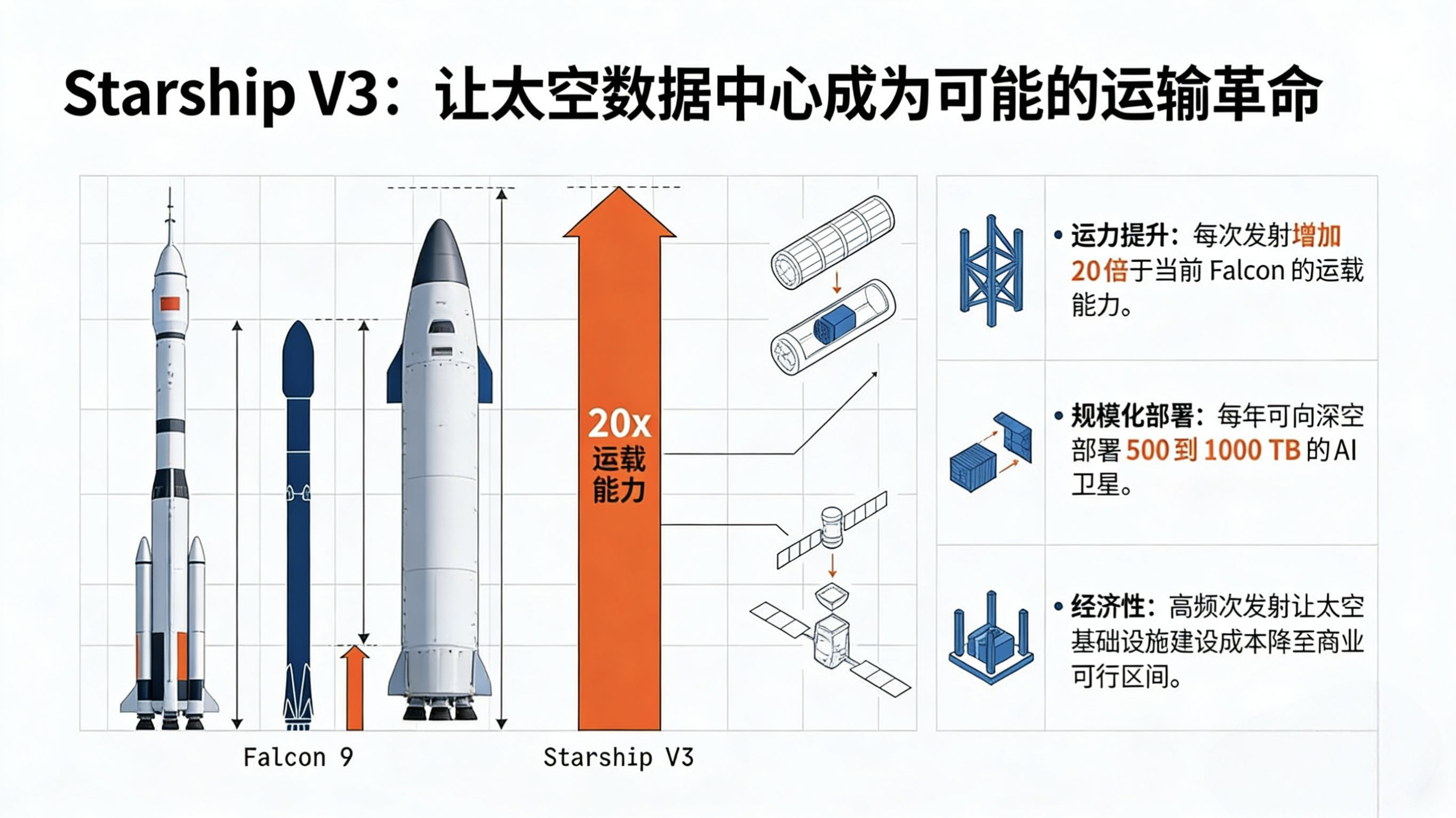

- Revoluția capacității de transport: Starship V3 are o capacitate de 250 de tone, de 20 de ori mai mult decât Falcon 9, putând transporta 10 noduri de sateliți AI (fiecare nod având o putere de calcul echivalentă cu un centru mic sau mediu de supercomputing);

- Costurile au fost reduse drastic: costurile de energie ale centrului de date de pe orbită se apropie de 0 (energie solară 24 de ore), costurile de răcire au fost reduse cu 90% (răcire pasivă în vid), costul lansării a fost comprimat de la 2700 $/kg pentru Falcon 9 la sub 100 $/kg;

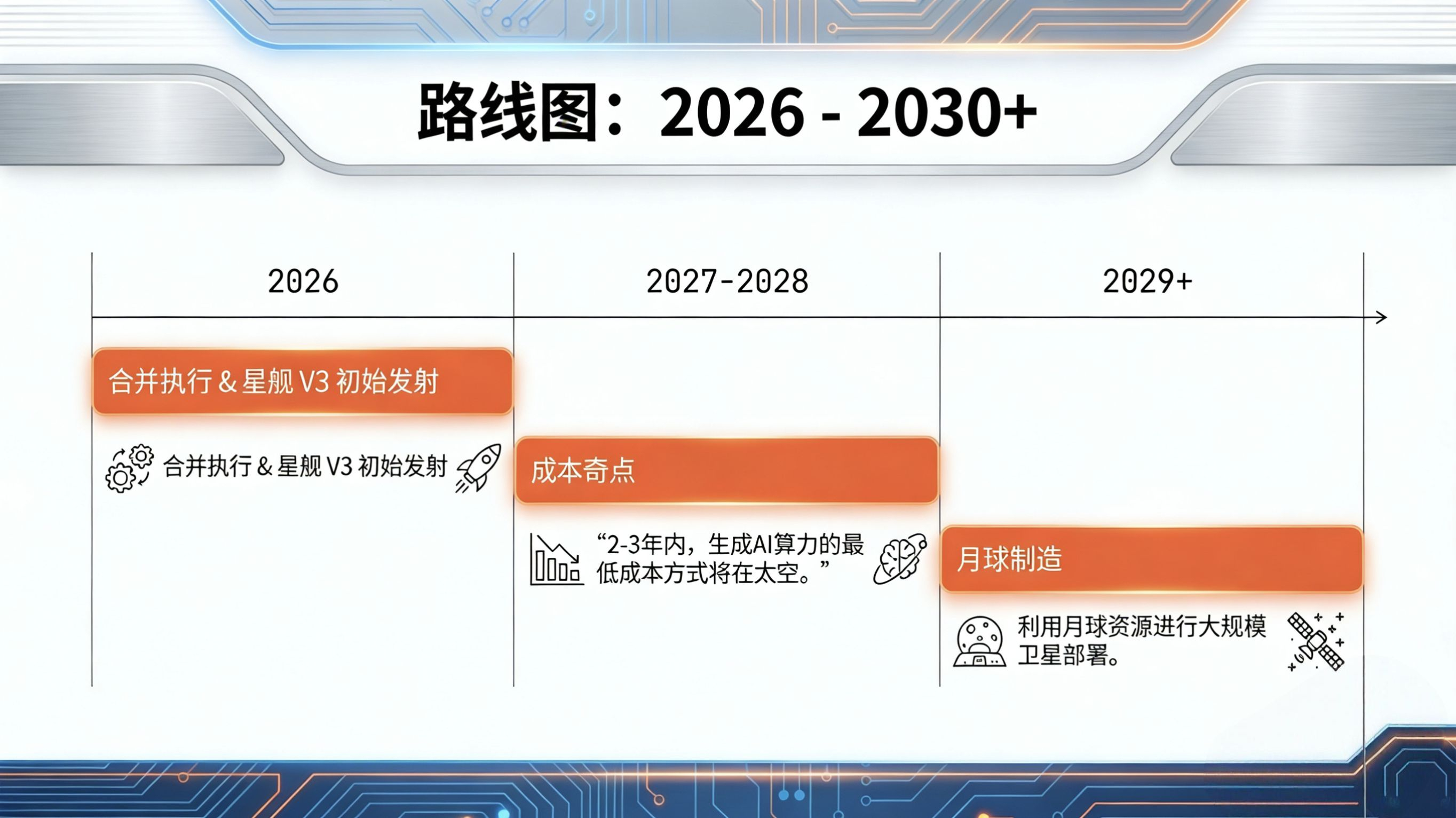

- Eficiența desfășurării: 500-1000TB de sateliți de calcul pot fi lansate într-un an, iar perioada de extindere este redusă la 3-6 luni, de 6 ori mai rapid decât pe Pământ;

- Aranjamentul final: după implementarea planului de fabrică de pe Lună, folosind resursele lunare + lansări cu propulsie electromagnetică, costurile de transport ale echipamentelor de calcul vor fi reduse cu încă 40%, formând o lanț de aprovizionare de calcul „Pământ-Lună-Orbită”.

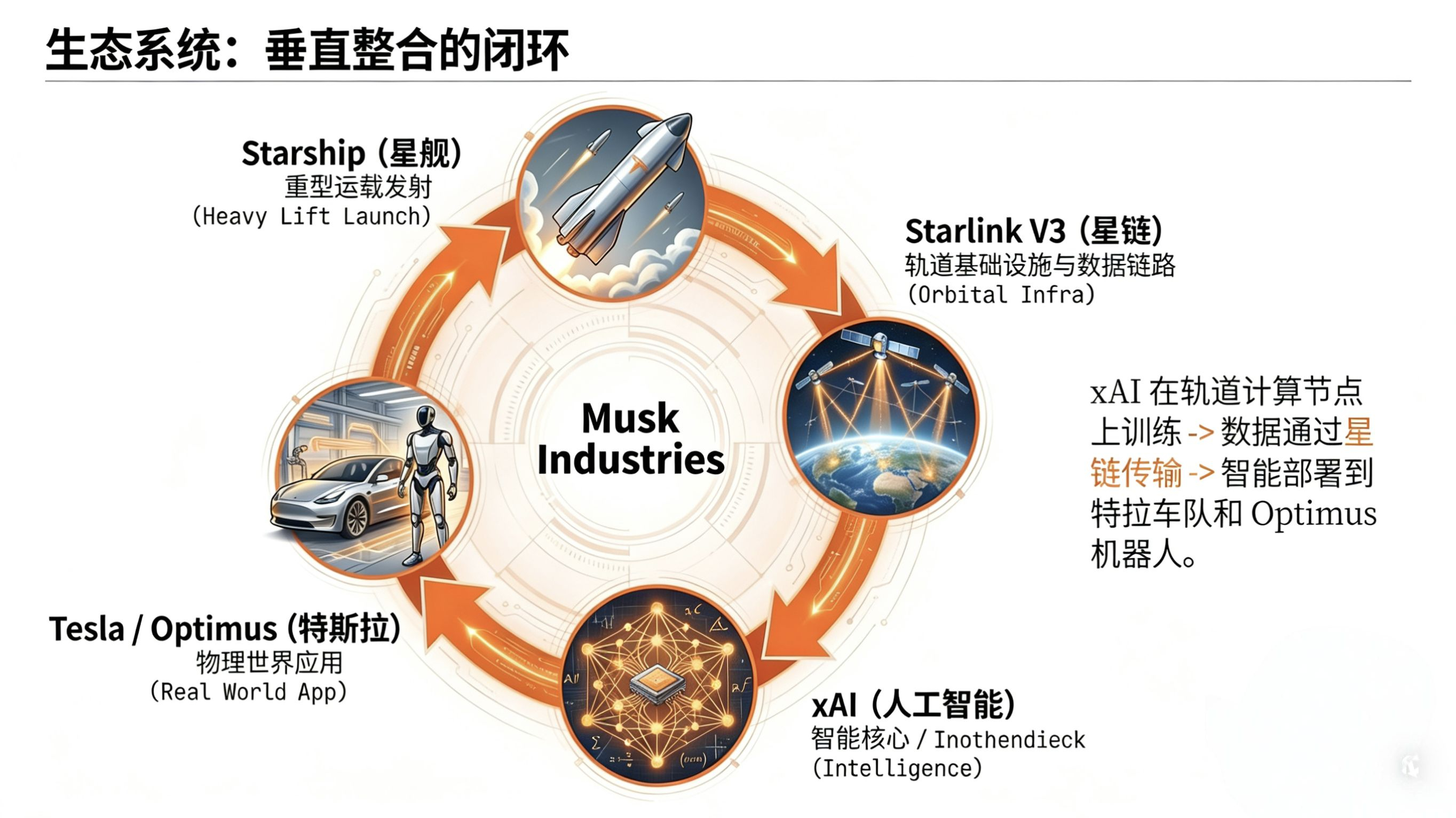

Mai important este logica închisă: Starship (transport) → Starlink (transmisie de date, întârziere globală <20ms) → noduri AI de pe orbită (antrenament, densitatea de calcul este de 3 ori mai mare decât pe Pământ) → Tesla/Optimus (aplicații), fiecare etapă având suport de date:

- Starlink acoperă 95% din suprafața terestră a Pământului, putând conecta fără probleme orbita cu terminalele de pe Pământ;

- Densitatea de calcul a nodurilor AI de pe orbită ajunge la 1.2PFLOPS/metru cub, de 3 ori mai mult decât centrele de supercomputing de pe Pământ;

- Până în 2027, se preconizează desfășurarea a 100.000 de sateliți de calcul, având o putere de calcul de 10 ori mai mare decât suma totală a supercomputing-ului global actual.

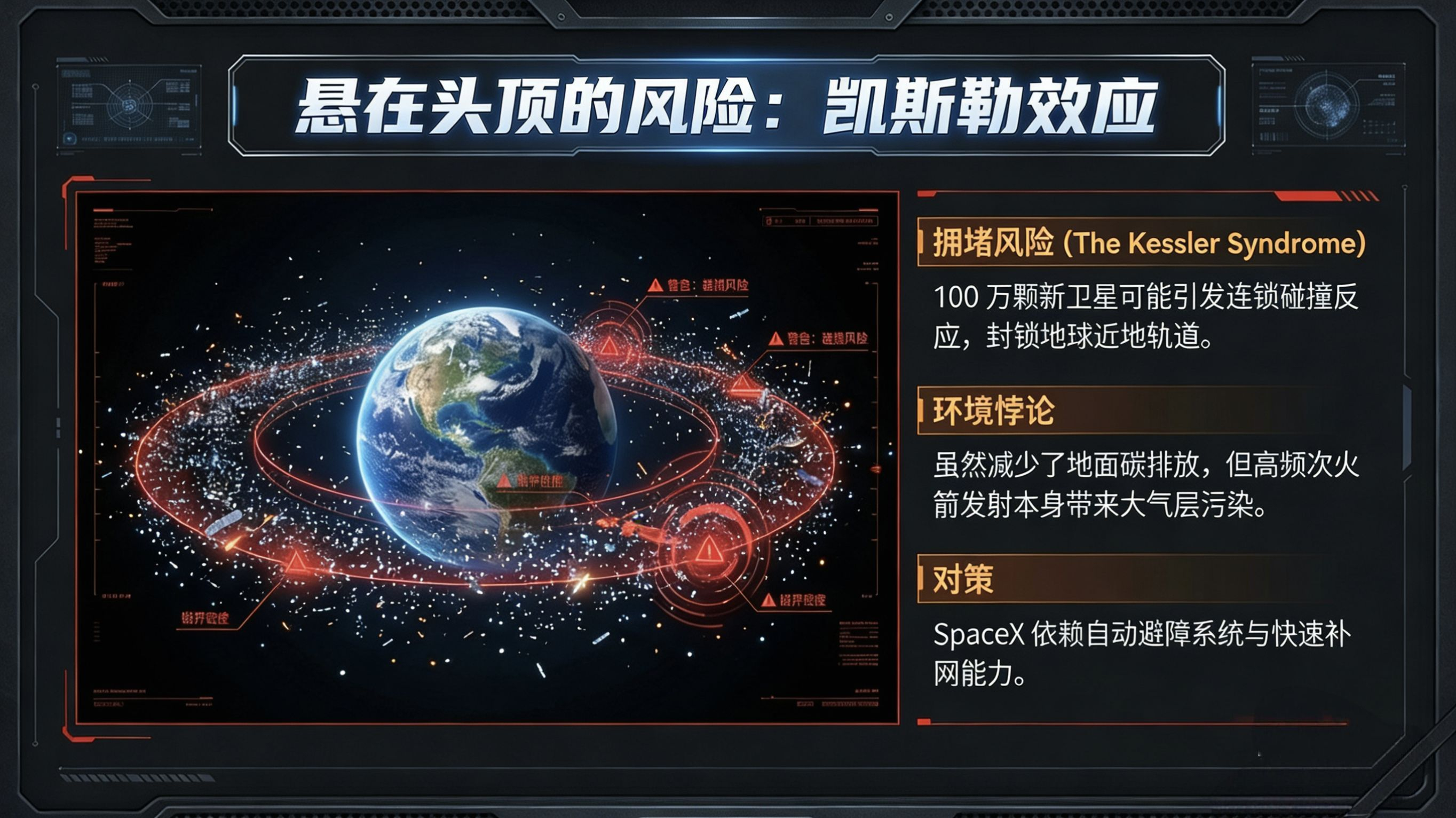

Deși riscurile există, datele oferă deja direcții de acțiune:

- Riscul de deșeuri spațiale: tehnologia recuperabilă a Starship + sistemul autonom de evitare a coliziunilor pentru sateliți va controla probabilitatea de coliziune sub 0.03%;

- Poluarea din lansări: combustibilul pe bază de metan este cu 60% mai curat decât kerosenul, iar împreună cu rachetele reutilizabile, emisiile de carbon pe unitatea de calcul sunt doar 1/5 din cele ale centrelor de date de pe Pământ.

Acum înțeleg, aceasta nu este o „idee nebună”, ci o „inevitabilitate bazată pe date” - când curba costului pentru capacitatea de calcul de pe Pământ atinge vârful, dar natura favorabilă a spațiului + avansul ingineresc al Starship, a făcut ca modelul de cost pentru „capacitatea de calcul bazată pe cer” să fie mai bun decât pe Pământ. În maxim 3 ani, prețul pe unitate de capacitate pentru AI generativ ar putea scădea de la 0.05 $/GFLOPS la 0.001 $/GFLOPS, iar cei care oferă această capacitate sunt grupurile de sateliți de pe orbita Pământului.