Ich komme immer wieder zu einer einfachen Frustration mit KI-Agenten zurück: Sie erinnern sich nicht wirklich. Meine Gespräche mit ihnen können im Moment reibungslos erscheinen, aber in dem Moment, in dem ich einen neuen Thread beginne, die Werkzeuge wechsle oder einen Agentenprozess neu starte, springt die "Beziehung" auf null zurück. Eine Zeit lang habe ich mir gesagt, das sei einfach der Preis für die Arbeit mit probabilistischen Modellen, aber lately fühlt es sich mehr nach einer vermeidbaren Designentscheidung an – und da klickt Vanars Idee von "nativem Gedächtnis" für mich.

Ich meine nicht "speichere das Chat-Protokoll irgendwo und hoffe, dass die Wiederherstellung die richtige Zeile findet." Ich meine Gedächtnis, das als Infrastruktur behandelt wird: ein dauerhafter Zustand, auf den der Agent sich verlassen kann, mit klaren Regeln, was geschrieben wird, was abgerufen wird und wem es gehört. Was jetzt anders ist, ist, dass die großen Assistenten diese Art von Persistenz zu einer allgemeinen Erwartung machen. OpenAI hat beschrieben, dass ChatGPT Details über Chats hinweg erinnert, mit Kontrollen zum Anzeigen, Löschen oder Deaktivieren des Gedächtnisses. Anthropic hat Gedächtnis für Claude eingeführt, mit einem Schwerpunkt darauf, was erinnert wird, inspizieren und bearbeiten zu können, und darauf, separate Erinnerungen für separate Projekte zu behalten, damit sich die Kontexte nicht vermischen. Googles Gemini hat ebenfalls eine Gedächtnisfunktion eingeführt, die Vorlieben und Details über Gespräche hinweg für Abonnenten erinnern kann.

Das ist jetzt wichtig, weil wir Agenten weniger wie Suchfelder und mehr wie fortlaufende Mitarbeiter behandeln. Wir wollen, dass sie ein Projekt im Auge behalten, zwischen Werkzeugen wechseln, ohne den Überblick zu verlieren, und sich wie derselbe Assistent von einem Moment zum nächsten anfühlen – selbst wenn die Sitzung zurückgesetzt wird oder sich die Umgebung ändert. Große Kontextfenster können helfen, sicher, aber sie sind ein grobes Instrument. Sie sind teuer, sie sind nicht immer zuverlässig und sie lösen nicht das tiefere Problem: Der Agent hat immer noch keine dauerhafte Identität. Früher nahm ich an, dass "gib ihm einfach mehr Kontext" uns den Großteil des Weges bringen würde, aber je mehr ich sehe, wie Menschen versuchen, echte, mehrstufige Arbeiten mit Agenten zu erledigen, desto klarer wird es. Der Engpass ist nicht die Intelligenz im Moment. Es ist die Kontinuität über die Zeit. Damit sich ein Agent wie ein echter Mitarbeiter anfühlt, sollte er sich daran erinnern, was wichtig ist: deine Vorlieben, deine Regeln und das gemeinsame Verständnis, das du entwickelt hast, anstatt dich in jeder neuen Sitzung zum Wiederholen zu bringen.

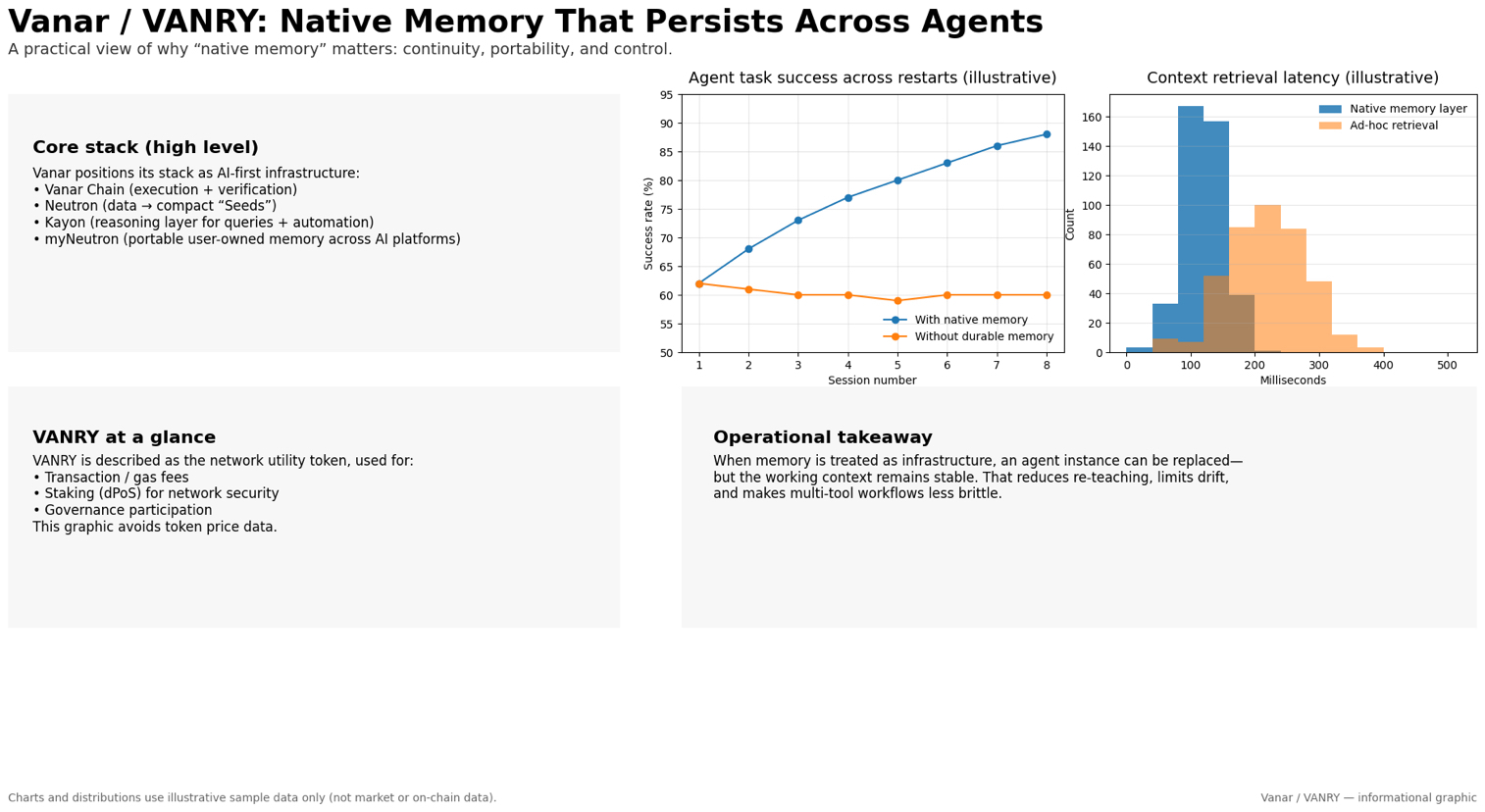

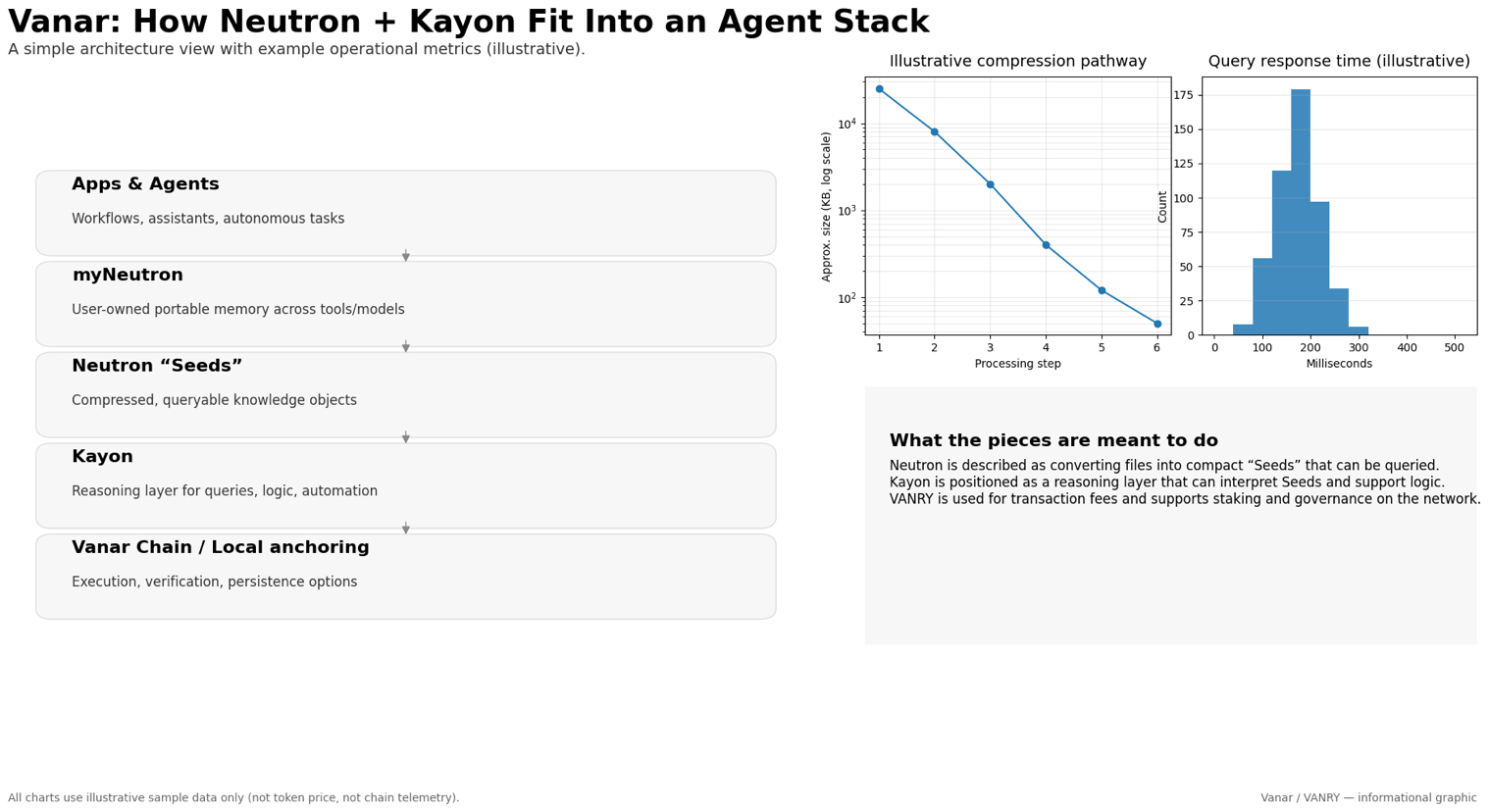

Vanar argumentiert im Grunde, dass Agenten ins Stocken geraten, wenn die Erinnerung nachträglich angepasst bleibt. Ihr Vorschlag ist, dass die Erinnerung ausreichend nativ sein sollte, um über Werkzeuge hinweg tragbar und über Neustarts hinweg haltbar zu sein. Sie rahmen MyNeutron als universelle Erinnerung ein, die tragbar und privat ist, mit der Idee, dass der Benutzer sie besitzt, und mit der Option, sie lokal zu halten oder sie auf ihrer Kette zu verankern. Unter diesem Schirm beschreiben sie Neutron als ein Werkzeug, das Rohdateien nimmt und sie in kompakte, abfragbare Wissensobjekte verwandelt, die sie "Seeds" nennen, und sie positionieren Kayon als eine Denkebene, die es Agenten und Smart Contracts ermöglicht, auf diese gespeicherten, komprimierten Daten innerhalb derselben Umgebung zuzugreifen und Logik anzuwenden.

Ich finde es hilfreich, all das in ein einfacheres operationelles Bild zu übersetzen: Mach die Agenteninstanz entbehrlich, aber lass die Erinnerung länger bestehen. Wenn du das tun kannst, dann hört das Wechseln von Modellen oder das Verschieben der Ausführung auf, ein Reset-Knopf zu sein. Der Agent kann den Faden wieder aufnehmen, ohne dass du deine Vorlieben erneut angeben, dieselben Dokumente erneut hochladen oder den Kontext eines Projekts erneut erklären musst. Es ändert auch, was "Werkzeugnutzung" bedeutet. Anstatt dass der Agent alles ergreift, was er aus einem vorübergehenden Eingabefenster bekommen kann, kann er aus einer stabilen Bibliothek dessen ziehen, was du bereits als relevant vereinbart hast.

Natürlich ist persistente Erinnerung nicht automatisch gut. Sie kann Kontexte mischen, die du nicht beabsichtigt hast, sensible Details speichern oder etwas Falsches mit zusätzlicher Zuversicht "erinnern", weil es über die Zeit hinweg immer wieder verwendet wird. Deshalb achte ich mehr auf die langweiligen Teile – Kontrollen, Grenzen und die Fähigkeit, das, was gespeichert ist, zu inspizieren – als auf die großen Ansprüche. Ich denke nicht, dass jemand die Frage, wie man Erinnerung nützlich macht, ohne sie riskant zu machen, vollständig gelöst hat. Aber ich denke, die Richtung ist klar. Wenn wir Agenten wollen, die weniger wie einmalige Chatsitzungen und mehr wie stetige Mitarbeiter agieren, muss Erinnerung aufhören, ein Hack zu sein und Teil des Kernvertrags des Systems werden.

@Vanarchain #vanar #Vanar $VANRY