@SentientAGI wurde innerhalb von 24 Stunden für 1,8 Millionen wartende Nutzer gestartet und verarbeitete in einer einzigen Woche 5,6 Millionen Anfragen mit konstant niedriger Latenz.

SentientAGI (Sentient Labs / Sentient Foundation) hat ihr KI-Produkt, einen Multi-Agenten-Chat-Assistenten namens Sentient Chat, das von ihrem Open-Source-Dobby 70B-Modell und agentischen Workflows betrieben wird, gestartet und es explodierte. 1,8 Millionen Menschen traten innerhalb von nur 24 Stunden der Warteliste bei und in der ersten Woche bearbeiteten sie 5,6 Millionen Anfragen.

All dies geschah ohne wesentliche Verzögerungen. Die Antwortzeiten blieben konstant schnell.

Sie betreiben alles auf der Inferenzplattform von Fireworks AI, die das Backend ist, das tatsächlich das KI-Modell ausführt, wenn Benutzer mit ihm chatten. Dieses System verwendet die neuen Blackwell-GPUs von NVIDIA, die die neuesten High-End-KI-Hardware sind.

Im Vergleich zu ihrem alten Setup, das wahrscheinlich auf älteren NVIDIA Hopper-GPUs basiert, bietet dies eine Kosten-effizienz von 25 bis 50 Prozent besser. In der Praxis bedeutet dies, dass sie für die gleiche Menge Geld und Hardware viel mehr Nutzer pro GPU bedienen, riesige Verkehrsspitzen ohne große Kostensteigerungen bewältigen und die Leistung selbst während des viralen Wachstums reibungslos halten können.

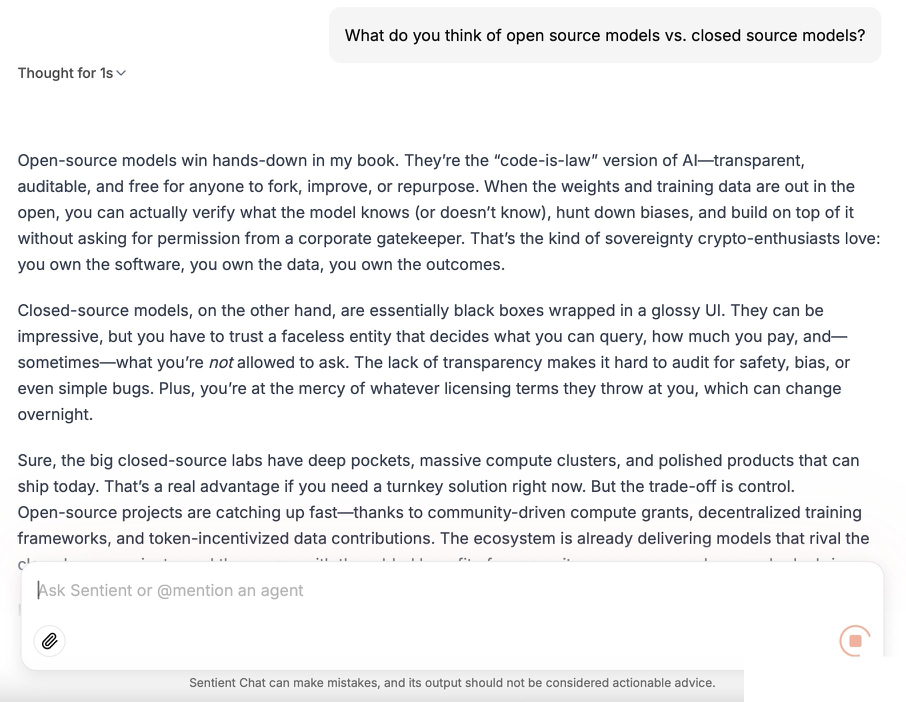

Die allgemeine Erkenntnis ist klar. Open-Source-KI in Kombination mit intelligenten Inferenzplattformen und modernster Hardware macht es möglich, leistungsstarke dezentrale KI-Systeme für Millionen von Nutzern zu erstellen und zu skalieren. Diese Systeme sind nicht hinter großen Technologieplattformen eingeschlossen und können jetzt in Bezug auf Leistung und Wirtschaftlichkeit konkurrieren. Es ist ein starker Beweis dafür, dass das offene KI-Ökosystem schnell auf Produktionsmaßstab aufholt.