Nach eingehender Untersuchung der technischen Architektur, der Marktspiele und des ökologischen Potenzials von APRO (AT) wurde mir ein grundlegendes, jedoch oft von der Marktnarrative verdecktes Problem bewusst: Der ultimative Wert eines jeden Orakels hängt nicht von der Geschwindigkeit ab, mit der es Daten überträgt, oder von der Anzahl der Ketten, sondern davon, ob die „Datenquelle“, die es liefert, selbst vertrauenswürdig, gegen Angriffe immun und nachhaltig ist.

Nach eingehender Untersuchung der technischen Architektur, der Marktspiele und des ökologischen Potenzials von APRO (AT) wurde mir ein grundlegendes, jedoch oft von der Marktnarrative verdecktes Problem bewusst: Der ultimative Wert eines jeden Orakels hängt nicht von der Geschwindigkeit ab, mit der es Daten überträgt, oder von der Anzahl der Ketten, sondern davon, ob die „Datenquelle“, die es liefert, selbst vertrauenswürdig, gegen Angriffe immun und nachhaltig ist.

Heute möchte ich den Blick von der Protokollebene nach unten richten und das von APRO angestrebte Netzwerk der Datenquellen eingehender analysieren, um seine Anordnung, Herausforderungen und die wirkliche Schutzmauer auf diesem geheimen Schlachtfeld zu beleuchten.

1. Das Dilemma der Datenquellen: Die „Achillesferse“ der Orakel-Rennbahn

Orakel werden oft als die "Datenbrücke" der Blockchain bezeichnet, aber dieser Brücke Anfangspunkt - die Datenquelle - ist oft das schwächste Glied. Traditionelle Orakel-Netzwerke sind stark von einer begrenzten Anzahl zentralisierter Premium-Datenanbieter (wie Bloomberg, Reuters) oder den APIs führender Börsen abhängig. Dies bringt dreifache Risiken mit sich:

1. Risiko eines Single Point of Failure: Wenn eine zentrale Datenquelle manipuliert oder unterbrochen wird, kann das das gesamte Netzwerk kontaminieren.

2. Kosten- und Lizenzrisiken: Professionelle Daten sind teuer, und Anbieter können die Lizenzbedingungen jederzeit ändern oder die Nutzung im Zusammenhang mit Kryptowährungen untersagen.

3. Eingeschränkte Abdeckung: Für die benötigten Unternehmensberichte, rechtlichen Dokumente, IoT-Sensordaten usw., die für RWA erforderlich sind, decken traditionelle Datenquellen nicht ausreichend ab.

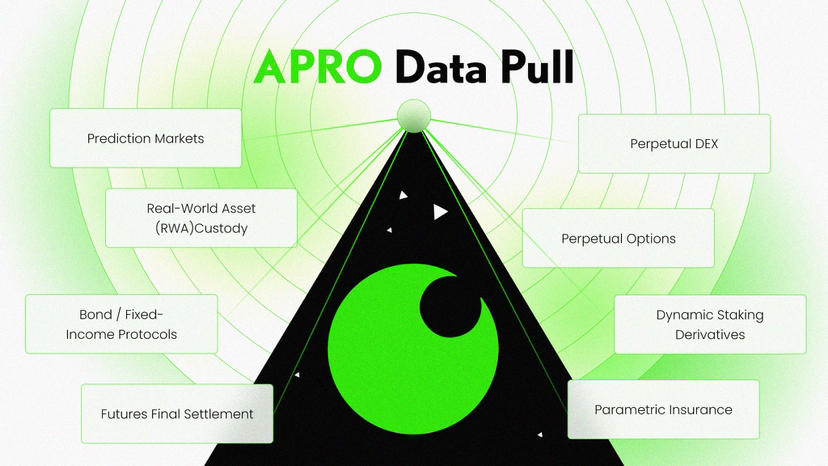

APRO behauptet, mehr als 1400 Datenquellen integriert zu haben, und sein Ehrgeiz liegt offensichtlich darin, ein redundanteres, dezentraleres Datenquellen-Matrix zu schaffen. Doch das wirft die Kernfrage auf: Wie steht es um die Qualität dieser Datenquellen, den Grad der Dezentralisierung und die Manipulationsresistenz?

Zwei, die Lösung von APRO: Mischdatenquellen und KI-gestützte Validierung

Laut seinen technischen Unterlagen hat APRO nicht das traditionelle Modell vollständig revolutioniert, sondern eine pragmatische Strategie der "Mischverstärkung" gewählt.

Ebenen eins: Breite Abdeckung und Kostenoptimierung. Durch die Aggregation einer Vielzahl von öffentlichen, kostengünstigen Datenquellen (wie Preisen von großen Börsen, öffentlichen Regierungsdaten, Satellitenbildern usw.) wird ein grundlegendes Echtzeit-Informationsnetz aufgebaut. Das "Pull-Modell" erlaubt die bedarfsorientierte Datenabfrage, mit dem Ziel, die Nutzungskosten von Langzeitdaten zu senken.

Ebenen zwei: KI-gesteuerte Qualitätsfilterung und -erzeugung. Dies ist die entscheidende Innovation von APRO. Die KI-Oracle-Engine überträgt nicht nur Daten, sondern übernimmt auch die Rolle des "primären Validierers". Zum Beispiel:

Konsistenzprüfung: Wenn ein Twitter-Konto behauptet, dass ein Unternehmen ein bedeutendes Ereignis erlebt hat, kann die KI schnell mehrere unabhängige Quellen wie Nachrichtenwebsites, offizielle Ankündigungen und Aktienkursbewegungen abrufen und vergleichen, um die Glaubwürdigkeit dieser Informationen zu bewerten, bevor sie dem Knoten-Netzwerk zur endgültigen Konsensbildung vorgelegt werden.

Unstrukturierte Datenanalyse: Für rechtliche Verträge im RWA-Szenario führt die KI eine erste Extraktion von Klauseln und Schlüsselinformationen (wie Beträge, Daten, Parteien) durch und digitalisiert sie, um schwer verarbeitbare "Dokumente" in "strukturierte Datenpunkte" zu verwandeln, die on-chain validiert werden können.

Ziel dieses Mechanismus ist es, das Risiko von Datenquellen von "Vertrauenswürdigkeit eines einzelnen Anbieters" in das Problem "Kreuzvalidierung von Multi-Quellen und Zuverlässigkeit von Algorithmen" zu verwandeln. Der AT-Token motiviert dabei zwei Schlüsselrollen: Datenquellenknoten (die Rohdaten bereitstellen) und Validierungsknoten (die KI-Modelle ausführen und am Konsens teilnehmen).

Drei, das versteckte Schlachtfeld: Das Paradoxon der Dezentralisierung von Datenquellen und der Verteilung von Token

Es gibt jedoch ein tiefgreifendes Paradoxon, das APRO bewältigen muss, und das ist die zentrale Herausforderung. Ein wirklich robustes dezentrales Oracle erfordert, dass auch die Anbieter der zugrunde liegenden Datenquellen so dezentral wie möglich sind. Doch derzeit ist die Verteilung der AT-Token-Halter stark konzentriert, wobei die fünf größten Adressen bis zu 73,5 % des Umlaufs kontrollieren. Diese Zentralisierung kann auf zwei Arten die Dezentralisierung der Datenquellen untergraben:

1. Konzentration von Governance-Macht: Wenn zukünftige, entscheidende Governance-Entscheidungen, wie zum Beispiel welche Datenquellen hinzugefügt oder entfernt werden sollen, wie die Parameter von KI-Modellen angepasst werden sollen, von den Haltern von AT abgestimmt werden, wird der Wille der Großinvestoren die Zusammensetzung der Datenquellen dominieren, was möglicherweise Vorurteile einführt oder einen Single Point of Failure schafft.

2. Risiko der Zentralisierung von Knoten: Der Betrieb von Datenquellenknoten und KI-Validierungsknoten erfordert technische Fähigkeiten und Kapital. Großinvestoren haben die Fähigkeit und Motivation, groß angelegte Knotencluster zu betreiben, was dazu führen kann, dass das Netzwerk faktisch von einer kleinen Anzahl von Entitäten kontrolliert wird und wieder auf den alten Weg zentralisierter Datenanbieter zurückfällt, nur mit einer Schicht Blockchain obendrauf.

Obwohl das Projekt die Unterstützung von Top-Institutionen wie Polychain Capital und Franklin Templeton erhielt, was die Anerkennung des Kapitals für seine Technologie beweist, löst es nicht direkt das Problem der Dezentralisierung auf der Ebene der Datenquellen. Anonyme Teams haben in der Anfangsphase geholfen, sich auf die Entwicklung zu konzentrieren, aber langfristig kann das Fehlen von rechenschaftspflichtigen Einheiten zur Bewältigung der rechtlichen und Compliance-Streitigkeiten, die durch Datenquellen entstehen, ebenfalls ein Risiko darstellen.

Vier, Zukunftsausblick: Aufbau eines nicht reproduzierbaren Datenökosystems

Daher liegt die langfristige Wettbewerbsfähigkeit von APRO nicht darin, dass es 40 Blockchains angebunden hat, sondern ob es ein einzigartiges, schwer reproduzierbares und nachhaltig wachsendes Ökosystem von Datenquellen aufbauen kann. Ich denke, dass sich seine zukünftige Entwicklung entlang der folgenden Achsen entfalten wird:

Vertikale Vertiefung: In den beiden Kernbereichen RWA und KI strategische Partnerschaften mit autoritativen Datenanbietern (wie Wirtschaftsprüfungsgesellschaften, Anwaltskanzleien, offiziellen Institutionen) aufbauen und sogar durch Knotenanreize diese "Vertrauensanker" der traditionellen Welt in das Netzwerk integrieren, um exklusive oder hochauflösende Datenkanäle zu erhalten.

Anreize zur Innovation: Entwickeln Sie detailliertere Token-Ökonomiemodelle, die nicht nur die Validierungsknoten belohnen, sondern auch erheblich diejenigen anreizen, die einzigartige, wertvolle und manipulationssichere Datenquellen bereitstellen. Lassen Sie Knoten, die Preisdaten von landwirtschaftlichen Produkten in abgelegenen Gebieten oder spezifische Informationen über Lieferkettenlogistik bereitstellen, ebenfalls großzügige Belohnungen erhalten.

Gemeinschaftsgovernance-Evolution: Es müssen Mechanismen entworfen werden (wie die schrittweise Übertragung von Governance-Rechten an breitere Knotenbetreiber, Einführung von Reputationssystemen usw.), um das Monopol der Konzentration von Token-Halten auf die Governance der Datenquellen zu brechen. Dies ist der Schlüssel zur Verwirklichung der Vision einer "vertrauenswürdigen Daten-Demokratisierung".

Zusammenfassung

Für mich besteht die entscheidende Frage bei der Bewertung von APRO (AT) nicht mehr darin, ob die Technologie fortschrittlich ist, sondern ob das Netzwerk der Datenquellen robust, vielfältig und dezentral genug ist.

Datenquellen sind die "Wasserquellen" der digitalen Welt. Wer die Wasserquelle kontrolliert, kontrolliert alle nachgelagerten Anwendungen. Der Wert von AT wird letztendlich an der Einzigartigkeit und Unveränderlichkeit der verbundenen Datenquellen verankert.

Investoren sollten nicht nur darauf achten, wie viele Blockchains integriert wurden, sondern auch welche hochwertigen Datenpartner neu hinzugekommen sind, ob die Anzahl der Datenquellenknoten und deren geografische Verteilung dezentralisiert sind und ob es Killeranwendungen gibt, die auf exklusiven Datenquellen von APRO basieren.

Wenn es APRO gelingt, tausende von dezentralen, vertrauenswürdigen Datenquellen zu einem unzertrennlichen Netz zu verweben, dann wird AT der ultimative Träger des Wertwachstums dieses Netzes sein.

Andernfalls könnte es lediglich ein weiterer Übertragungskanal sein, der in einem intensiven Wettbewerb in ein rotes Meer gerät. Dieser Kampf um Datenquellen ist das geheime Hauptschlachtfeld, das über Leben und Tod von Oracle-Projekten entscheidet.