Il existe une tension fondamentale au cœur des systèmes décentralisés que la plupart des gens acceptent comme inévitable : vous pouvez avoir la sécurité, vous pouvez avoir l'efficacité, ou vous pouvez avoir l'échelle, mais obtenir les trois simultanément semble nécessiter de briser les lois de la physique. Chaque blockchain lancée au cours de la dernière décennie a essentiellement choisi deux de ces trois et a fait la paix avec le compromis. Ceux qui ont choisi la sécurité et l'échelle ont fini par répliquer des données des centaines de fois à travers les validateurs, brûlant des ressources et limitant ce qui est réellement construisible. Ceux qui ont choisi l'efficacité et l'échelle ont souvent compromis sur la sécurité de manières qui ne deviennent évidentes que lorsque quelque chose échoue de manière catastrophique.

Walrus aborde cela différemment en reconnaissant que l'énoncé du problème lui-même était incomplet. La vraie question n'est pas comment stocker des données efficacement à travers des nœuds décentralisés. La vraie question est comment rendre les données survivables et récupérables même lorsqu'une partie significative de votre réseau disparaît, tout en maintenant des coûts suffisamment bas pour que le système puisse réellement rivaliser avec les alternatives centralisées. C'est la différence entre optimiser pour la perfection théorique et optimiser pour ce qui se passe réellement lorsque l'infrastructure fonctionne à l'échelle dans le monde réel.

L'idée qui motive Walrus provient de la compréhension de ce que le stockage décentralisé a mal compris depuis le début. Des systèmes comme IPFS et Filecoin ont adopté la réplication complète, ce qui signifie stocker des copies complètes de fichiers sur plusieurs nœuds. Cela fonctionne, dans le sens où vos données restent accessibles tant qu'un seul nœud honnête survit. Mais l'économie devient rapidement absurde. Si vous voulez douze nines de fiabilité, ce qui signifie moins d'une chance sur un trillion de perdre l'accès à votre fichier, vous avez besoin d'environ vingt-cinq copies complètes distribuées à travers le réseau. C'est un surcoût de stockage de vingt-cinq fois, ce qui rend le stockage décentralisé prohibitif.

L'alternative qui a émergé était le codage d'effacement, où les fichiers sont divisés en fragments qui peuvent reconstruire l'original à partir de tout sous-ensemble suffisant. Le codage Reed Solomon, l'approche standard, peut atteindre le même niveau de sécurité avec seulement trois fois le surcoût de stockage. Cela semble être une amélioration massive, et c'est le cas, jusqu'à ce que vous rencontriez le problème de récupération. Lorsqu'un nœud de stockage se déconnecte, ce qui arrive constamment dans tout système réel, le codage d'effacement traditionnel nécessite de transmettre le fichier entier à travers le réseau pour reconstruire les pièces manquantes. Faites cela suffisamment de fois et les coûts de bande passante effacent tout ce que vous avez économisé sur le stockage.

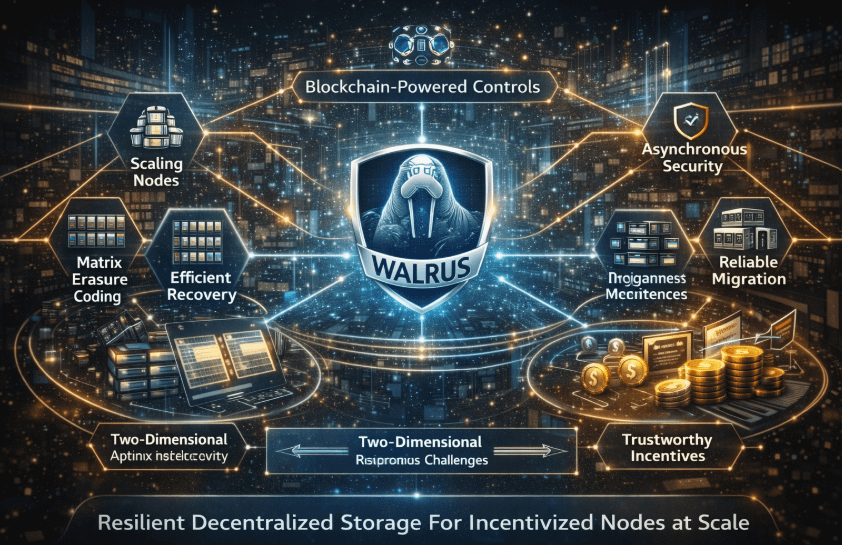

C'est ici que Walrus introduit Red Stuff, un protocole de codage d'effacement à deux dimensions qui change fondamentalement l'économie de récupération. Au lieu d'encoder des données dans une seule dimension où la reconstruction nécessite de télécharger tout, Red Stuff encode à la fois horizontalement et verticalement dans une structure matricielle. Lorsqu'un nœud doit récupérer ses données manquantes, il ne télécharge que les symboles spécifiques qui lui manquent auprès d'autres nœuds, pas le fichier entier. Le coût de bande passante évolue proportionnellement aux données perdues, et non à la taille totale du fichier. Pour un système avec mille nœuds, cela signifie que les coûts de récupération passent de l'équivalent de télécharger le fichier complet à ne télécharger qu'un millième de celui-ci.

Les implications vont bien au-delà des simples économies de bande passante. Dans les systèmes traditionnels, un fort changement de nœuds, le va-et-vient naturel des participants dans un réseau sans autorisation, crée un problème existentiel. Chaque fois que des nœuds partent et rejoignent, vous transmettez d'énormes quantités de données pour la récupération, ce qui devient rapidement insoutenable. Red Stuff rend le changement gérable car la récupération est suffisamment bon marché pour se produire en continu sans submerger le réseau. Cela permet quelque chose que la plupart des systèmes de stockage décentralisés ne peuvent réellement pas livrer : une véritable absence de permission où les nœuds peuvent entrer et sortir librement sans exiger que l'ensemble du système se mette en pause et se réorganise.

Mais l'efficacité sans garanties de sécurité n'est qu'un échec coûteux en attente de se produire. C'est ici que Walrus fait une autre innovation critique en étant le premier protocole de stockage à prendre en charge des mécanismes de défi asynchrones. Dans chaque autre système de stockage décentralisé, prouver que les nœuds stockent réellement ce qu'ils prétendent nécessite de supposer la synchronie du réseau. Le protocole envoie un défi et s'attend à une réponse immédiate. Si les nœuds répondent suffisamment rapidement, ils réussissent. Le problème est que les nœuds adversaires peuvent simplement ne pas stocker les données, attendre le défi, télécharger rapidement ce dont ils ont besoin auprès de nœuds honnêtes, et répondre avant l'expiration du délai. Le système pense qu'ils stockent des données alors qu'ils profitent en réalité.

Walrus résout cela à travers la même structure de codage à deux dimensions. Lorsque des défis se produisent, les nœuds cessent de répondre aux demandes de lecture régulières et passent en mode défi. Parce que la reconstruction nécessite des symboles de nœuds honnêtes et que ces nœuds honnêtes ont cessé de servir des demandes régulières, les nœuds adversaires ne peuvent pas rassembler suffisamment d'informations pour simuler leur passage à travers les défis. Ils ont soit les données stockées localement, soit ils échouent, point final. Cela fonctionne dans des réseaux entièrement asynchrones où les délais de message sont imprévisibles, en faisant la première solution pratique pour prouver le stockage sans hypothèses de timing.

La sophistication technique s'étend à la façon dont Walrus gère les transitions de comité entre les époques. La plupart des systèmes blockchain ont du mal avec la reconfiguration car vous devez maintenir le service tout en migrant simultanément l'état vers de nouveaux participants. Walrus met en œuvre un protocole de changement d'époque en plusieurs étapes où les écritures sont immédiatement redirigées vers le nouveau comité tandis que les lectures continuent à partir de l'ancien comité. Cela empêche la condition de course où de nouvelles données continuent d'arriver plus vite que les nœuds partants ne peuvent transférer leurs responsabilités. Les nœuds de stockage signalent explicitement quand ils ont terminé leur migration, et seulement après qu'une supermajorité confirme, le système transitionne complètement. Cela permet une opération continue sans temps d'arrêt même lorsque l'ensemble des participants change complètement.

Ce qui rend cela pratiquement viable, c'est l'intégration avec la blockchain Sui comme plan de contrôle. Plutôt que de construire encore une autre blockchain à partir de zéro pour coordonner les nœuds de stockage, Walrus tire parti de Sui pour toutes les opérations de métadonnées, le traitement des paiements et la gouvernance. Les nœuds de stockage s'enregistrent sur Sui, les certificats de disponibilité y sont publiés, et l'ensemble de la structure d'incitation fonctionne à travers des contrats intelligents. Cette séparation des préoccupations signifie que Walrus peut se concentrer uniquement sur ce qu'il fait de manière unique, le stockage et la récupération efficaces de blobs, tout en héritant de la sécurité de consensus et du débit de transaction de Sui pour la coordination.

Le modèle économique reflète une pensée sophistiquée sur l'application à long terme des contrats dans les systèmes décentralisés. Les nœuds de stockage mettent en jeu des capitaux qui gagnent des récompenses pour un comportement honnête et sont réduits pour des échecs. Mais plutôt que d'exiger des nœuds de verrouiller d'énormes montants à l'avance, le système utilise des pénalités dynamiques calibrées en fonction du comportement réel. Les nœuds qui échouent aux défis de stockage ou qui ne participent pas à la récupération des shards font face à des réductions significatives, tandis que les nœuds qui performent constamment bien accumulent des récompenses. La couche de mise en jeu prend en charge la délégation, de sorte que les utilisateurs qui souhaitent participer à la sécurité du réseau sans faire fonctionner l'infrastructure peuvent miser avec des opérateurs professionnels, créant une spécialisation naturelle.

La tarification se fait à travers un mécanisme de consensus où les nœuds de stockage votent sur les tailles de shard et les prix un plein époque à l'avance. Le système prend la soumission du soixante-sixième centile pour la capacité et le coût, garantissant que deux tiers des nœuds par participation offrent au moins cette capacité à ce prix ou mieux. Cela empêche un seul nœud de manipuler les prix tout en reflétant toujours les dynamiques du marché. Les ressources de stockage deviennent des objets échangeables sur Sui, permettant des marchés secondaires où les utilisateurs peuvent acheter, vendre ou transférer des allocations de stockage de manière efficace.

Le défi que la plupart des gens ne voient pas à propos du stockage décentralisé n'est pas du tout technique. C'est de savoir si le système peut offrir une fiabilité qui compte pour de vraies applications tout en maintenant des coûts qui ont du sens économiquement. Stocker des métadonnées NFT hors chaîne est inutile si ces métadonnées peuvent disparaître ou devenir prohibitivement chères à accéder. Utiliser le stockage décentralisé pour des ensembles de données d'entraînement d'IA ne fonctionne que si vous pouvez réellement récupérer des téraoctets de données rapidement au besoin. Exécuter des applications décentralisées avec des interfaces fournies par un stockage décentralisé nécessite la confiance que ces interfaces se chargeront de manière fiable pour les utilisateurs.

Walrus exploite actuellement un testnet public avec plus de cent nœuds de stockage opérés indépendamment s'étendant sur dix-sept pays. Ce ne sont pas des nœuds de test fonctionnant dans des environnements contrôlés. Ce sont de vraies infrastructures gérées par différents opérateurs utilisant différents fournisseurs d'hébergement, différentes configurations matérielles, différentes conditions réseau. Le système gère régulièrement des blobs allant de kilooctets à des centaines de mégaoctets avec une latence de lecture inférieure à quinze secondes pour de petits fichiers et une latence d'écriture évoluant linéairement avec la taille des blobs. La capacité totale du réseau dépasse cinq pétaoctets, démontrant que l'architecture évolue réellement avec le nombre de nœuds plutôt que d'atteindre des plafonds artificiels.

Ce que nous observons avec Walrus est une infrastructure qui a pris au sérieux les contraintes fondamentales du stockage décentralisé pour redessiner à partir des premiers principes plutôt que d'améliorer progressivement les approches existantes. Le résultat est un système où la sécurité provient des propriétés cryptographiques et des structures de redondance plutôt que d'une réplication aveugle, où la récupération se produit suffisamment efficacement pour gérer le changement réel, où les défis prouvent le stockage sans hypothèses de synchronie, et où l'économie fonctionne réellement à l'échelle. Cela compte parce que le stockage décentralisé cesse d'être une curiosité théorique et devient une infrastructure sur laquelle les applications peuvent véritablement compter.

L'implication plus large est que nous voyons enfin les systèmes décentralisés mûrir au-delà de l'étape où chaque problème se résout en lançant plus de réplication. Walrus démontre qu'un design de protocole soigné peut offrir des garanties de sécurité équivalentes à un sur-provisionnement massif tout en fonctionnant à des coûts qui rivalisent avec les alternatives centralisées. Ce n'est pas seulement une réalisation d'ingénierie. C'est la différence entre le stockage décentralisé restant une solution de niche pour de vrais croyants et devenant une infrastructure qui a du sens pour les applications grand public ayant besoin de stockage de données crédiblement neutre, résistant à la censure et vérifiably disponible.