Il crepuscolo non è la svolta in termini di privacy verificabile con risultati responsabili. La maggior parte delle persone lo perde perché tratta “privato” come un'impostazione dell'interfaccia utente anziché come una garanzia del sistema. Cambia ciò che i costruttori possono automatizzare in sicurezza senza chiedere agli utenti di scambiare dignità per accesso.

Ho visto abbastanza fallire sistemi on-chain in modi noiosi e prevedibili da concentrarmi meno sulle funzionalità e più su ciò che può essere dimostrato sotto stress. La prima volta che ho visto disegni “confidenziali” discussi seriamente, ciò che si è distinto non era il segreto, ma l'idea di ridurre la superficie di fiducia. In pratica, gli utenti non vogliono mistero; vogliono certezza che le regole si applichino in modo equo, anche quando i dettagli rimangono nascosti.

L'attrito concreto è un divario di fiducia tra tre parti che hanno tutti incentivi diversi: utenti che vogliono privacy, applicazioni che necessitano di enforcement e validatori che devono verificare senza diventare una fuga di dati. Le catene trasparenti rendono facile la verifica ma espongono saldi, strategie, stipendi e identità attraverso l'inferenza. I sistemi completamente privati possono proteggere i dati, ma se gli osservatori non possono verificare il rispetto delle regole, si introduce un rischio diverso: enforcement selettivo, inflazione nascosta o “trattamento speciale” che appare solo quando è troppo tardi. Nei mercati, ciò è fatale - non perché la gente odia la privacy, ma perché odia non sapere se il gioco è equo.

È come fare un audit in cui i numeri sono nascosti, ma il contabile può comunque dimostrare che ogni totale è corretto.

L'idea centrale su cui Dusk si basa è questa: mantenere i dati sensibili al di fuori della superficie pubblica, ma costringere ogni cambiamento di stato a venire con una prova crittografica che le regole siano state seguite. Questo influisce prima sul modello di stato. Invece di un registro puramente pubblico in cui lo stato è leggibile da tutti, lo stato della catena può essere rappresentato come impegni: “lucchetti” compatti a saldi e condizioni. La catena non ha bisogno di memorizzare i dettagli del tuo account; memorizza impegni più abbastanza metadati pubblici per prevenire spese doppie e sequenziare aggiornamenti. Quando avviene una transazione, l'utente (o l'app che agisce per conto dell'utente) costruisce una prova che è autorizzato e che la transizione è valida - per esempio, che gli input esistono, non sono spesi e che gli output conservano valore e rispettano i vincoli senza rivelare gli importi sottostanti o le identità oltre a quanto richiesto dal protocollo.

Il flusso di transazione/verifica diventa semplice nello spirito anche se la matematica è pesante: si invia una transazione contenente impegni, una prova e firme/autorizzazioni. I validatori controllano la prova, verificano che gli impegni referenziati non siano stati spesi e quindi aggiornano l'insieme di impegni on-chain. La finalità qui riguarda l'accettazione di una prova valida nel consenso, non l'interpretabilità pubblica. La garanzia è ristretta ma potente: se la prova è verificata e il consenso la finalizza, la transizione di stato ha seguito le regole del protocollo come codificato. Ciò che non è garantito è che gli osservatori esterni possano ricostruire “perché” sia avvenuta una transazione, chi ne beneficia economicamente o quale contesto off-chain l'abbia motivata, che rimane privato per design.

Gli incentivi sono importanti perché i sistemi privati possono attrarre spam e tentativi di denial-of-service: se la verifica è costosa, gli attaccanti cercano di far lavorare la rete. Un design sano prevede l'assegnazione di costi per la verifica delle prove in modo che il calcolo pesante non sia gratuito, e allinea i validatori attraverso lo staking in modo che vengano puniti per aver accettato transizioni non valide o per aver cercato di censurare selettivamente. Le modalità di fallimento sono anche più concrete di quanto la gente ammetta. Se i sistemi di prova o i circuiti sono implementati in modo errato, possono verificarsi bug catastrofici: transizioni di stato non valide che passano comunque la verifica. Se il set di anonimato è sottile, gli utenti si rivelano attraverso tempistiche e comportamenti anche con una crittografia perfetta. Se i validatori si coordinano per censurare, la privacy non li ferma; li ferma solo dal capire i dettagli. E se gli utenti perdono le chiavi, la privacy non li salva; il protocollo farà esattamente ciò che le prove e le firme consentono.

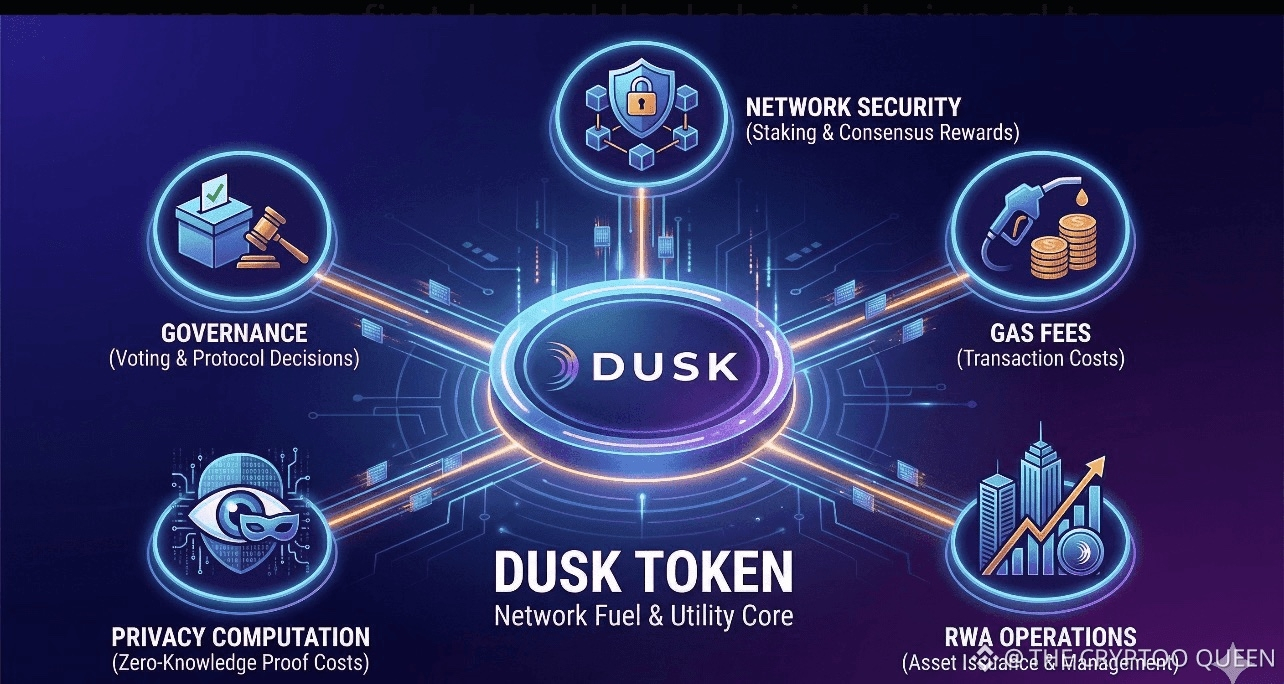

Le commissioni pagano per l'esecuzione e il lavoro di verifica, specialmente i controlli delle prove e gli aggiornamenti di stato. Lo staking supporta la partecipazione dei validatori e la responsabilità economica, perché “senza fiducia” ha comunque bisogno di pene quando qualcuno infrange le regole o mina la vivacità. La governance esiste per regolare i parametri - le tariffe, le condizioni di staking, gli aggiornamenti ai circuiti e ai vincoli - ma ciò significa anche che la governance deve essere trattata come parte del modello di minaccia, non come un vantaggio per la comunità.

I nemici del mondo reale non attaccano prima la matematica, attaccano le implementazioni, i portafogli e il comportamento degli utenti, e una catena di privacy è forte solo quanto il suo strato operativo più debole.

Se la privacy può essere resa verificabile senza trasformarsi in una scatola nera, quale caso d'uso pensi beneficerà per primo: pagamenti, trading o app con forte identità?