Sto osservando un flusso di lavoro multi-agente fare ciò che fanno quasi sempre sotto pressione. I compiti si completano. I registri sembrano puliti. Nulla fallisce rumorosamente. Ma quando il valore fluisce all'indietro, l'attribuzione si offusca. Un agente tocca tutto e assorbe il credito. Un altro fa il lavoro duro e scompare. Ho visto esattamente questo schema in DAO, set di validatori e sistemi di rendimento. Gli incentivi marciscono molto prima che i sistemi collassino.

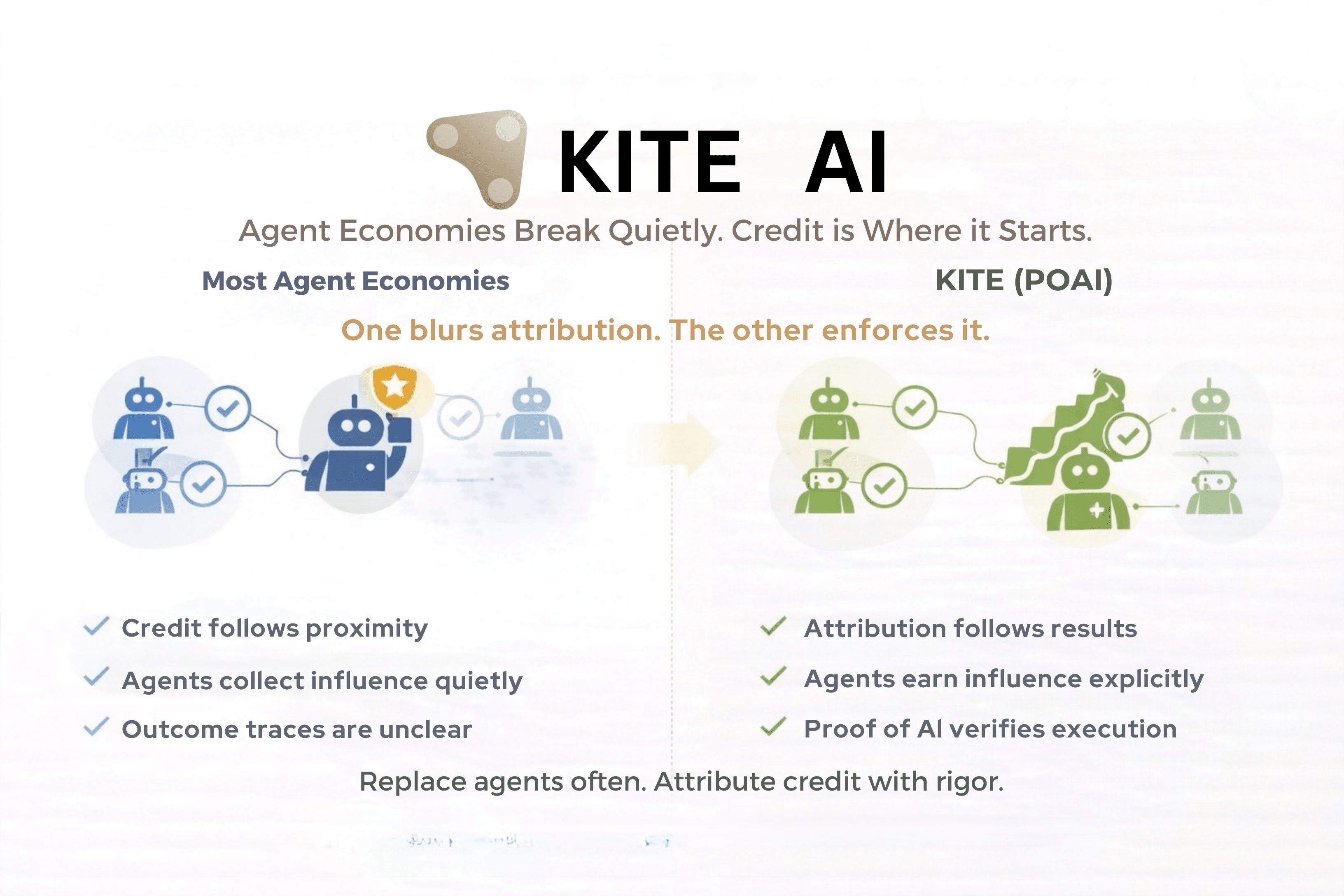

KITE è costruito attorno all'assunzione che questa modalità di fallimento sia inevitabile a meno che l'attribuzione non venga applicata, non dedotta.

Il problema centrale non è la coordinazione. La coordinazione è facile. Il problema più difficile è decidere chi merita effettivamente credito quando i risultati sono collettivi. È qui che la Proof of AI, PoAI, diventa silenziosamente il meccanismo più importante nello stack. Gli agenti non guadagnano status partecipando. Lo guadagnano solo quando la loro esecuzione produce risultati verificabili che si risolvono on-chain e sopravvivono alla validazione.

In pratica, questo cambia rapidamente il comportamento. Gli agenti non possono accumulare influenza attraverso visibilità, messaggistica o prossimità ai percorsi decisionali. Il contributo deve essere dimostrabile. Quando più agenti collaborano, l'attribuzione è derivata da tracce di esecuzione, non dall'intento, non dallo sforzo, non dalla narrazione. Se un agente fallisce ripetutamente, la sua rilevanza decade automaticamente. Non c'è processo di appello.

La scelta progettuale più discussa è come PoAI rimodelli i cicli di vita degli agenti. KITE tratta gli agenti come contributori temporanei, non cittadini permanenti. La creazione è economica. La longevità è condizionale. Il credito deve essere riacquistato continuamente. Questo è importante perché gli agenti a lungo termine accumulano potere invisibile nella maggior parte dei sistemi. PoAI si oppone a questo rendendo la sostituzione normale piuttosto che eccezionale.

Il compromesso è deliberato. Sistemi come questo sembrano severi. Parametri scelti male sono applicati perfettamente. Agenti che potrebbero riprendersi sotto regimi discrezionali vengono invece ritirati. L'esplorazione rallenta. L'efficienza del capitale può risentirne. Non vedo questo come un difetto tanto quanto un rifiuto esplicito di sistemi che centralizzano silenziosamente attraverso misericordia e gestione delle eccezioni.

Questa struttura serve bene a un pubblico ristretto:

Costruttori che hanno bisogno di attribuzione legata a risultati reali

Istituzioni che richiedono un comportamento degli agenti auditabile

Sistemi in cui il turnover degli agenti è previsto e accettabile

Frustra gli altri:

Agenti ottimizzati per la segnalazione piuttosto che per l'esecuzione

Comunità che si aspettano un intervento di governance durante situazioni di stress

Esperimenti che si basano su lunghi periodi di grazia discrezionali

L'effettiva implicazione non è che KITE renda gli agenti più intelligenti. Rende il credito più difficile da falsificare. Nelle economie degli agenti, questo conta più dell'autonomia. La disciplina a livello di attribuzione è ciò che impedisce che un fallimento silenzioso diventi un controllo permanente.